包阅导读总结

1. 关键词:PyTorch、AI、LLMs、training、inference

2. 总结:

该文本主要介绍了 PyTorch 在 LLMs 方面的新进展,包括其对 LLM 生命周期各方面的增强。软件工程师和研究科学家共同探讨了新的功能和工具,涵盖内存高效微调及设备端 LLM 能力等。

3. 主要内容:

– 介绍 PyTorch 对 AI 训练和推理的作用

– 讲述 PyTorch 在 LLMs 方面的新进展

– 软件工程师 Wanchao Liang、Evan Smothers 与 Meta 研究科学家 Kimish Patel 参与讨论

– 探讨最新功能和工具

– 讨论内容

– 强调内存高效微调的重要性及相关技术,以实现在消费级硬件上的微调

– 探讨大型模型在设备端部署的挑战及量化等技术如何解决这些部署问题

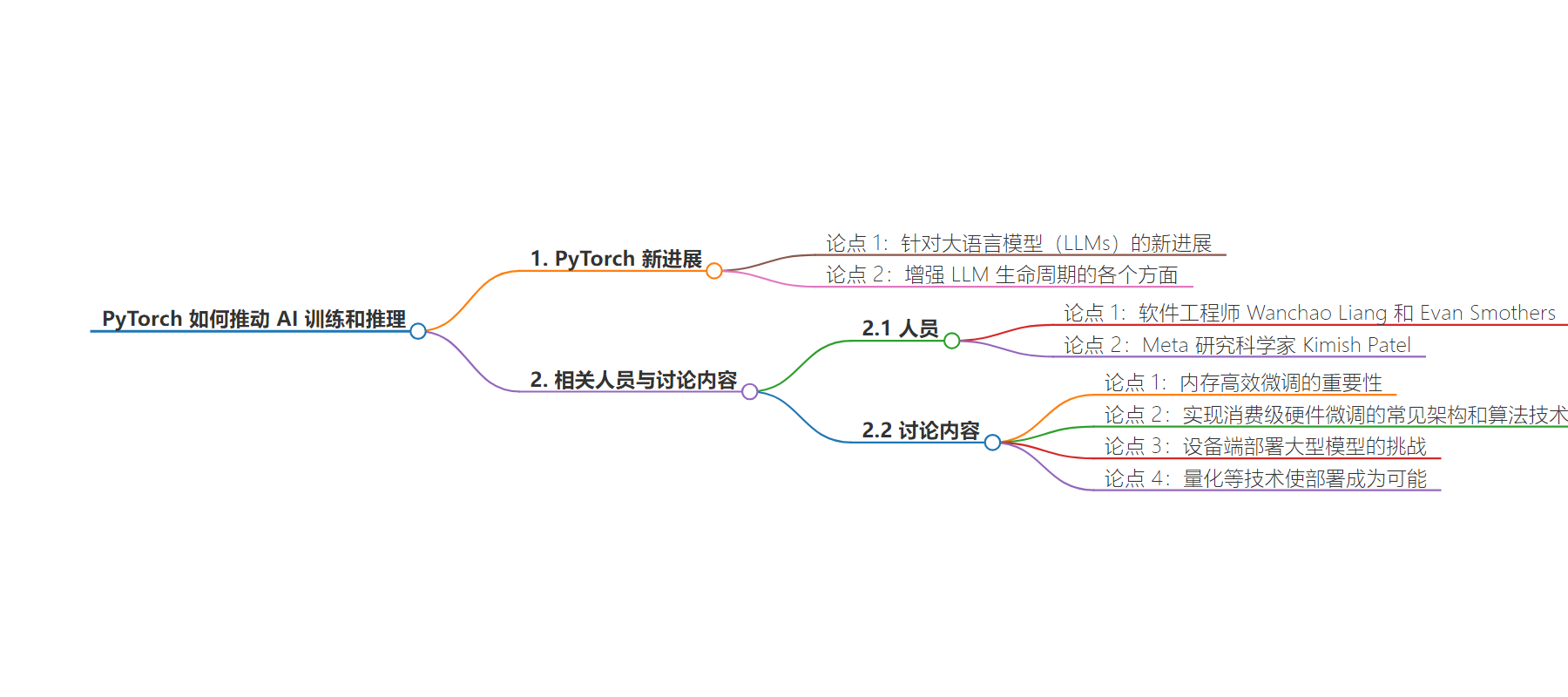

思维导图:

文章地址:https://engineering.fb.com/2024/08/23/ml-applications/pytorch-ai-training-inference/

文章来源:engineering.fb.com

作者:Engineering at Meta

发布时间:2024/8/23 16:08

语言:英文

总字数:104字

预计阅读时间:1分钟

评分:86分

标签:PyTorch,AI 训练,推理,大型语言模型,内存效率

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

Learn about new PyTorch advancements for LLMs and how PyTorch is enhancing every aspect of the LLM lifecycle.

In this talk from AI Infra @ Scale 2024, software engineers Wanchao Liang and Evan Smothers are joined by Meta research scientist Kimish Patel to discuss our newest features and tools that enable large-scale training, memory efficient fine-tuning, and on-device LLM capabilities.

First, they cover the importance of memory-efficient fine-tuning and a few common architectural and algorithmic techniques to enable fine-tuning on consumer-grade hardware. Then they discuss the challenges of deploying large models for on-device deployment and how techniques such as quantization make these deployments possible.

VIDEO