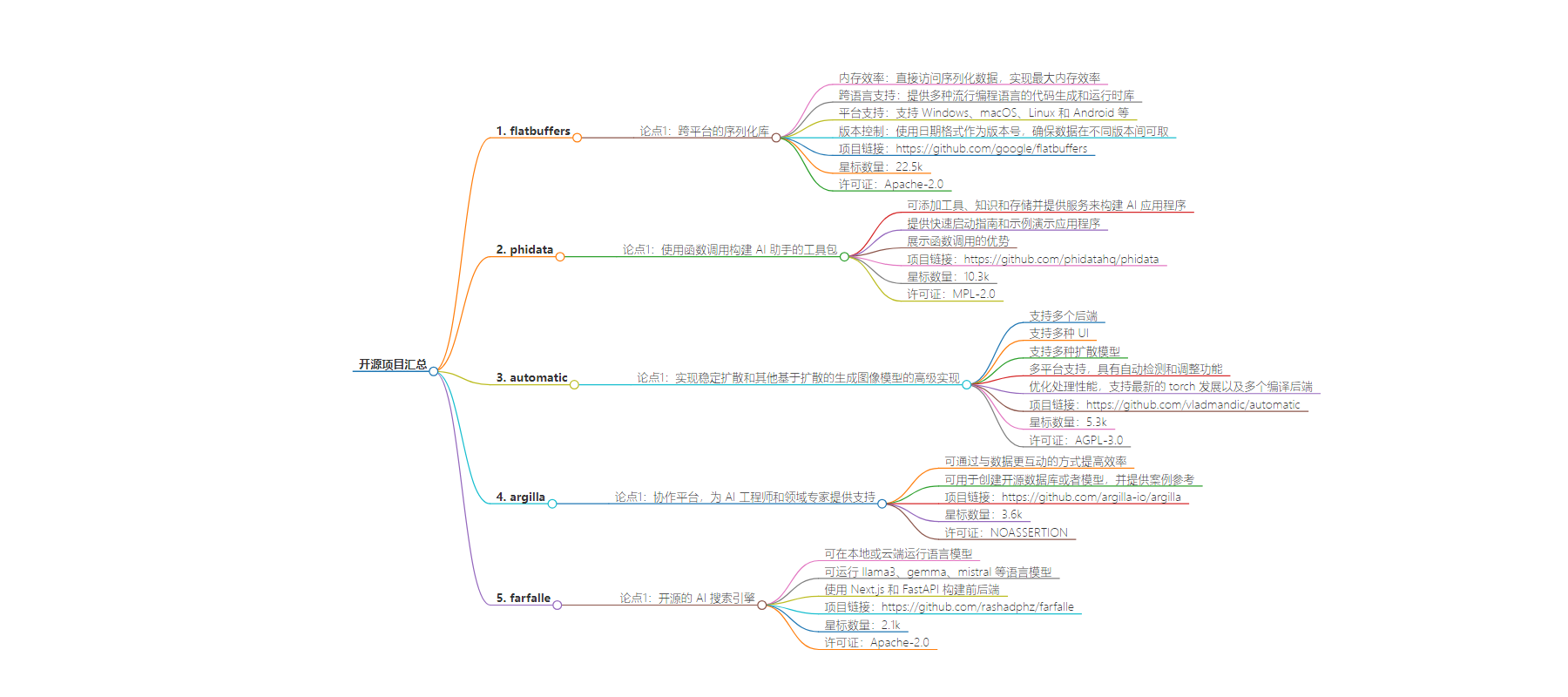

包阅导读总结

1. 开源、序列化库、跨平台、内存效率、AI 工具

2. 本文介绍了谷歌的 flatbuffers 序列化库及一些开源项目,包括构建 AI 助手的 phidata、生成图像模型的 automatic、协作平台 argilla 和 AI 搜索引擎 farfalle,涵盖了它们的功能、特性及优势。

3.

– 谷歌 flatbuffers

– 跨平台的序列化库

– 最大内存效率,直接访问序列化数据

– 多种语言和平台支持

– 版本控制

– phidata

– 构建 AI 助手的工具包

– 可添加工具、知识和存储

– 提供服务构建 AI 应用程序

– 有快速启动指南和示例演示

– vladmandic/automatic

– 实现多种扩散生成图像模型

– 支持多后端、多 UI、多模型

– 多平台支持,自动检测和调整

– 优化处理性能,支持多种编译后端

– argilla-io/argilla

– 协作平台

– 支持 AI 工程师和领域专家

– 提高数据和模型迭代效率

– 可创建开源数据库或模型

– rashadphz/farfalle

– 开源 AI 搜索引擎

– 本地或云端运行语言模型

– 支持多种语言模型

– 使用 Next.js 和 FastAPI 构建前后端

思维导图:

文章地址:https://mp.weixin.qq.com/s/a4WXQedyE-6qA4bCYLyoGA

文章来源:mp.weixin.qq.com

作者:帅比柒

发布时间:2024/6/29 17:14

语言:中文

总字数:787字

预计阅读时间:4分钟

评分:81分

标签:

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

google/flatbuffershttps://github.com/google/flatbuffers

Stars: 22.5k License: Apache-2.0

flatbuffers 是一个跨平台的序列化库,旨在实现最大内存效率。它允许您直接访问序列化数据而无需先进行解析/拆包,同时具有很好的向前/向后兼性。以下是 flatbuffers 项目的主要功能、关键特性核心优势:

-

内存效率:flatbuffers 通过直接访问序列化数据而不需要解析,实了最大内存效率。 -

跨语言支持:提供种流行编程语言的代码生成和运行时库。 -

平台支持:支 Windows、macOS、Linux 和 Android 等多个平台。 -

版本控制:使用日期格式作为版本号,并确保数据可在不同语言和模式版本间取。

phidatahq/phidatahttps://github.com/phidatahq/phidata

Stars: 10.3k License: MPL-2.0

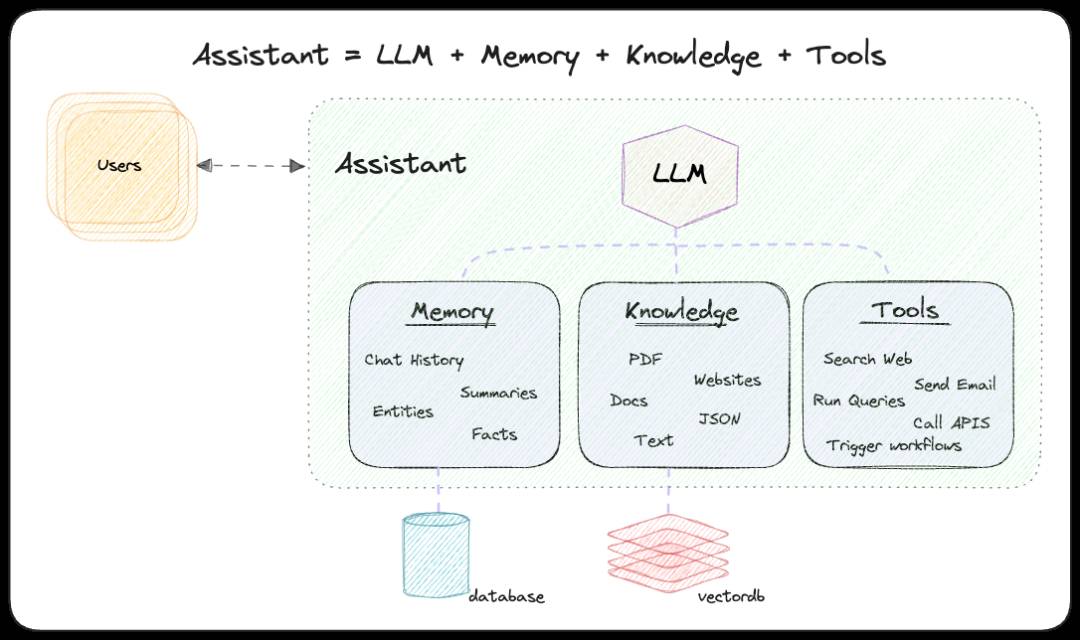

phidata 是一个使用函数调用构建 AI 助手的工具包。

-

添加工具(函数)、知识(vectordb)和存储(数据库) -

使用 Streamlit、FastApi 或 Django 提供服务来构建您的 AI 应用程序 -

提供快速启动指南和示例演示应用程序展示了函数调用的优势

vladmandic/automatichttps://github.com/vladmandic/automatic

Stars: 5.3k License: AGPL-3.0

automatic 是一个实现了稳定扩散和其他基于扩散的生成图像模型的高级实现。

-

支持多个后端,包括 Diffusers 和 Original -

支持多种 UI,包括 Standard 和 Modern -

支持多种扩散模型,如 Stable Diffusion、SD-XL、LCM 等等 -

多平台支持,包括 Windows、Linux 和 MacOS 等等,并且具有自动检测和调整功能 -

优化处理性能,并支持最新的 torch 发展以及多个编译后端:Triton, ZLUDA, StableFast 等等

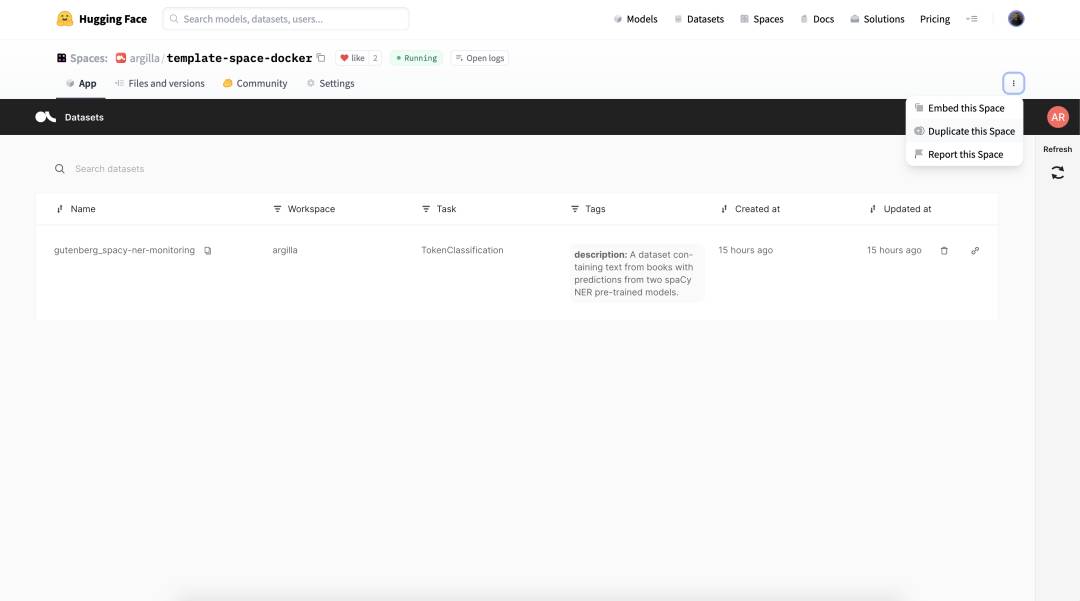

argilla-io/argillahttps://github.com/argilla-io/argilla

Stars: 3.6k License: NOASSERTION

argilla 是一个协作平台,为需要高质量输出、完全数据所有权和整体效率的 AI 工程师和领域专家提供支持。主要功能、关键特性、核心优势:

-

通过与数据更互动的方式快速迭代正确的数据和模型,从而提高效率。 -

可以用于创建开源数据库或者模型,并且有很多案例可以参考。

rashadphz/farfallehttps://github.com/rashadphz/farfalle

Stars: 2.1k License: Apache-2.0

farfalle 是一个开源的 AI 搜索引擎,可以在本地或云端运行语言模型。farfalle 解决的核心问题是提供自托管的本地或云端语言模型搜索引擎。

-

可以在本地或云端运行 LLM (llama3, gemma, mistral) 语言模型。 -

使用 Next.js 和 FastAPI 构建前后端。