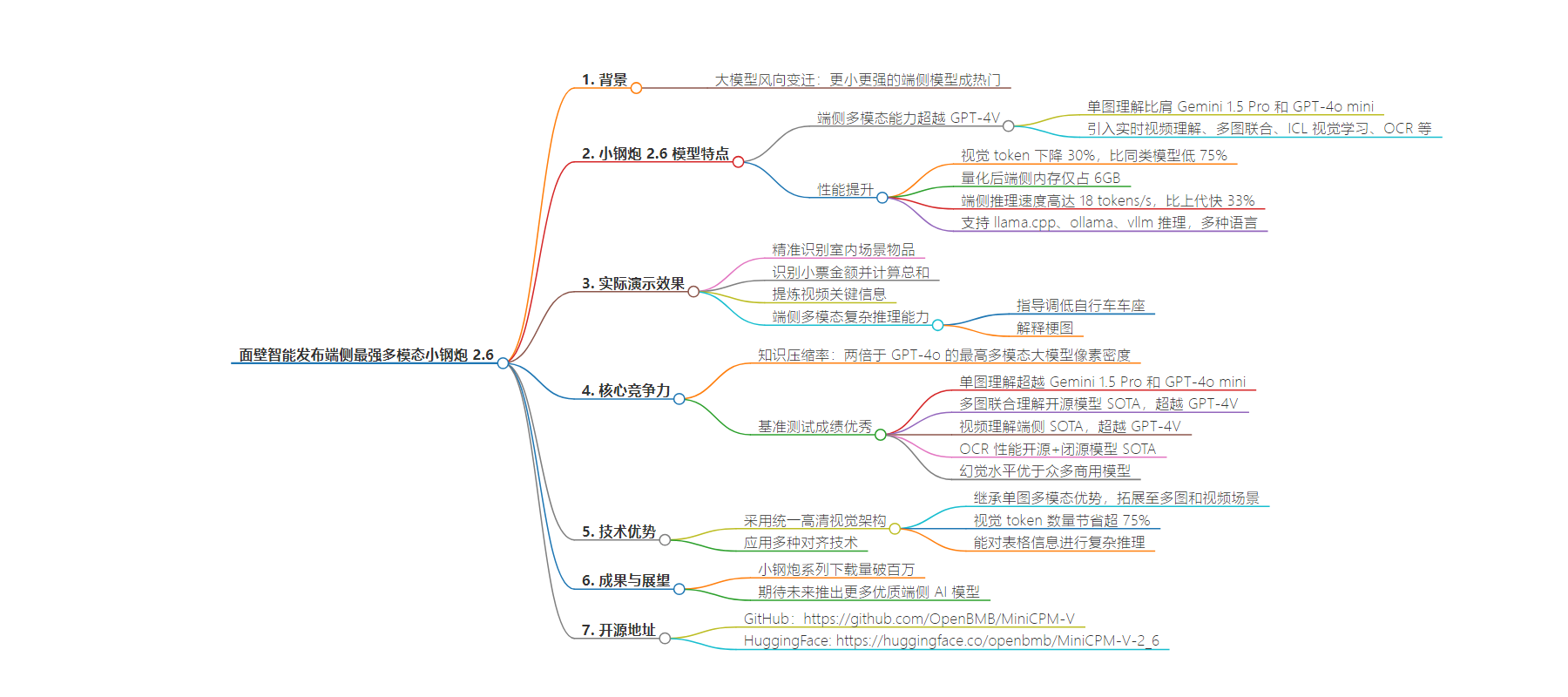

包阅导读总结

1. 面壁智能、小钢炮 2.6、端侧模型、多模态、GPT-4V

2. 面壁智能发布端侧最强多模态模型小钢炮 2.6,在单图、多图、视频理解等方面超越 GPT-4V,具有实时视频理解等新能力,运行效率高,下载量已破百万,并开源。

3.

– 面壁智能因被抄袭刷了一波存在感,展现出在 AI 领域的实力

– 重磅推出小钢炮 MiniCPM-V 2.6 模型

– 端侧多模态能力全面提升,超越 GPT-4V

– 首次实现端侧单图、多图、视频理解等多模态核心能力超越 GPT-4V

– 引入实时视频理解等新功能

– 视觉 token 下降,量化后端侧内存小,推理速度快,支持多种语言和推理方式

– 各项评测成绩优秀

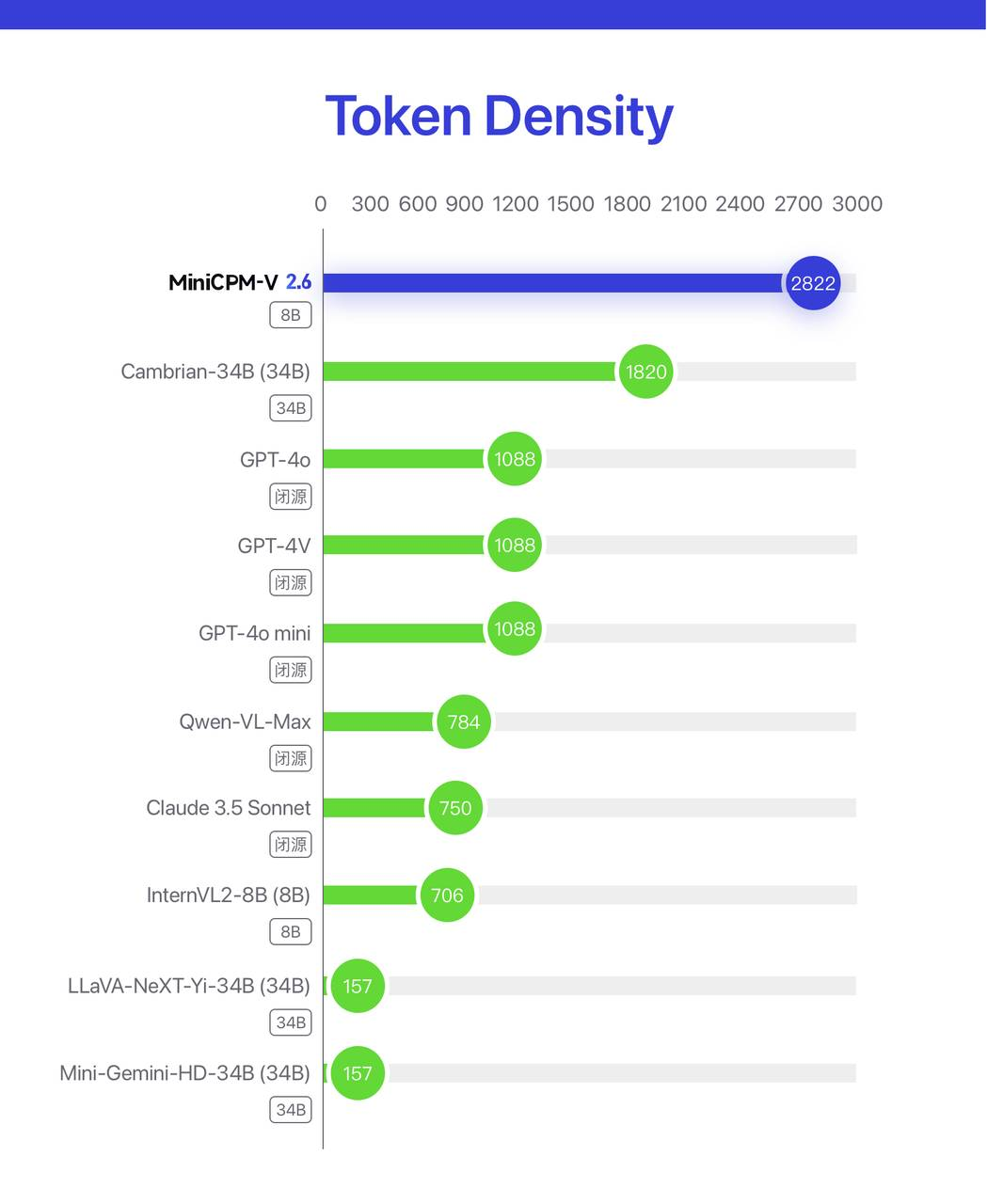

– Token Density 最高

– 单图理解超越 Gemini 1.5 Pro 和 GPT-4o mini

– 多图联合理解开源模型 SOTA,超越 GPT-4V

– 视频理解能力端侧 SOTA,超越 GPT-4V

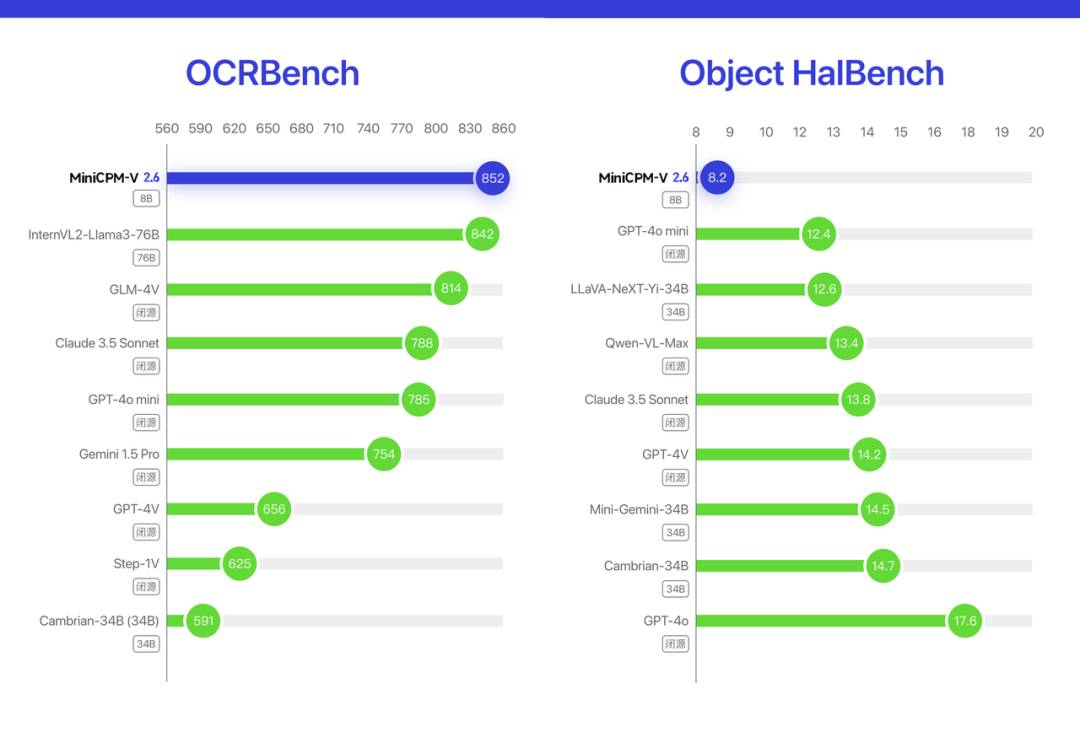

– OCR 性能和幻觉水平表现出色

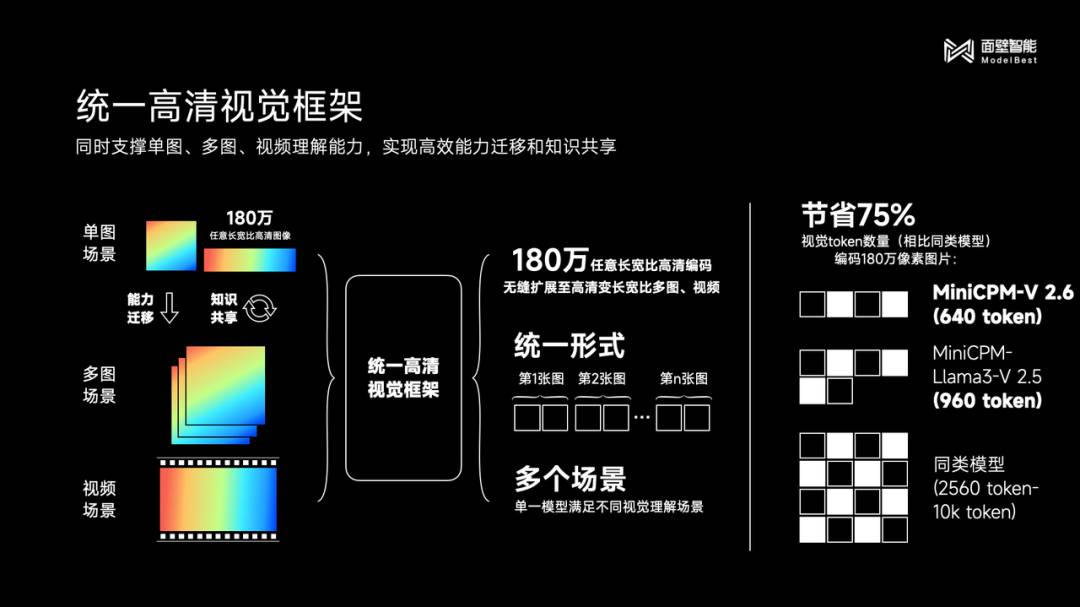

– 采用统一高清视觉架构,优势众多

– 小钢炮系列下载量破百万,未来有望推出更多优质端侧 AI 模型

– 附上小钢炮 2.6 开源地址

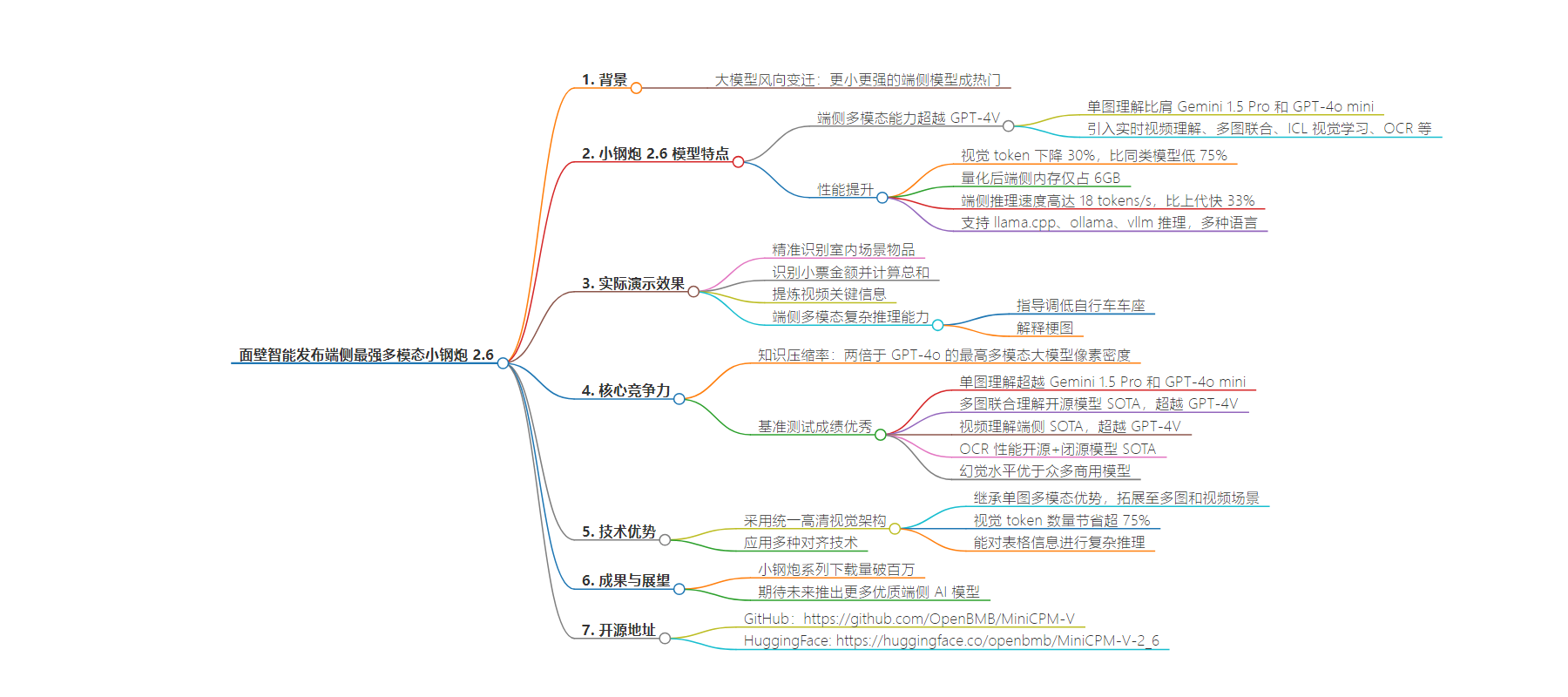

思维导图:

文章地址:https://mp.weixin.qq.com/s/ko9Ks1qZF3tdNt3sD_IWig

文章来源:mp.weixin.qq.com

作者:发现明日产品的

发布时间:2024/8/6 10:45

语言:中文

总字数:2122字

预计阅读时间:9分钟

评分:91分

标签:多模态模型,端侧 AI,实时视频理解,面壁智能,GPT-4V

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

手机上能跑的 GPT-4V!面壁发布端侧最强多模态小钢炮 2.6,实时视频理解首次上端

过去半年,大模型的风向悄然变迁,与以往不断追求规模的趋势不同,更小更强的端侧模型成了当下的香饽饽。

前不久,在遭到斯坦福大学 AI 团队抄袭后,头部大模型厂商面壁智能在国内外狠狠地刷了一波存在感,也让我们见识到了这家公司在 AI 领域的不凡实力。

今天,面壁智能重磅上新了「小钢炮」 MiniCPM-V 2.6 模型,再次将端侧多模态能力提升到一个新的高度。

尽管该模型仅有 8B 参数,但它在 20B 以下单图、多图、视频理解取得了 3 SOTA 成绩,一举将端侧 AI 多模态能力拉升至全面对标超越 GPT-4V 水平。

首次在端侧实现单图、多图、视频理解等多模态核心能力全面超越 GPT-4V,单图理解越级比肩 Gemini 1.5 Pro 和 GPT-4o mini。

引入实时视频理解、多图联合、ICL视觉学习、OCR等,开启端侧模型真实世界观察与学习。

小钢炮 2.6 取得了两倍于 GPT-4o 的单 token 编码像素密度。视觉 token相比上一代下降 30% ,比同类模型低 75%。

量化后端侧内存仅占 6 GB;端侧推理速度高达 18 tokens/s,相比上代模型快 33%。并且发布即支持 llama.cpp、ollama、vllm 推理;且支持多种语言。

「长眼睛」的实时视频理解首次上端,让智能设备更懂你

先来感受一下 MiniCPM-V 2.6 模型的实际演示效果。

视频中显示,在多模态能力的加持下,MiniCPM-V 2.6 犹如长了一双「眼睛」,能够实时看到真实世界。在开启飞行模式的情况下,搭载该模型的端侧设备能够精准地识别面壁智能公司的室内场景。

从面壁智能公司的 Logo、到植物、办公桌、饮水机等物品,MiniCPM-V 2.6 的物品识别能力表现得毫无压力,甚至可以说是游刃有余。

面对小票繁多的记账或报销流程,只需拍照上传至 MiniCPM-V 2.6,它不仅能够识别出每张小票的具体金额,还能计算出总和,极大地简化了整个流程。

得益于其先进的 OCR 和 CoT(思维链)技术,MiniCPM-V 2.6 不仅能准确捕捉小票上的金额,还能以清晰简洁的方式呈现解题过程。

对于「太长不看」的视频,现在你可以直接让该模型为你提炼关键信息。

比如面对一段 1 分钟左右的天气预报视频,MiniCPM-V 2.6 可以在无声的条件下,用「肉眼」识别并描述不同城市的具体天气情况。

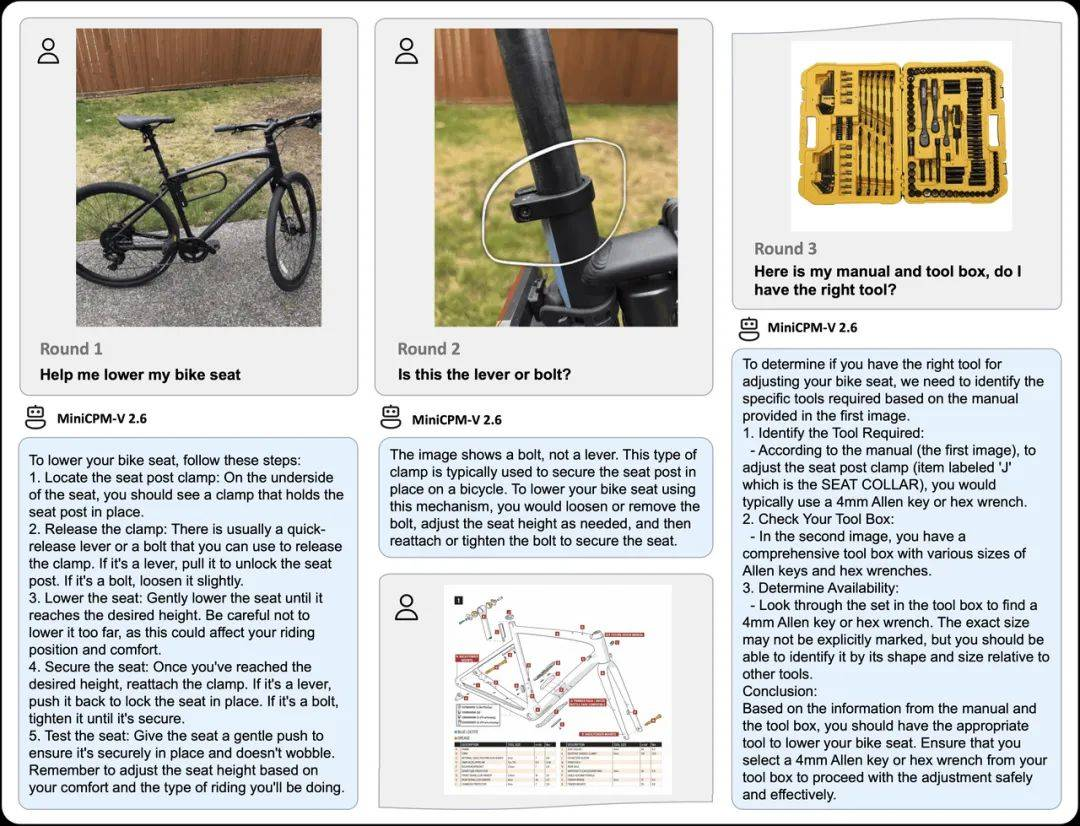

MiniCPM-V 2.6 的端侧多模态复杂推理能力也有所「长进」。

以 GPT-4V 经典的官方演示——调整自行车车座为例,MiniCPM-V 2.6 能通过多轮对话清晰指导用户调低自行车车座,并根据说明书和工具箱推荐合适的工具。

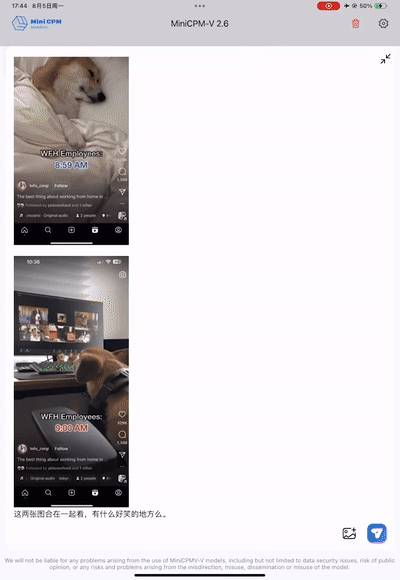

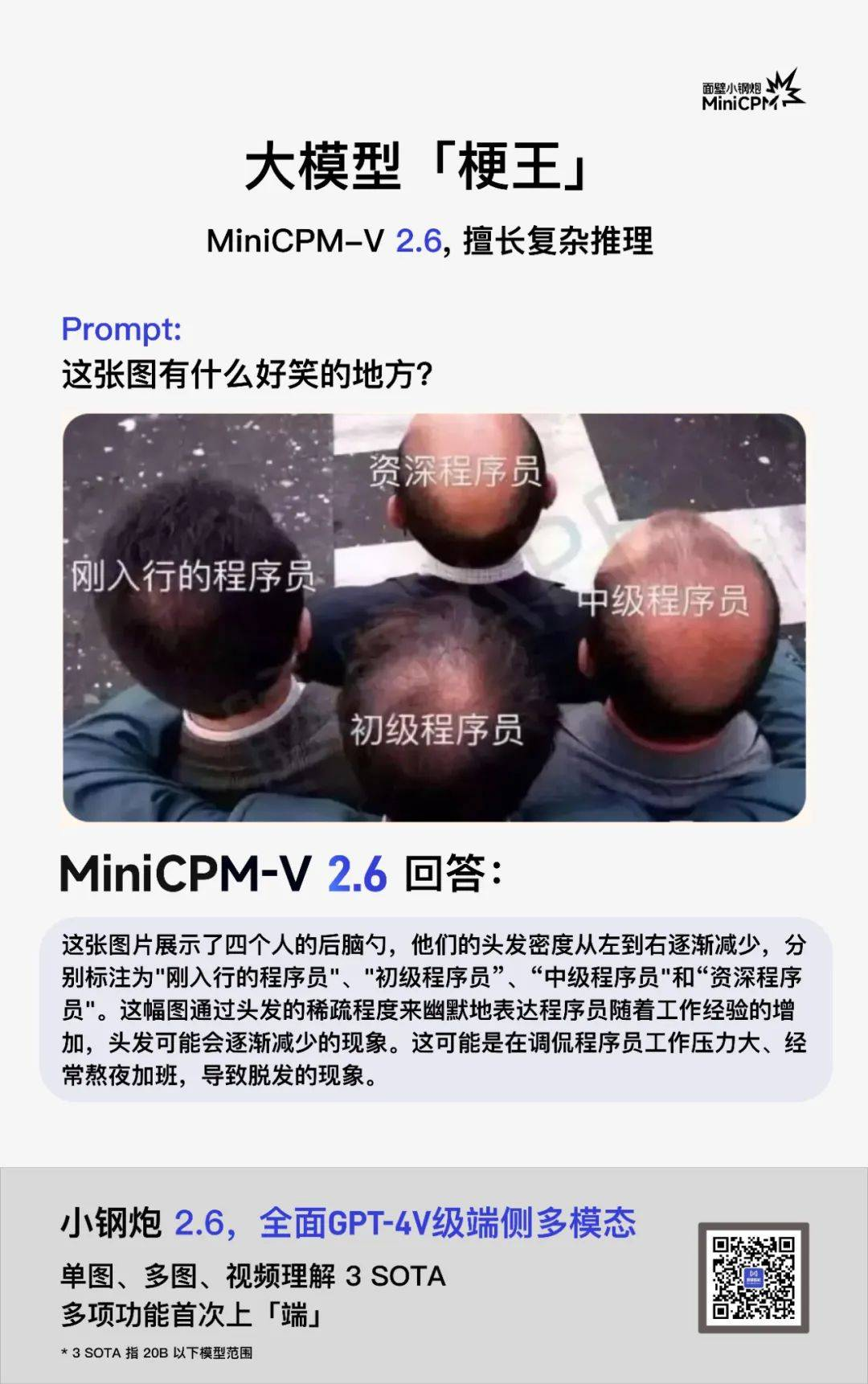

又或者, 2G 网速的你看不懂年轻人广为传播的梗图,那不妨让其耐心地给你解释梗图背后的槽点。

甚至它还能比人类更有幽默细胞,捕捉到梗图中的潜台词。作为程序员的你也许看着这张图,笑着笑着就哭了。

以小胜大,MiniCPM-V 2.6 号称三合一最强端侧多模态

据面壁智能官方介绍,在 MiniCPM-V 2.6 的知识压缩率方面,MiniCPM-V 2.6 取得了两倍于 GPT-4o 的最高多模态大模型像素密度(Token Density) 。

Token Density = 编码像素数量 / 视觉 token 数量,是指单个 token 承载的像素密度即图像信息密度,直接决定了多模态模型实际的运行效率,数值越大,模型运行效率越高。

闭源模型的 Token Density 由 API 收费方式估算得到。结果表明 MiniCPM-V 2.6 是所有多模态模型中 Token Density 最高的,延续了其一贯的极致高效特点。

从分享的基准测试结果来看, MiniCPM-V 2.6 在综合评测权威平台 OpenCompass 上,单图理解能力越级超越 Gemini 1.5 Pro 和 GPT-4o mini。

在多图评测平台 Mantis-Eval 榜单上,MiniCPM-V 2.6 多图联合理解能力实现开源模型SOTA ,且超越 GPT-4V。在视频评测平台 Video-MME 榜单上,MiniCPM-V 2.6 的视频理解能力达到端侧 SOTA,超越 GPT-4V。

OpenCompass | Mantis-Eval | Video-MME 榜单成绩

此外,MiniCPM-V 2.6 OCR 性能在 OCRBench上实现开源+闭源模型 SOTA。

在幻觉评测榜单 Object HalBench 上,MiniCPM-V 2.6 的幻觉水平(幻觉率越低越好)也都优于 GPT-4o、GPT-4V、Claude 3.5 Sonnet 等众多商用模型。

OCRBench |Obiect HalBench 榜单成绩

新一代小钢炮 MiniCPM-V 2.6 交出优秀成绩单的背后,主要归功于其采用了统一高清视觉架构。

官方表示,统一高清视觉框架,不仅继承了传统单图的多模态优势功能,更实现了一通百通。

例如,OCR SOTA 能力 将 MiniCPM-V 单图场景的「180 万高清图像解析」进行能力迁移和知识共享,无缝拓展至多图场景和视频场景,并将这三种视觉理解场景统一形式化为图文交替的语义建模问题,共享底层视觉表示机制,实现相比同类型模型,视觉 token 数量节省超过 75% 。

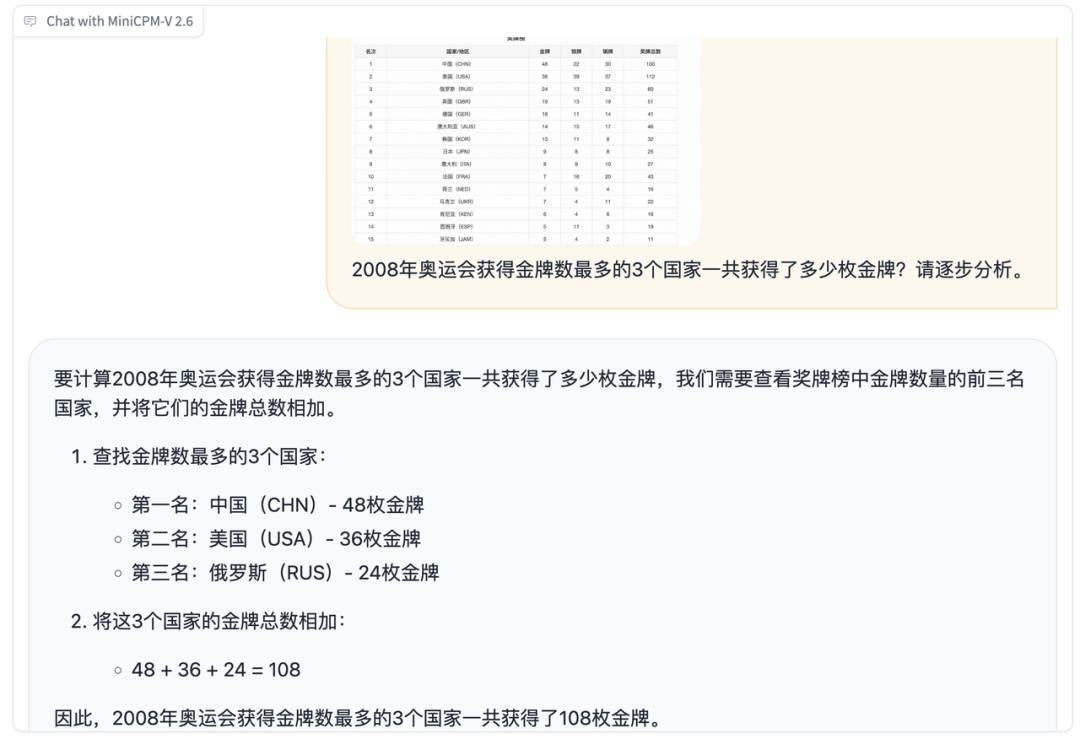

在 OCR 信息提取的基础上,MiniCPM-V 2.6 还能进一步对表格信息进行类似 CoT(思维链)的复杂推理。

以 2008 年奥运会为例,该模型能够计算出获得金牌数最多的三个国家共获得的金牌总数。

利用 OCR 能力识别并提取奖牌榜中金牌数量的前三名国家;

在 AI 可信度方面,MiniCPM-V 2.6 以 8.2% 的幻觉率,延续了小钢炮系列的传统优势。此外,面壁 RLAIF-V 的对齐技术,以及 Ultra 系列对齐技术的应用等技术也都是藏在 MiniCPM-V 2.6 背后的黑科技。

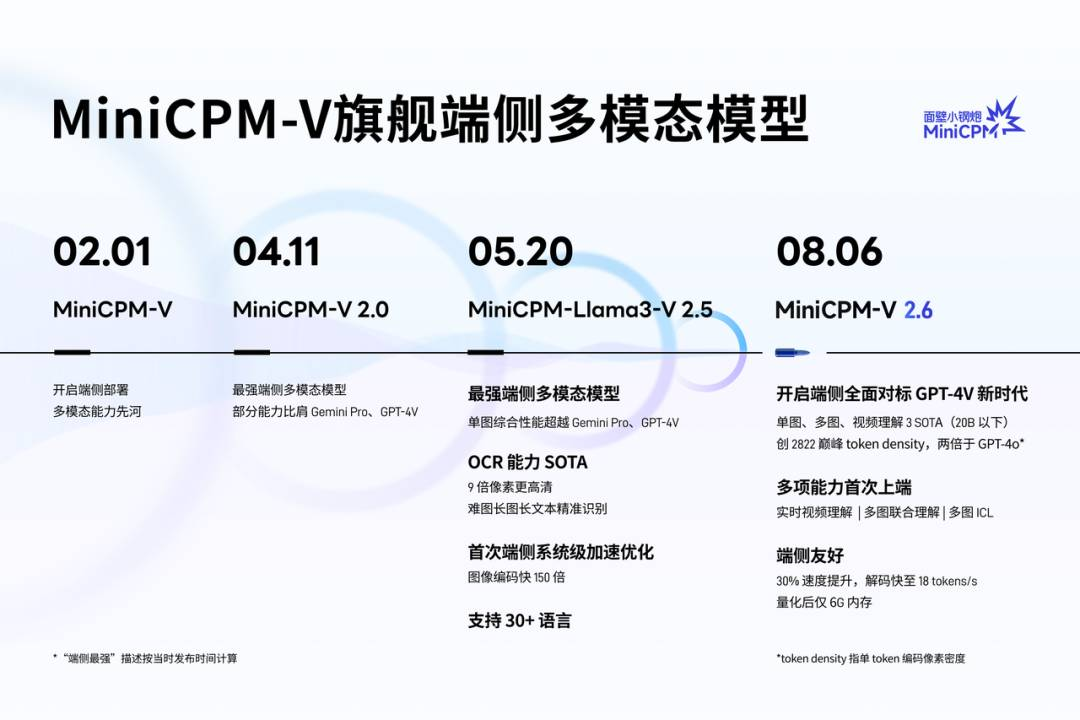

官方数据显示,小钢炮系列下载量已破百万。从开启端侧部署,多模态能力先河,到最强端侧多模态模型,再到端侧全面对标 GPT-4V 的新时代,面壁智能只用了短短半年的时间。

「聪明、流畅,快得不像一款端侧模型!」这句话,是对小钢炮系列最贴切的描述。

给面壁智能更多时间、也给国内场外大模型厂商更多时间,我们坚信未来面壁智能将继续推出更多优质的端侧 AI 模型,与国内外大模型厂商一同推动端侧 AI 的发展。

而在这个过程中,独立开发者和普通用户都将成为最大的受益者。

GitHub:https://github.com/OpenBMB/MiniCPM-V

HuggingFace: https://huggingface.co/openbmb/MiniCPM-V-2_6

预览时标签不可点

![]()

微信扫一扫

关注该公众号

![]()

微信扫一扫

使用小程序

:,。视频小程序赞,轻点两下取消赞在看,轻点两下取消在看分享收藏