包阅导读总结

1. 蚂蚁集团、机器学习、论文入选、人工智能、技术创新

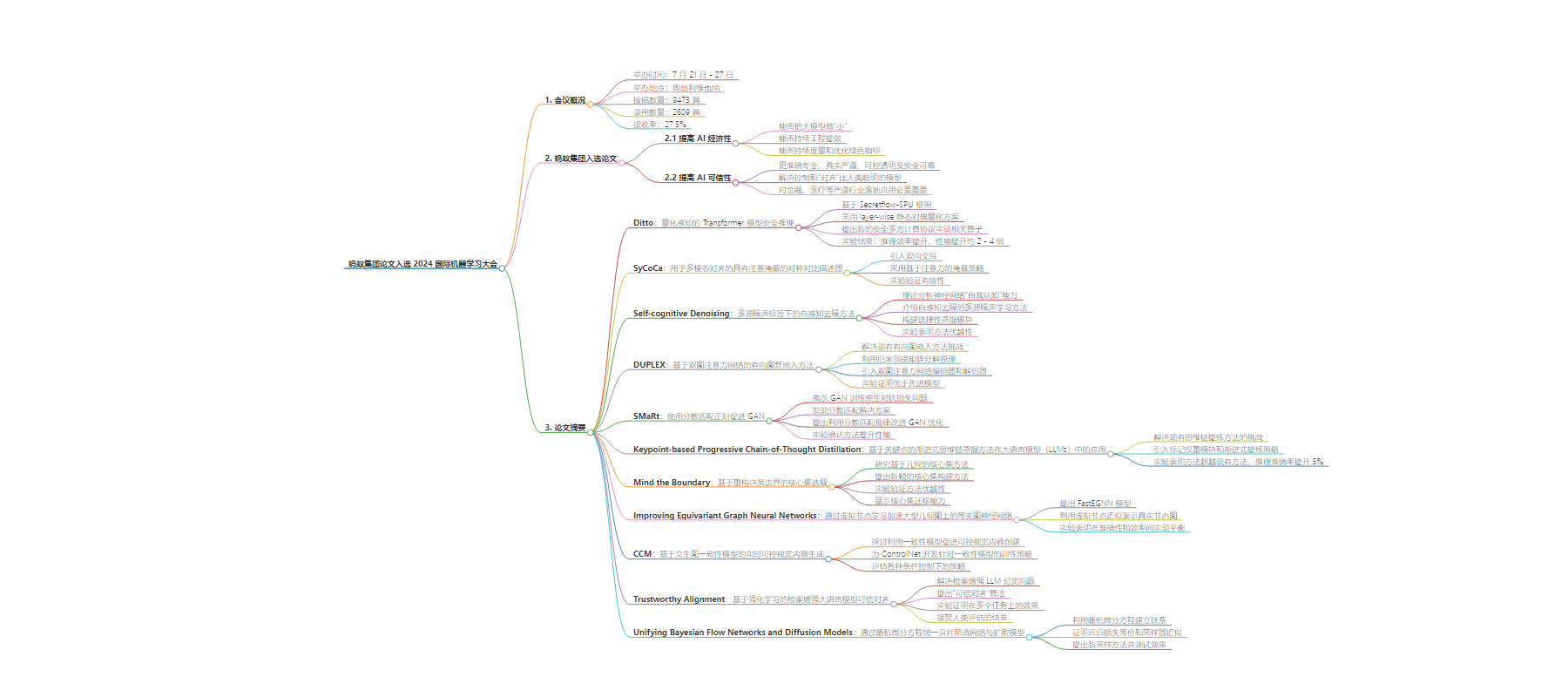

2. 2024 国际机器学习大会在奥地利维也纳举办,蚂蚁集团有 11 篇论文入选。论文涵盖多个人工智能和机器学习领域前沿主题,聚焦提高 AI 的经济性和可信性,在多个方面实现技术创新。

3.

– 国际机器学习大会

– 时间:7 月 21 日-27 日

– 地点:奥地利维也纳

– 投稿情况:9473 篇有效投稿,录用 2609 篇,接收率 27.5%

– 蚂蚁集团论文

– 数量:11 篇

– 覆盖领域:图机器学习、网络/信息安全、人工智能、计算机视觉等

– 技术问题聚焦:提高 AI 的经济性和可信性

– 部分论文摘要

– Ditto:实现量化感知的 Transformer 模型密态推理

– SyCoCa:用于多模态对齐的对称对比描述器

– Self-cognitive Denoising:多源噪声标签下的自感知去噪方法

– DUPLEX:基于双图注意力网络的有向图复嵌入方法

– SMaRt:使用分数匹配正则促进 GAN

– Keypoint-based Progressive Chain-of-Thought Distillation:基于关键点的渐进式思维链蒸馏方法在大语言模型中的应用

– Mind the Boundary:基于重构决策边界的核心集选取

– Improving Equivariant Graph Neural Networks:通过虚拟节点学习加速大型几何图上的等变图神经网络

– CCM:基于文生图一致性模型的实时可控视觉内容生成

– Trustworthy Alignment:基于强化学习的检索增强大语言模型可信对齐

– Unifying Bayesian Flow Networks:通过随机微分方程统一贝叶斯流网络与扩散模型

思维导图:

文章地址:https://mp.weixin.qq.com/s/F5-lOaNfozPNGsBja2MdnQ

文章来源:mp.weixin.qq.com

作者:蚂蚁技术 AntTech

发布时间:2024/7/23 2:59

语言:中文

总字数:6416字

预计阅读时间:26分钟

评分:87分

标签:人工智能,大模型,多模态学习,安全计算,机器学习

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

当地时间7月21日-27日,2024国际机器学习大会(ICML2024)在奥地利维也纳举办。本届会议共有9473篇有效论文投稿,创历史新高,组委会最终录用了2609篇,接收率为27.5%。蚂蚁集团此次有11篇论文入选。

国际机器学习大会是全球机器学习领域的权威会议,迄今举办了41次会议。组委会成员来自卡内基梅伦大学、剑桥大学、谷歌、苹果等世界名校及全球知名科技企业。

蚂蚁被录用的论文覆盖图机器学习、网络/信息安全、人工智能、计算机视觉等多个人工智能和机器学习领域的前沿主题。论文试图改进和优化的技术问题,则聚焦在提高AI的经济性和可靠性上。

提高AI的经济性,主要看是否能把大模型做“小”,是否能持续工程提效,以及是否能持续度量和优化绿色指标,这决定大模型应用能否能成为主流。

提高AI的可信性,则是要让AI更准确专业、真实严谨、可控透明及安全可靠,终极目标是解决控制和“对齐”比人类聪明的模型。这对于AI在金融、医疗等严谨行业的落地应用尤为必要与重要。

以下为11篇论文的摘要。

Ditto:Quantization-aware Secure Inference of Transformers upon MPC/Ditto:量化感知的Transformer模型安全推理

论文链接:

https://openreview.net/pdf?id=ZzXNCQGzqT

Ditto是蚂蚁隐语团队针对大模型密态推理场景展开的一个研究工作:“Ditto can transform to different quantization settings.”该论文基于Secretflow-SPU框架实现了量化感知的Transformer模型密态推理,基于安全多方计算技术对大模型推理中的模型参数以及用户输入提供可证安全保护。

本文在先前隐语和蚂蚁技术研究院合作的工作PUMA基础之上,受到明文场景中常用的量化技术的启发,Ditto尝试将不同精度的量化运算应用在密态计算领域。然而,由于cost model的不同,简单地套用明文量化并不能带来显著的性能提升,甚至是负收益。

针对此问题,Ditto采用了layer-wise 静态对偶量化方案,设计并实现了量化感知的编译器,能够自动地根据前端数据类型,执行不同精度的后端密态运算。此外,为了支持密态计算下的数据类型切换,Ditto提出了新的安全多方计算协议实现相关算子,能够以更高的效率实现密态数据类型的切换,进而带来更优的密态推理性能。

得益于底层的Secretflow-SPU框架,Ditto能够轻松地从Huggingface导入训练好的模型,无缝地由明文推理切换到安全推理。我们在经典模型Bert和GPT2上进行了实验,实验结果表明,Ditto可以在不显著降低 模型可用性的情况下实现推理效率的提升,性能相较最新工作提升约2~4倍。

SyCoCa:Symmetrizing Contrastive Captioners with Attentive Masking for Multimodal Alignment / SyCoCa:用于多模态对齐的具有注意掩蔽的对称对比描述器

论文链接:

https://www.semanticscholar.org/reader/0833d5b8c46fe7391e7decc3f11fea87e023d710

语言和视觉之间的多模式对齐是当前视觉语言模型研究的基本课题。对比描述器(ContrastiveCaptioner,CoCa)作为一种具有代表性的方法,将对比语言图像预训练(ContrastiveLanguage-ImagePretraining,CLIP)和图像描述(ImageCaption,IC)整合到一个统一的框架中,取得了令人印象深刻的效果。

CLIP对整个图像和句子的全局表示施加了双向约束。尽管IC在局部表示上进行单向的图像到文本生成,但它对局部文本到图像的重建缺乏任何约束,这限制了在与文本对齐时以细粒度水平理解图像的能力。

为了从全局和局部两个角度实现多模态对齐,本文提出了对称对比描述器(SymmetrizingContrastiveCaptioners,SyCoCa),它引入了图像和文本在全局和局部表示水平上的双向交互。

具体来说,我们在ITC和IC的基础上扩展了文本引导掩蔽图像建模(Text-Guided Masked Image Modeling,TG-MIM)任务。改进的SyCoCa进一步利用文本线索来重构上下文图像,并利用视觉线索来预测文本内容。当实现双向局部交互时,图像的局部内容往往是杂乱的,或者与它们的文本描述无关。

因此,我们采用了一种基于注意力的掩蔽策略来选择有效的图像补丁进行交互。我们在五个视觉语言任务上的大量实验,包括图像文本检索、图像描述、视觉问答和零样本/微调图像分类,验证了我们提出的方法的有效性。

首先提出了用于多模态对齐的对称对比描述器,从全局和局部角度提高了图像和文本之间的相互理解。

为了促进双向局部交互,我们采用了一种基于注意力的图像掩蔽策略,分别为图像描述任务和文本引导的掩蔽图像建模任务选择合适的图像块。

实验验证了我们提出的SyCoCa在几个下游任务上优于CoCa,例如,图像文本检索、图像描述、视觉问答和图像分类。例如,与图像文本检索任务中的CoCa相比,我们在Flicker-30k上获得了+5.1%/3.7%的mTR/mIR增益。

Self-cognitive Denoising in the Presence of Multiple Noisy Label Sources/ 多源噪声标签下的自感知去噪方法

https://openreview.net/pdf?id=CG44RLeXt1

神经网络的强大性能通常依赖于大量可用的标注数据,但获取准确的标签往往是困难的。相比之下,从多个源收集带噪声的监督信息(例如,通过多条精心设计的规则)则更加便捷。

在本文中,我们聚焦于多源噪声学习这一现实问题,论证了相关研究忽略了神经网络的关键的“自我认知”能力,即,在训练过程中自主区分噪声的内在能力。

我们对神经网络面对多源噪声标记时的“自我认知”能力进行了理论分析,揭示了神经网络同时具备识别来自单个噪声标记源内的样本级噪声和来自多个噪声标记源间的标注者质量的能力。受到理论分析的启发,我们介绍了一种名为自感知去噪的多源噪声学习方法(Self-cognitive Denoising for Multiple noisy label sources, SDM),该方法利用神经网络的自我认知能力在训练期间进行去噪。

此外,我们也根据理论构建了一个选择性蒸馏模块,以优化计算效率。多个数据集上的实验表明了我们方法的优越性。

DUPLEX:Dual GAT for Complex Embedding of Directed Graphs / DUPLEX:基于双图注意力网络的有向图复嵌入方法

论文链接:

https://icml.cc/virtual/2024/poster/34257

当前的有向图嵌入方法建立在无向图嵌入的基础上,但往往没有充分利用有向的边信息,面临以下挑战:

(1)不充分利用邻居信息,导致对低入/出度节点的表示不佳;

(3)训练过程与具体下游任务过于耦合,影响节点嵌入的跨任务泛化性。

为解决上述挑战,本文提出了DUPLEX,一个用于有向图复嵌入的归纳学习框架。

它(1)利用厄米邻接矩阵分解原理,充分利用邻居信息,(2)引入双图注意力网络编码器,进行有向邻居聚合,(3)引入两个无参解码器,将训练过程与特定下游任务解耦。

实验结果证明,DUPLEX优于最先进的模型,尤其对于具有稀疏连接的图,并且在各种任务中展示了强大的归纳能力和适应性。

代码提供于▼

https://github.com/alipay/DUPLEX

SMaRt:Improving GANs with Score Matching Regularity / SMaRt:使用分数匹配正则促进GAN

论文链接:

https://arxiv.org/pdf/2311.18208

生成对抗网络(GAN)通常难以从高度多样化的数据中学习,因为这些数据的底层流形非常复杂。

在本文中,我们重新审视了GAN的数学基础,并从理论上揭示了GAN训练的原生对抗损失不足以解决生成数据流形的勒贝格测度为正的子集位于真实数据流形之外的问题。相反,我们发现分数匹配是解决此问题的一个有希望的解决方案,因为它能够持续将生成的数据点推向真实数据流形。

因此,我们提出利用分数匹配规律(SMaRt)来改进GAN的优化。关于实证证据,我们首先设计了一个玩具示例来展示借助真实分数函数训练GAN可以帮助更准确地重现真实数据分布,然后确认我们的方法可以持续提高各种最新GAN在真实数据集上的综合性能,其中预训练的扩散模型充当近似分数函数。例如,在ImageNet 64×64数据集上训练Aurora时,我们成功将FID从8.87提高到7.11,与一步一致性模型的性能相当。

Keypoint-based Progressive Chain-of-Thought Distillation for LLMs/基于关键点的渐进式思维链蒸馏方法在大语言模型(LLMs)中的应用

论文链接:

https://arxiv.org/pdf/2405.16064

思维链提炼是一项强大的技术,它能够把大语言模型(LLMs)的推理能力传递到参数更少的学生模型(student model)中。

之前的方法通常需要学生模型去逐步模仿LLMs生成结果的推理过程,但这些方法常常会遇到以下挑战:

(i) 推理过程中的token重要性不一,如果对所有token一视同仁,会无法精确地学习到关键token,从而引起推理错误;

(ii) 这些方法通常通过连续预测整个推理过程中的所有步骤来提炼知识,这无法有效区分各个步骤生成的学习顺序,这与人类的认知过程——即从简单任务开始逐渐过渡到更复杂的任务——是不同的,从而导致了思维提炼的非最优结果。

为了解决这些问题,我们提出了名为KPOD的统一框架。具体地,我们引入了一个利用掩码学习的标记权重模块,从而促使学生模型在思维链提炼过程中准确拟合关键token。此外,我们还开发了一种推理过程中的渐进式提炼策略,这种策略从训练学生模型生成最终推理步骤开始,并逐步扩展到覆盖整个推理过程。

为此,我们提出了一种加权标记生成损失,用于评估推理步骤的难度,同时设计了一个价值函数(value function),用于根据推理步骤的难度和问题的多样性来进行渐进式的思维链提炼。在四个推理基准上的广泛实验表明,我们提出的KPOD方法能够显著超越现有的方法。相较现有模型蒸馏技术,KPOD能将推理准确率提升5%。

Mind the Boundary:Coreset Selection via Reconstructing the Decision Boundary / 关注边界:基于重构决策边界的核心集选取

论文链接:

https://openreview.net/pdf/dd88f860a4c83a4a50a7d8c268992946b370b84b.pdf

现有领域的发展范式往往需要指数级增长的训练数据量。为缓解这一日益增长的数据需求,核心集选择旨在识别训练数据中最有效的小样本子集。

本文深入研究了基于几何的核心集方法,并初步将数据分布的几何性质与模型的泛化能力在理论上联系起来。借助这些理论见解,我们提出了一种新颖的核心集构建方法,该方法通过选取训练样本以重建全数据集上深度神经网络学习到的决策边界。

广泛的实验验证了我们的方法在多个流行基准测试中的优越性。我们的方法首次在ImageNet-1K数据集上实现了50%的数据剪枝率,但是精度损失不超过1%。此外,我们还展示和分析了由我们方法得出的核心集在不同架构间的显著迁移能力。

Improving Equivariant Graph Neural Networks on Large Geometric Graphs via Virtual Nodes Learning/ 通过虚拟节点学习加速大型几何图上的等变图神经网络

论文链接:

https://openreview.net/pdf?id=wWdkNkUY8k

等变图神经网络(GNNs)在各种科学应用中取得了显著的成功。然而,现有的等变GNN在处理大型几何图时遇到了效率问题,如果输入只是为了加速处理而被简化为稀疏的局部图,其性能将大打折扣。

在本文中,我们提出了FastEGNN,一种在大型几何图上的增强模型的等变GNN。核心思想是利用一小组有序的虚拟节点来近似表示大型无序的真实节点图。特别是,我们区分不同虚拟节点的信息传递和聚合,以鼓励它们之间的相互独特性,并最小化虚拟坐标和真实坐标之间的最大均值差异(MMD),以实现全局分布性。FastEGNN满足所有必要的E(3)对称性,并且也有一定的通用表达性保证。

我们在N体系统(100个节点)、蛋白质(800个节点)和水分子3D结构(8000个节点)上进行的实验表明,FastEGNN在准确性和效率之间实现了有希望的平衡,即使在删除了蛋白质和水分子3D等真实系统中的所有边之后,其在准确性方面也优于EGNN。

CCM:Real-Time Controllable Visual Content Creation Using Text-to-Image Consistency Models/ 基于文生图一致性模型的实时可控视觉内容生成

论文链接:

https://icml.cc/virtual/2024/poster/34738

涉及领域:

AIGC;深度学习;生成模型;一致性模型

一致性模型(CM) 有望通过几步采样生成高质量图像。然而,向预训练的 CM 添加新的条件控制的方法尚未被探索。

在本文中,我们探讨了利用一致性模型的生成能力和效率来通过ControlNet促进可控视觉内容创建的关键主题。首先,观察到为扩散模型 (DM) 训练的ControlNet可以直接应用于CM进行高级语义控制,但会牺牲图像的低级细节和真实感。为了解决这个问题,我们使用一致性训练为ControlNet开发了一种针对CM的训练策略。

事实证明,可以通过一致性训练技术成功建立ControlNet。此外,可以利用一致性训练训练统一适配器,从而增强DM的ControlNet的适应性。我们使用预先训练的文本到图像潜在一致性模型,对各种条件控制下的所有策略进行定量和定性评估,包括草图、hed、canny、深度、人体姿势、低分辨率图像和遮挡图像。

Trustworthy Alignment of Retrieval-Augmented Large Language Models via Reinforcement Learning/ 基于强化学习的检索增强大语言模型可信对齐

论文链接:

https://icml.cc/virtual/2024/poster/33796

检索增强的LLM仍然会遭受幻觉的困扰,其主要原因之一是上下文知识和参数知识之间的冲突。受到语言模型对齐的启发,我们将检索增强语言模型也对齐到尽量依赖外部证据而不是内部参数知识做出响应的状态,即“可信”状态。

具体来说,我们提出了一种基于强化学习的算法“可信对齐”,从理论上和实验上证明了大型语言模型可以通过这种方法对齐到可信状态,并将对齐的应用场景从满足人类偏好扩展到创建可信的Agent等场合。

结果表明,基于“可信对齐”的检索增强大语言模型无需人工标注的回复作为监督信息,即可在Natural Question问答任务上达到和SFT接近的效果,给开源基础模型带来平均55%的EM提升和53%的记忆率降低。

同时“可信对齐”可以一定程度上泛化到ConflictQA任务,并且享有较低的对齐税。在接受人类评估时,“可信对齐”的对齐税相对于SFT胜率高出83%,流畅度相对于SFT胜率高出30%。

Unifying Bayesian Flow Networks and Diffusion Models through Stochastic Differential Equations/ 通过随机微分方程统一贝叶斯流网络与扩散模型

论文链接:

https://arxiv.org/pdf/2404.15766

如今深度生成式模型被广泛运用在计算机视觉和自然语言处理等领域。这些模型面临的主要挑战在于如何有效地表示复杂的概率分布,这些分布通常高度依赖于具体的数据或模态,同时能需要够进行有效的训练和推理。

自回归模型(ARM,Auto-Regressive Model)擅长对序列和离散数据(如文本)进行建模,但在推理速度上存在明显瓶颈,另一方面,扩散模型(Diffusion Models,DMs)采用从粗糙到精细的渐进式方法,实现了生成质量与效率的更好平衡。目前扩散模型在图像生成领域取得了很大的进展,但它在处理离散变量时面临挑战,分数匹配算法在这里并不直接适用。贝叶斯流网络(Bayesian Flow Networks,BFN)是一种新的生成式模型,与扩散模型(DM)不同,BFN不直接处理样本,而是通过贝叶斯推理迭代地细化不同噪声级别的分布参数。这种模型因其可微性质显示出在连续与离散数据建模上的巨大潜力,并且能够实现快速采样。

为了更深入地理解和改进BFN,本文利用随机微分方程(Stochastic Differential Equations,SDEs)将其与扩散模型建立了联系。我们发现了与BFN中的加噪过程相对应的线性SDE,证明了BFN的回归损失等价于降噪分数匹配(Denoise Score Matching,DSM)。基于此发现,我们验证BFN中的采样器近似等同于反向SDE的一阶Solver。

此外,通过借鉴扩散模型中现有的快速采样方案,我们提出了一种新的采样方法——BFN-Solvers,通过在图像和文本数据集上的测试,BFN-Solvers在进行有限次数(例如10次)的函数评估下,能显著提升样本质量,并超越原始BFN采样器。特别地,我们的最优采样器实现了5~20倍的速度提升。