包阅导读总结

1. 大模型幻觉、强化学习、可信对齐、检索增强、智能风控

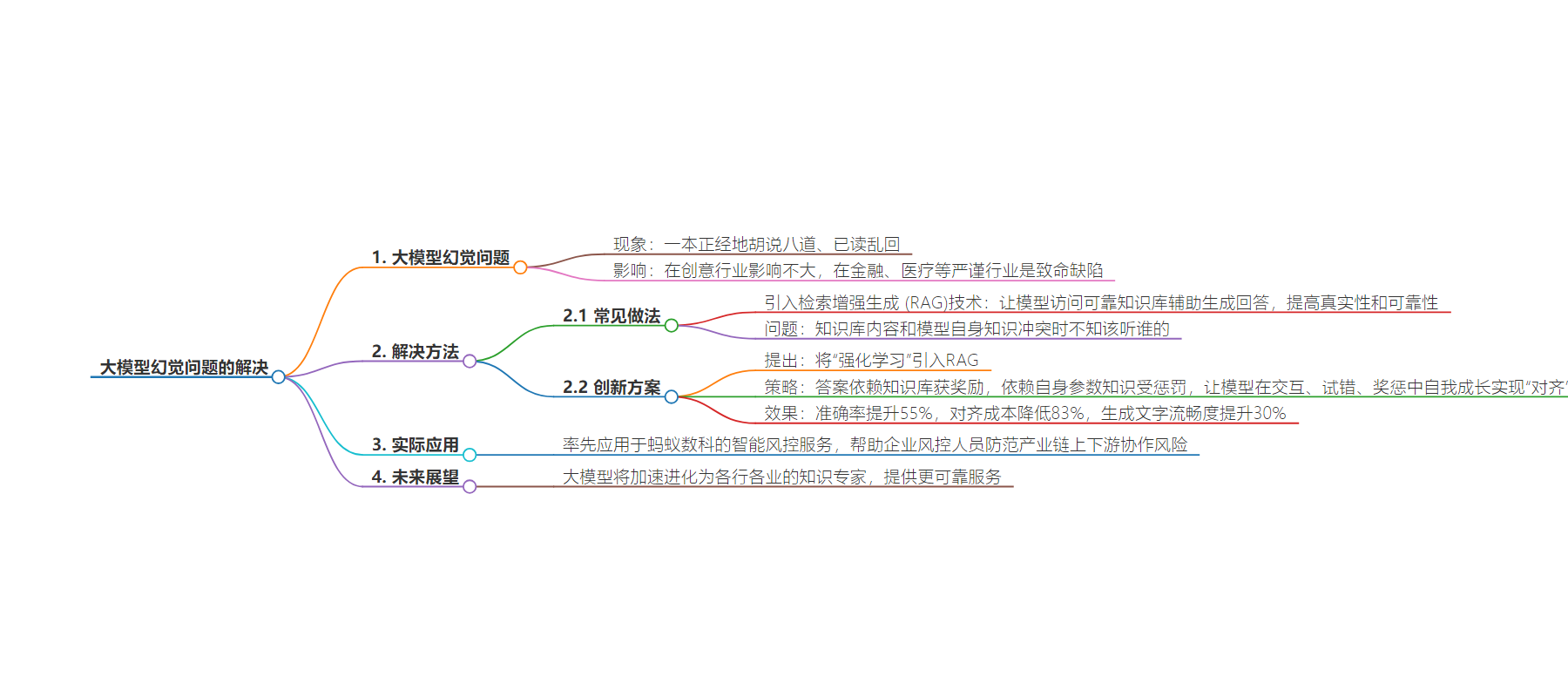

2. 大模型存在幻觉问题,在严谨行业是致命缺陷。中国科大等联合申报的论文致力于攻克此问题,提出将强化学习引入检索增强方案,实验效果良好,成果将用于蚂蚁数科智能风控服务,未来大模型有望为各行业提供可靠服务。

3.

– 大模型幻觉问题

– 大模型赛道热闹,但其幻觉问题在体验中常见,如胡说八道、已读乱回,在金融、医疗等行业是致命缺陷

– 解决大模型幻觉问题的研究

– 论文《基于强化学习的检索增强大语言模型可信对齐》入选 ICML2024

– 从理论和实验证明大型语言模型可通过方法对齐到可信状态,并扩展应用场景

– 造成幻觉问题的主要原因是训练文本可能有误和训练目标非确保信息准确

– 行业常见做法是引入检索增强生成技术,但存在知识库和模型自身知识冲突的问题

– 论文创新提出将强化学习引入检索增强的方案,通过奖惩策略让模型自我成长实现对齐

– 研究成果的应用

– 方案准确率提升 55%,对齐成本降低 83%,文字流畅度提升 30%

– 成果将率先应用于蚂蚁数科的智能风控服务,帮助企业风控人员防范风险

思维导图:

文章地址:https://mp.weixin.qq.com/s/lhj737p5eW1_Cb_6cabjtw

文章来源:mp.weixin.qq.com

作者:蚂蚁数科

发布时间:2024/8/6 12:58

语言:中文

总字数:1168字

预计阅读时间:5分钟

评分:91分

标签:大模型,幻觉问题,强化学习,检索增强生成 (RAG),可信对齐

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

这两年大模型赛道特别热闹

从生文、生图、到生视频

不过大家在体验的时候经常会发现

大模型也会一本正经地胡说八道

甚至还会已读乱回

这就被称为大模型的幻觉问题

如果是在创意行业

大模型大开脑洞可能没多大问题

但是在讲究严谨和安全的

金融、医疗等行业

模型幻觉就会成为致命缺陷

最近,由中国科学技术大学、合肥综合性国家科学中心人工智能研究所和蚂蚁数科联合申报的论文《基于强化学习的检索增强大语言模型可信对齐》(Trustworthy Alignment of Retrieval-Augmented Large Language Models via Reinforcement Learning)入选了国际人工智能顶会ICML2024。

这篇论文就是致力于攻克大型语言模型“幻觉”问题的。

它不仅从理论上和实验上证明了大型语言模型可以通过这种方法对齐到可信状态,并还将对齐的应用场景从满足人类偏好扩展到创建可信的 Agent 等场合。

我们先来了解下造成大语言模型“幻觉”问题的主要原因:

训练大语言模型LLM需要让模型学习大量文本,这些文本中可能会包含错误、偏见。

大多数LLM的训练目标是生成高度连贯和自然的语言,而不是确保每一条信息的准确性。

这意味着,模型有时会优先生成听起来合理而非事实的信息。

针对幻觉问题,行业里常见的做法是引入检索增强生成(RAG)技术。

也就是让模型访问由人类提供的可靠知识库的内容(如维基百科、专用文档),去辅助生成回答。

这样一来,大模型就像有了一本专业知识手册,在生成答案时,会将检索到的内容和自身的知识参数相结合,这种从检索到生成的模式显著提高了LLM的真实性和可靠性。

但问题是,如果知识库的内容和模型自身的知识冲突了,模型该听谁的?

论文研究团队认为,只有当智能问答模型能够基于人类提供的可靠知识库而不是自身参数回答问题时,它才是可信赖的。

论文创新性地提出了将“强化学习”引入RAG的方案。

当知识冲突时,如果模型给出的答案依赖知识库,则获得奖励;而如果依赖自身的参数知识,则给予惩罚。

不需要人工标注训练,让模型在交互、试错、奖惩策略中自我成长,实现与准确答案的“对齐”。

实验结果表明,该方案比开源基础模型的准确率提升55%,与准确答案的对齐成本降低83%。不仅在生成文字的流畅度方面比传统方法提升30%,良好的性能将有利于语言模型在严谨行业的应用落地。

接下来,该研究成果将率先应用于蚂蚁数科的智能风控服务中。

以后,企业风控人员可以向Agent智能体提问目标企业或行业的经营状况、风险评级等。Agent自动调用API查询相关的数据指标,并通过可信对齐的大模型生成可靠答案,提供给企业的风控人员,帮助防范产业链上下游协作风险。

自大模型诞生以来,“可信对齐”成为重要课题,对于大模型落地严谨行业至关重要。我们相信在不久的未来,大模型将加速进化为各行各业的知识专家,为人类提供更多更可靠的服务。