包阅导读总结

1. 关键词:

– 微软

– 大模型推断

– LLMLingua

– 开源项目

– 语言模型

2. 总结:

本文介绍了微软开源的 LLMLingua 项目,该项目专注于加快大模型推断速度和增强关键信息感知,能压缩提示和 KV-Cache,达 20 倍压缩效果且性能损失小,可通过 pip 安装,项目有活跃的开发团队和显著成果。

3. 主要内容:

– 背景介绍

– 大规模语言模型推理面临加快速度、增强关键信息感知、压缩 prompt 提示和 KV-Cache 等问题。

– 项目介绍

– LLMLingua 由微软开发,能加快大模型推断速度和增强关键信息感知,压缩提示和 KV-Cache 效果显著。

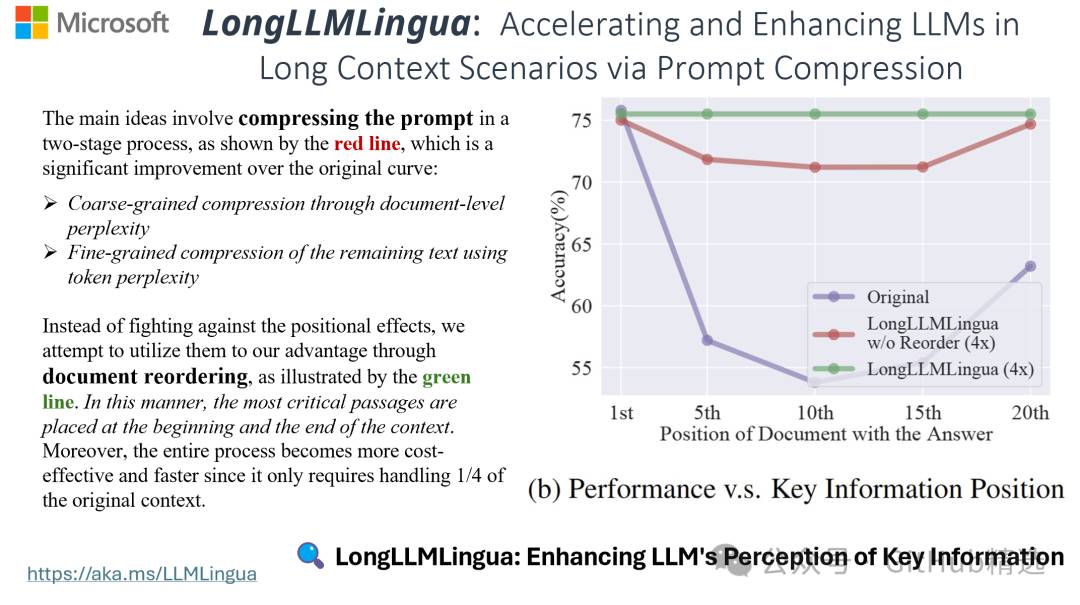

– 推出 LongLLMLingua 工具解决模型迷失问题,提高长上下文信息处理能力。

– 如何使用

– 通过 pip 安装,示例代码展示压缩提示的操作。

– 项目推介

– 由经验丰富团队开发维护,在相关方面成果显著,提供项目地址和成员信息。

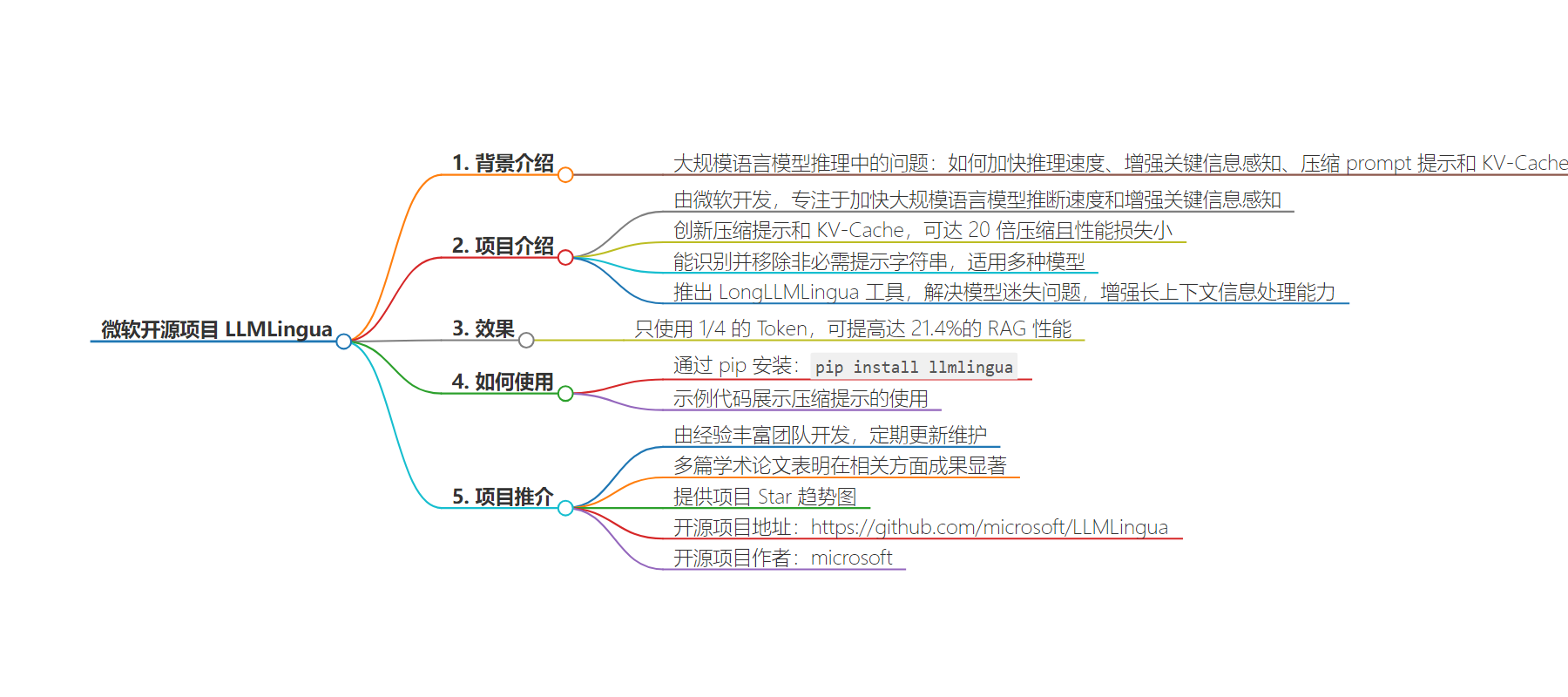

思维导图:

文章地址:https://mp.weixin.qq.com/s/3ZGMnvTF-RnQZAHyBJptmA

文章来源:mp.weixin.qq.com

作者:精选君

发布时间:2024/6/14 4:34

语言:中文

总字数:926字

预计阅读时间:4分钟

评分:81分

标签:微软,开源,大规模语言模型,推断速度,提示压缩

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

大家好,又见面了,我是 GitHub 精选君!

背景介绍

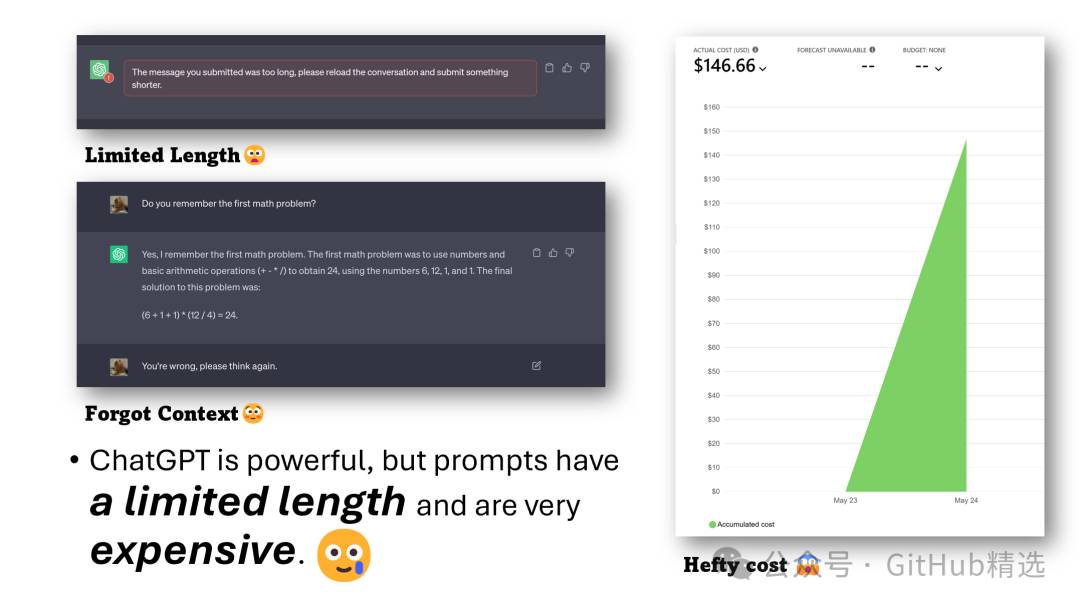

在大规模语言模型推理过程中,我们经常会面临几个问题:如何加快语言模型的推理速度;如何增强语言模型对关键信息的感知;如何压缩 prompt 提示和 KV-Cache。这些问题让人头痛,很多解决起来需要很多人力和资源投入。

今天要给大家推荐一个微软开源的项目 LLMLingua,该项目在 GitHub 有超过 1.2k Star,用一句话介绍该项目就是:“To speed up LLMs’ inference and enhance LLM’s perceive of key information, compress the prompt and KV-Cache, which achieves up to 20x compression with minimal performance loss. ”。

项目介绍

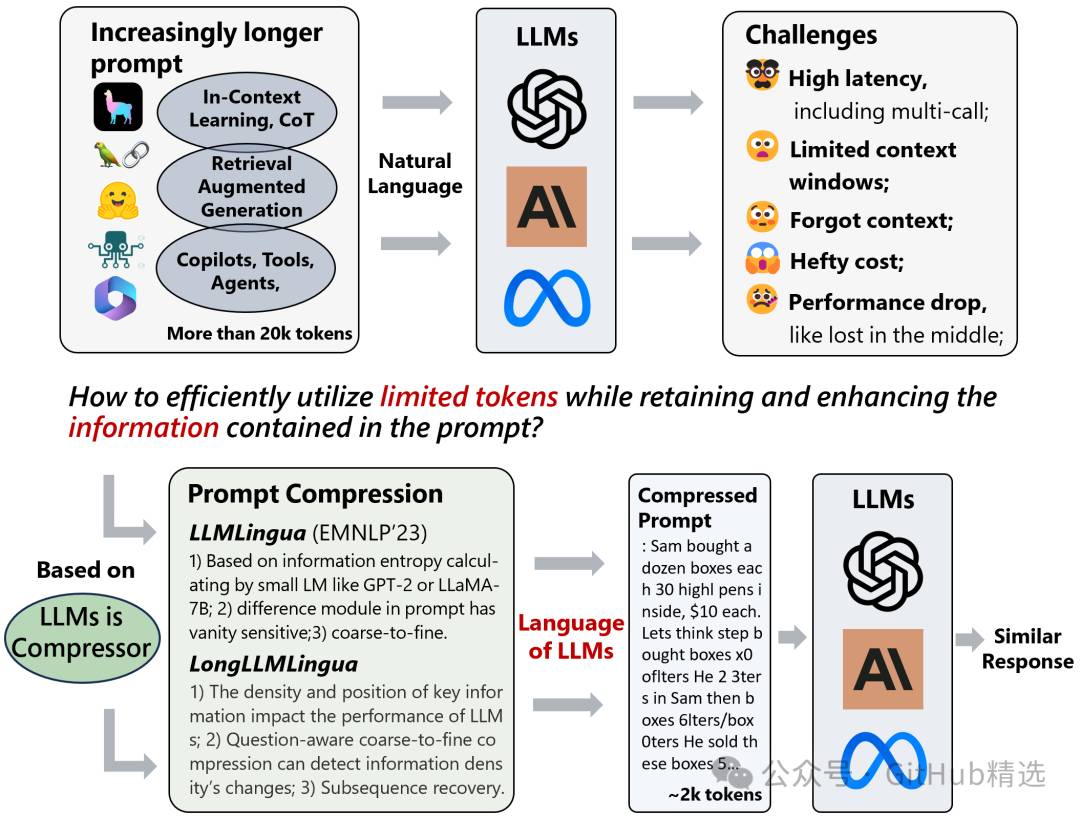

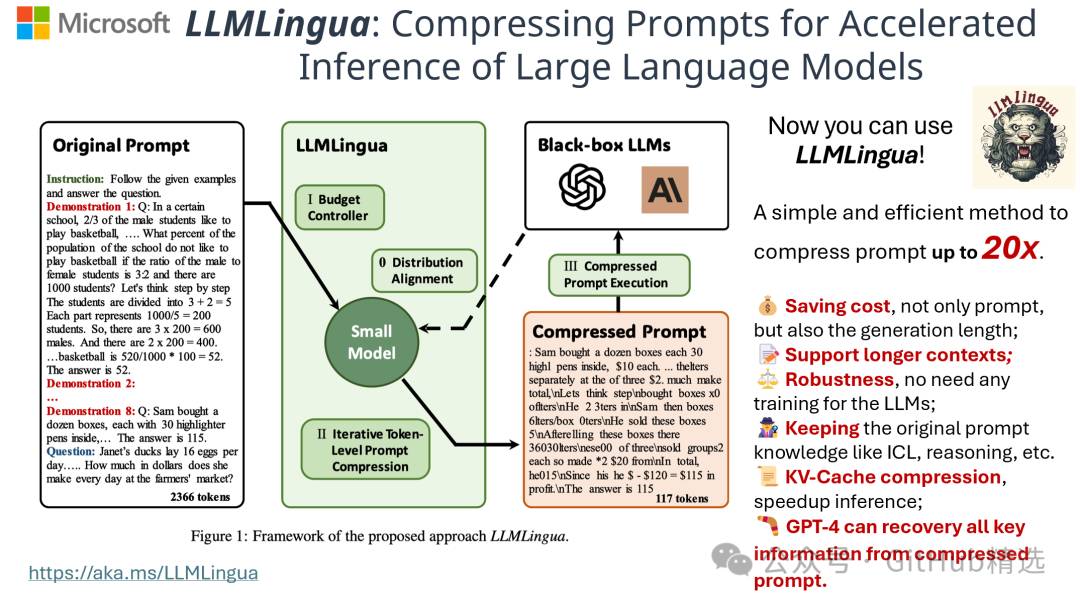

LLMLingua 是一个由微软开发的专注于加快大规模语言模型 ( LLMs ) 的推断速度和增强模型对关键信息感知的开源项目。通过创新的方式压缩提示和 KV-Cache,LLMLingua 能达到高达 20 倍的压缩效果,而且性能损失微乎其微。无论是 GPT2-samll,还是 LLaMA-7B,LLMLingua 都能有效地识别并移除非必需的提示字符串,从而实现高效的大规模语言模型推断。在微软的 LLMLingua 项目中,还推出了 LongLLMLingua 工具,它专门解决 LLMs 中在交流的中部模型迷失的问题,增强了长上下文信息处理的能力。只使用 1/4 的 Token,就可以提高达 21.4% 的 RAG 性能。

当前大模型的应用现状:

LLMLingua 的架构:

LLMLingua 的效果:

如何使用

使用 LLMLingua 的过程非常简单,通过 pip 即可快速安装,运行pip install llmlingua。然后,你就可以使用(Long)LLMLingua 来压缩你的提示了,代码如下:

fromllmlinguaimportPromptCompressor

llm_lingua=PromptCompressor()

compressed_prompt=llm_lingua.compress_prompt(prompt,instruction="",question="",target_token=200)

#>{'compressed_prompt':'Question:Samboughtadozenboxes,eachwith30highlighterpensinside,for$10eachbox.Hereangedfiveofboxesintopackagesofsixlterseachandsoldthem$3per.Hesoldtherestthetersseparatelyattheofthreepens$2.Howmuchdidmakeintotal,dollars?\nLetsthinkstepstep\nSambought1boxesx00oflters.\nHebought12*300tersintotal\nSamthentook5boxes6ters0ters.\nHesoldtheseboxesfor5*5\nAfterellingtheseboxestherewere3030highlightersremaining.\nTheseform330/3=110groupsofthreepens.\nHesoldeachofthesegroupsfor$2each,somade110*2=$220fromthem.\nIntotal,then,heearned$220+$15=$235.\nSincehisoriginalcostwas$120,heearned$235-$120=$115inprofit.\nTheansweris115',

#'origin_tokens':2365,

#'compressed_tokens':211,

#'ratio':'11.2x',

#'saving':',Saving$0.1inGPT-4.'}

##Orusethephi-2model,

##Beforethat,youneedtoupdatethetransformerstothegithubversion,likepipinstall-Ugit+https://github.com/huggingface/transformers.git

llm_lingua=PromptCompressor("microsoft/phi-2")

##Orusethequantationmodel,likeTheBloke/Llama-2-7b-Chat-GPTQ,onlyneed<8GBGPUmemory.

##Beforethat,youneedtopipinstalloptimumauto-gptq

llm_lingua=PromptCompressor("TheBloke/Llama-2-7b-Chat-GPTQ",model_config={"revision":"main"})项目推介

作为微软发布的开源项目,LLMLingua 是由经验丰富的开发者团队开发的,他们定期更新和维护此项目,致力于为 LLMLingua 提供最新的功能和改进。根据多篇学术论文的研究表明,LLMLingua 在压缩提示、加速推断、增强大规模语言模型的信息处理能力等方面取得了显著的成果。

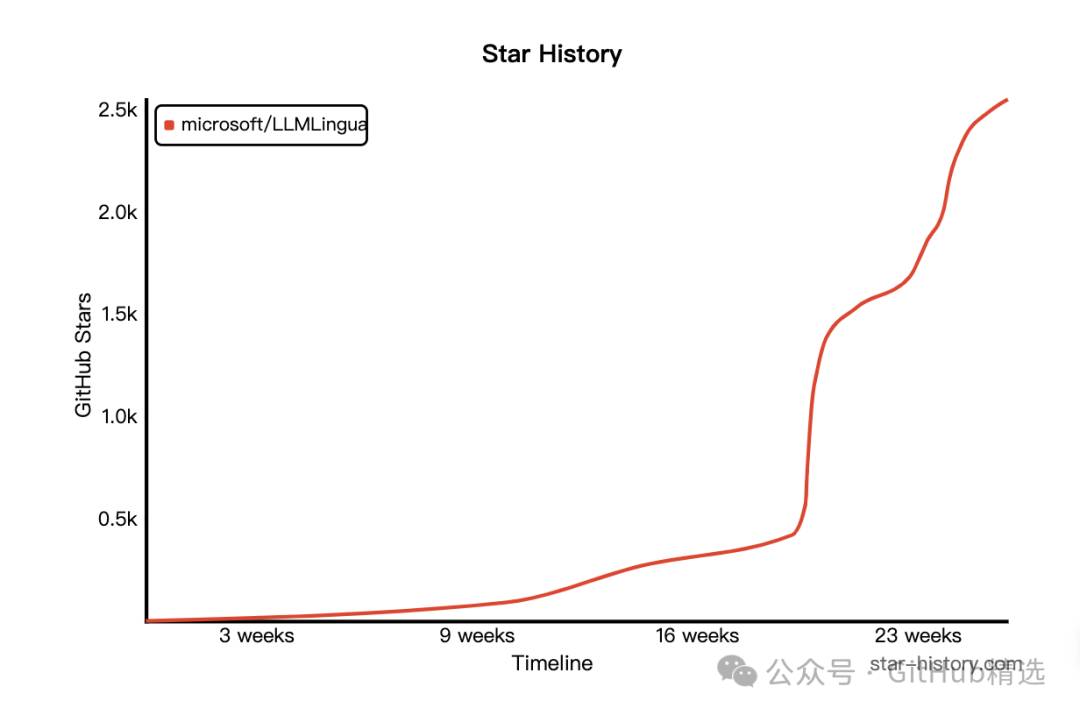

以下是该项目 Star 趋势图(代表项目的活跃程度):

更多项目详情请查看如下链接。

开源项目地址:https://github.com/microsoft/LLMLingua

开源项目作者:microsoft

以下是参与项目建设的所有成员:

关注我们,一起探索有意思的开源项目。

点击如下卡片后台回复:加群,与技术极客们一起交流人工智能、开源项目,一起成长。如果你正在寻求开源项目推广、DevOps、AIGC 大模型、软件开发等领域的付费服务,可参考推文了解详情。