包阅导读总结

1. 科大讯飞、大模型、业务需求、研发策略、场景落地

2. 科大讯飞副总裁刘聪介绍了讯飞研究院在大模型浪潮中的发展。包括从追赶国际领先到探索自身特色,关注通用底座与小模型发展,围绕刚需场景应用,与业务紧密结合,解决落地问题及总结经验,在大模型争夺战中找准定位。

3.

– 科大讯飞大模型研发

– 讯飞研究院为产品提供技术支持,启动“1+N”专项攻关

– 星火大模型迭代,去年集中发布产品,今年节奏变化

– 大模型与小模型并行,关注场景需求选择

– 多模态拓展,重点在 OCR,不侧重文生图

– 业务落地与场景应用

– 研发与业务紧密相连,深入场景,如教育行业

– 硬件与软件结合,提升附加值和体验

– 对外服务面临问题,通过服务平台解决

– 总结经验,减少重复开发,统一接口

– 大模型争夺战中的定位

– 综合能力头部,在擅长领域保持耐心和耐力

– 给用户习惯时间,培养耐心

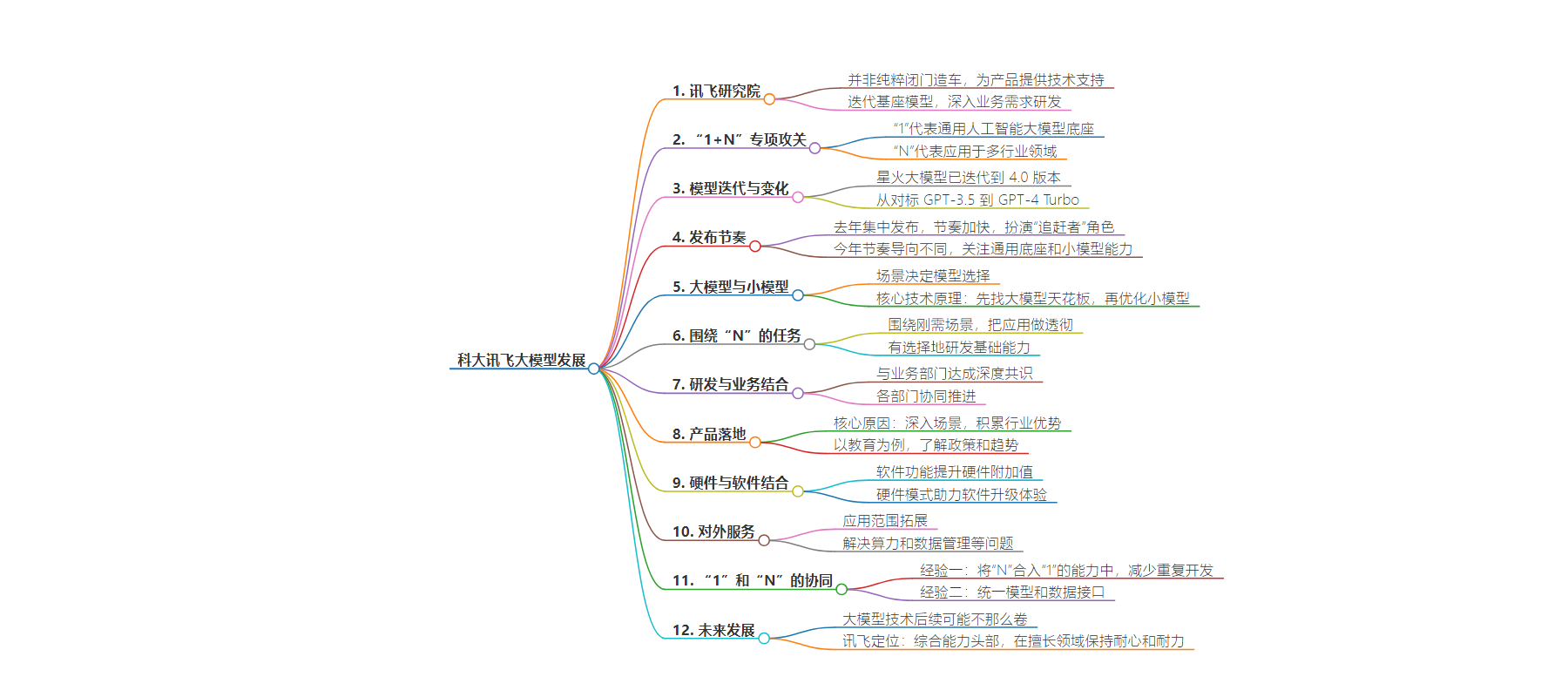

思维导图:

文章地址:https://mp.weixin.qq.com/s/bOOJbcCvKaopP3zNtAfAQA

文章来源:mp.weixin.qq.com

作者:褚杏娟

发布时间:2024/8/18 2:40

语言:中文

总字数:3192字

预计阅读时间:13分钟

评分:88分

标签:人工智能大模型,科大讯飞,业务需求导向,多模态技术,模型优化

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

“讯飞研究院并非一个纯粹闭门造车的技术研究院。”科大讯飞副总裁、研究院院长刘聪说道。从 2005 成立至今,讯飞研究院为科大讯飞的产品提供了有力的技术支持,这次大模型浪潮中也不例外。

正如刘聪所说,“研究院的大部分技术都对应着具体的业务需求。”讯飞研究院一边迭代自己的基座模型,一边深入业务需求进行相关研发。

2022 年 12 月,讯飞启动了“1+N 人工智能大模型技术及应用”专项攻关,其中“1”代表通用人工智能大模型底座,“N”代表将人工智能大模型技术应用在教育、医疗、汽车、办公、智能硬件等多个行业领域。如今,讯飞对“1”和“N”的理解发生了哪些变化?

从去年 5 月星火大模型首个版本发布至今,一年多的时间里,讯飞研究院已经将该模型迭代到了 4.0 版本,模型也从最初的对标 GPT-3.5,更新至迭代最新的 GPT-4 Turbo。

纵观整个去年,讯飞很多产品是集中发布的,基本上 2、3 个月就有一次产品发布。这个节奏与之前几乎一年一次发布的讯飞相比要快很多。

刘聪介绍,这个时候的讯飞,更多扮演的是“追赶者”的角色:摸索整个大模型训练过程中的各种经验,比如如何处理数据、scaling law 是否符合预期等,对标国际领先模型,同时关注一些落地场景。另外,国产化也是讯飞要重点推进的工作。

对于去年的整体节奏,刘聪认为讯飞做得是比较好的,这源于讯飞会提前做好发布计划,“我们更多的是计划做得比较好,让大家感受到了每个大版本之间的变化。”

但是,今年的节奏导向已经与去年有所不同。

“今年年初,我们就对大模型这件事情已经摸索得比较清楚了。”刘聪说道,“我们现在既关注通用底座大模型,同时探索也在如何提升小模型的能力和效果。”

当前,大模型与小模型并行发展已经是行业趋势。对于选择大模型还是小模型,刘聪表示主要看场景需要什么样的模型。“如果只泛泛地说‘使用小模型与大模型差距不大’,这纯粹是胡说。”

刘聪解释道,在撰写文案、代码编写等方面,一个中小规模的模型即可搞定,讯飞将这类应用定义为一般任务;中等任务涉及行业内的很多知识库和行业深度内容,还有一些高难度任务,例如复杂推理、数学推理等,目前大模型都无法解决,更不用提小模型。

“我们一直强调大、小模型时代,并不意味着不再关注大模型了。核心技术原理是先找到大模型的天花板,再优化小模型。小模型的不断进步依赖于大模型的发展。”刘聪说道。

另外,讯飞研究院更重要的一项任务是围绕“N”中的刚需场景,把大模型应用做透彻,因此深入解决系统化问题变得非常关键。

不过在众多的基础能力上,讯飞也是有选择地进行研发。比如在通用任务中,讯飞最关注的能力之一是数学,因为在刘聪看来,数学能力与推理结合是大模型聪明的表现。

但是,不同于有的公司有专门的文生图产品,讯飞的文生图是在星火统一入口里面使用。刘聪明确称,“在文生图方面,我的优先级较低,甚至不专门制作文生视频。虽然我们与视频关系不大,但是我们会制作虚拟人、加强语音能力,我们必须做好语音交互。”

在刘聪看来,大模型底座是向多模态拓展的,对讯飞而言多模态的能力逐步提高最重要,但没有必要在一些业务关联度低、资源投入过大的方面做太多投入。在多模态中,刘聪会将重点放到 OCR(Optical Character Recognition,光学字符识别)上,“确保 OCR 做到最好,这与我的实际工作紧密相关。”

基于此,讯飞今年的重点虽然还是大模型通用能力的打造,但讯飞不会选择样样争第一,而是在自己认为的最重要的方向发力,比如交互能力等。

讯飞研究院的研发工作与业务紧密相连,在研发之前,研究院要与业务部门达成深度共识,比如某个功能达到什么程度、完成客观技术指标后能为用户带来什么价值等。

达成共识之后,从研究院内部的算法研发部门、工程引擎部门、服务平台部门和资源部门,再到产品研发部门,整个过程需要一起对齐。无论发布产品、然后不断迭代,还是创新性研发一个产品,都是这样的过程。

讯飞被外界认为是较少能真正将技术实现产品落地的企业,刘聪认为这背后的核心原因是讯飞更加深入场景。

“我们找 PMF 之所以准确,是因为过去对行业场景和技术的积累。坚持阶梯原则,我们了解大模型在哪个节点可以适配、哪个场景可以发挥价值。”刘聪说道。“此外,讯飞也有深厚的场景资源和用户基础。”

以学习机为例,讯飞过去十几年从事学校工作,每天在学校里与老师打磨,持续了解中国教育政策以及未来发展趋势。老师的教学环境如何、不同年龄段的孩子是否有时间额外学习等,如果仅凭想象和拍脑袋是很难定义出来的。教育行业讲究因材施教,而非图文等技术。

落地中,选择在已积累的行业优势基础上进行大模型探索,是大多数相对成熟公司会选择的风险相对较低的策略。“自我造血非常重要,所以我们更加关注相对熟悉的方向,例如教育、医疗、办公、汽车和金融。”刘聪说道。

而什么时候完成应用则与大模型发展阶段有关系。围绕刚需场景,什么技术可以支撑、支撑度如何等都需要考虑。比如技术阅卷,之前是判断填空、选择题,后来扩展到了解答题并全学科阅卷,这都对技术要求越来越高。有了大模型后,直观的表现之一就是作文批改比之前做得更好。

讯飞业务中,硬件是不可忽略的一部分,比如有面向教育的学习机、批阅机等。讯飞业务的特点之一就是每个行业都有软硬件的差异。比如学习机不断将软件功能加到硬件上,以此提升硬件附加值。同时,硬件模式又能助力软件,例如翻译机和办公本都有一些大模型应用来升级体验,这不仅仅是单纯利用大模型的 API 连接,而是形成了适合硬件场景的独特功能。

而对外服务中,刘聪观察到,大模型的应用范围已经逐渐变大,比如金融这样的代表性场景已经往央国企拓展。“对应用大模型的企业来说,产品价值最重要的是能否降本增效。”刘聪说道。

讯飞在对 B 端业务服务过程中,发现算力统一难和整个数据管理难等问题。另外,在对外服务过程中,由于很多企业是私有化部署,因此讯飞在底座模型应用和场景开发中,对用户的场景并不清楚。为此,讯飞通过智能体平台这样的服务来解决。

“N 的逻辑必须落地。现在的阶段与去年不同,去年我们的 1+N 有些冗余,需要继续梳理。今年我们将主要的 N 梳理清楚后,一和 N 的协同变得更加系统。”刘聪说道。

根据实践观察,刘聪总结了两点经验:

第一,不必专门针对“N”,可以将其合入“1”的能力中。一个场景下的常用能力可以满足,或者在 1 基础上做某个智能体就能满足,合入“1”里就可以,这是减少重复开发的逻辑。

第二点,统一模型接口和数据接口。这里的 N 可能是业务线主导,有的是研究院主导,但一个公司内部的每个业务数据标注体系如果都不同,那将它们合并汇总到主模型就会相当困难。完成模型接口后,需要标注数据、SFT 数据和强化学习数据,形成一个技术体系。在此框架下,用户可以自行寻找专家进行标注,这样既能优化流程,又能将这些 N 的数据回流到数据库中。

对于今年讯飞的“1”和“N”而言,刘聪表示,“虽然是动态发展的,但是不能放弃。如果不演进,三个月就不行了。”

不过,随着模型规模的增大,研发周期会逐渐拉长,因此刘聪认为大模型技术后续可能不一定还那么卷。“GPT-5 底座大模型投入巨大,升级周期会变长,局部亮点可能会不断出现,但可能很难有 GPT-3.5 到 4 那么大的提升。”

在大模型争夺战中,讯飞给自己的定位是“综合能力是头部,在自己擅长的地方保持耐心和耐力”,因为一个很现实的问题就是大模型的企业同质化严重,但其实想要在每个领域都做到最好很难,OpenAI 和谷歌都做不到。

“我们还要给用户习惯的时间,通过产品培养用户和客户的耐心。”刘聪说道。