包阅导读总结

1.

关键词:Devoxx Genie、IntelliJ 插件、LLM 模型、本地云端、RAG

2.

总结:Devoxx Genie 是基于 Java 的 IntelliJ IDEA 插件,能使用本地或云端 LLM 模型处理源代码,2024 年 4 月发布,最低版本需求为 JDK17 和 IntelliJ IDEA 2023.3.4,其创始人还推出 RAG 原型,未来计划将 RAG 纳入该插件。

3.

主要内容:

– Devoxx Genie 是 IntelliJ 插件

– 可访问本地或云端 LLM 模型

– 生成单元测试,解释、审查和改进源代码

– 支持本地供应商如 Ollama、LM Studio 等,也支持云端供应商如 OpenAI 等

– 发布及配置信息

– 2024 年 4 月由 Stephan Janssen 发布

– 最低需求 JDK17 和 IntelliJ IDEA 2023.3.4,可通过特定方式安装

– 本地 LLM 需至少一条 URL,云端需 API 密钥,可配置多个模型

– RAG 相关

– Stephan 推出 LLM 的 RAG 原型 RAG Genie

– 可用于改进传统 LLM 生成结果,根据答案质量和成本协调模型

– 未来计划纳入 Devoxx Genie 插件用于上下文和问题回答

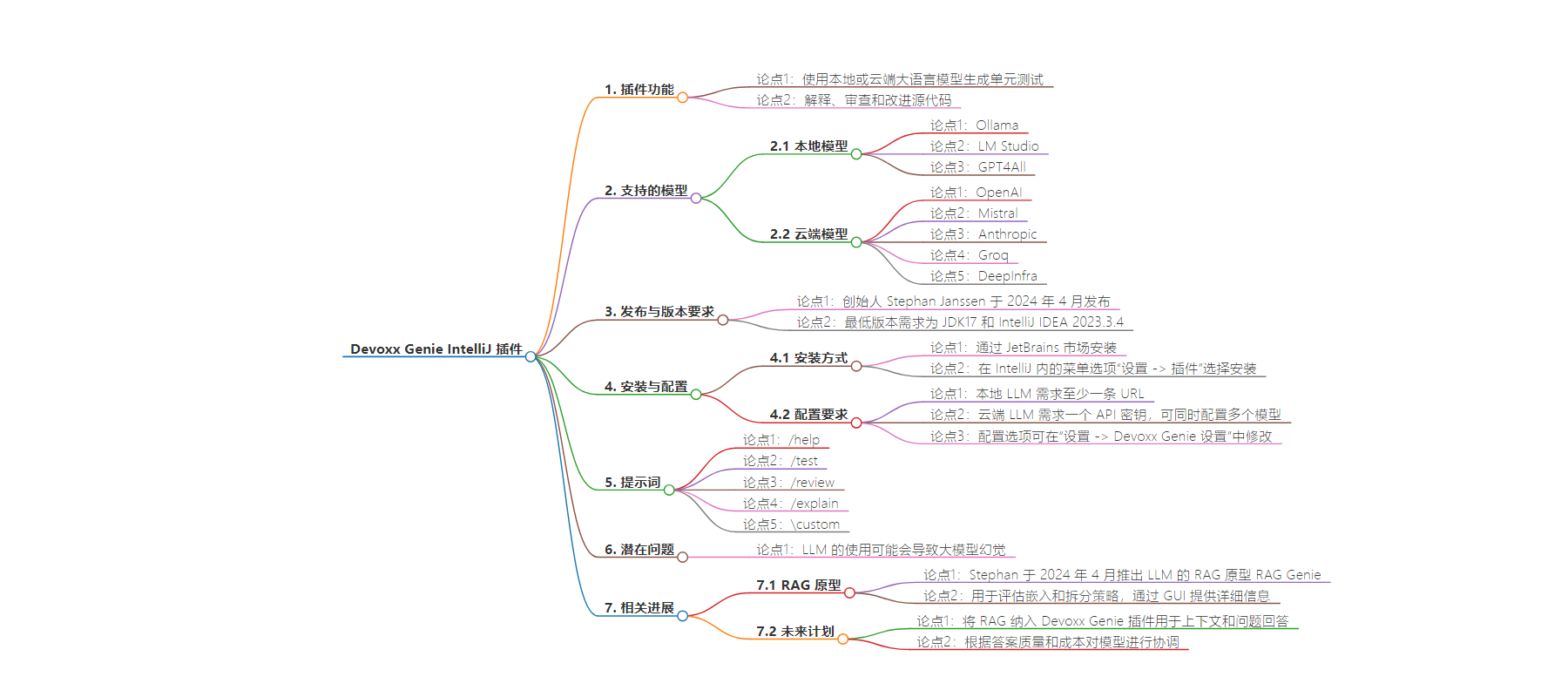

思维导图:

文章地址:https://mp.weixin.qq.com/s/4Rkg3r2VZZf4mGtBwTy0PA

文章来源:mp.weixin.qq.com

作者:Johan??Janssen

发布时间:2024/6/29 10:12

语言:中文

总字数:844字

预计阅读时间:4分钟

评分:90分

标签:软件开发,IntelliJ IDEA 插件,大语言模型,本地 LLM,云端 LLM

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

百分百基于 Java 的 JetBrains IntelliJ IDEA 插件,Devoxx Genie 使用本地或云端的大语言模型(LLM)生成单元测试,并解释、审查和改进源代码。

该插件支持本地 LLM 供应商,如 Ollama、LM Studio 以及 GPT4All。本地的 LLM 为不愿将源码上传至云端的公司提供了很好的解决方案。此外,插件也支持以下基于云端的 LLM 供应商:OpenAI、Mistral、Anthropic、Groq 以及 DeepInfra。

Devoxx(4kids)的创始人,Stephan Janssen 于 2024 年 4 月发布了 Devoxx Genie,这项插件的最低版本需求为 JDK17 和 IntelliJ IDEA 2023.3.4。

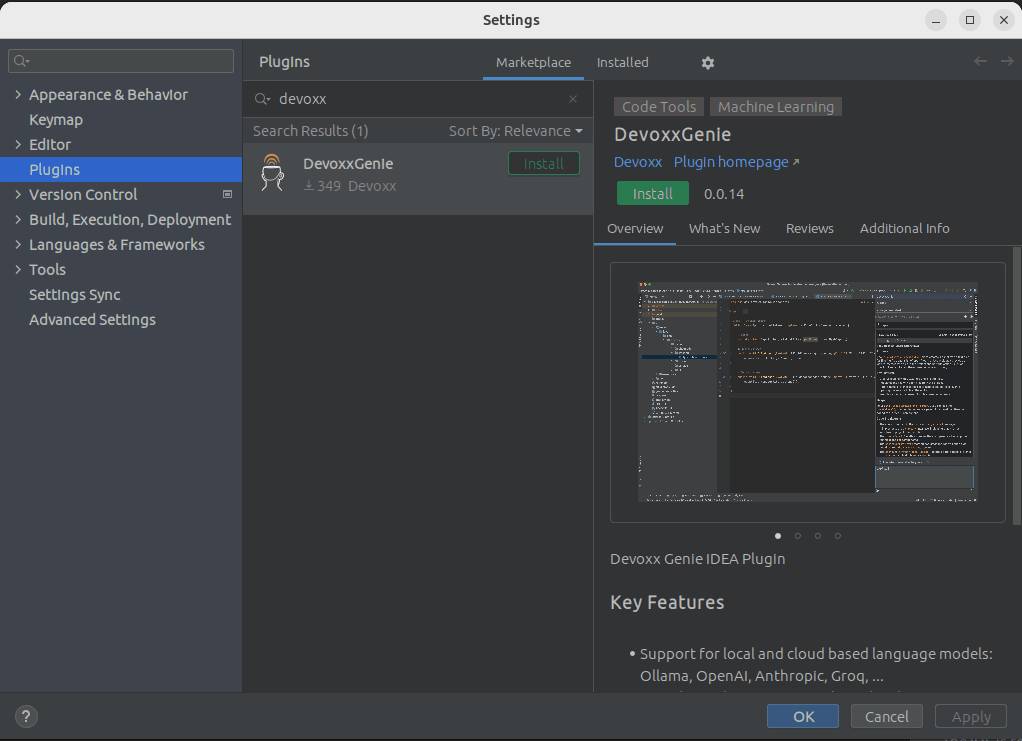

该插件可通过 JetBrains 市场安装,或在 IntelliJ 内的菜单选项“设置 -> 插件”,再选择 DevoxxGenie:

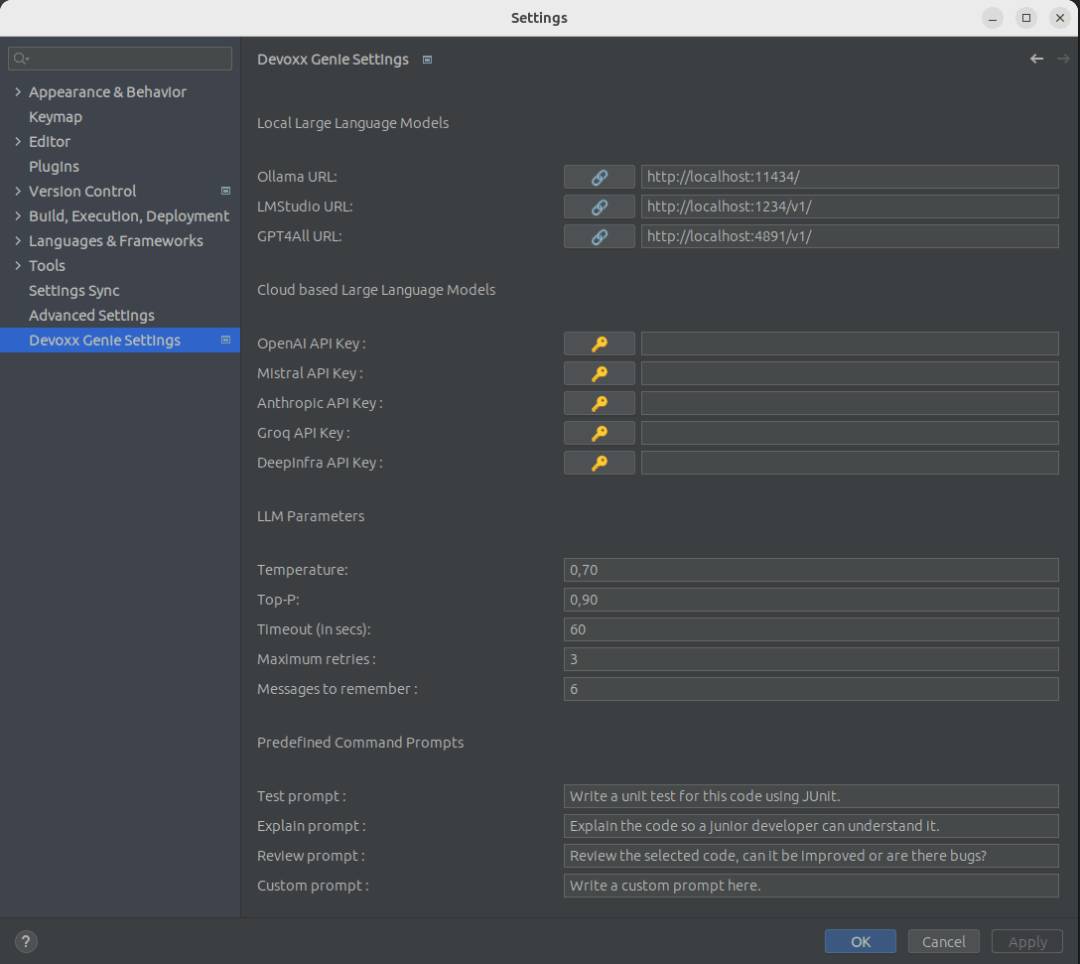

该插件对本地 LLM 需求至少一条 URL,云端 LLM 则需求一个 API 密钥,但也可同时配置多个模型。配置选项可在“设置 -> Devoxx Genie 设置”中修改:

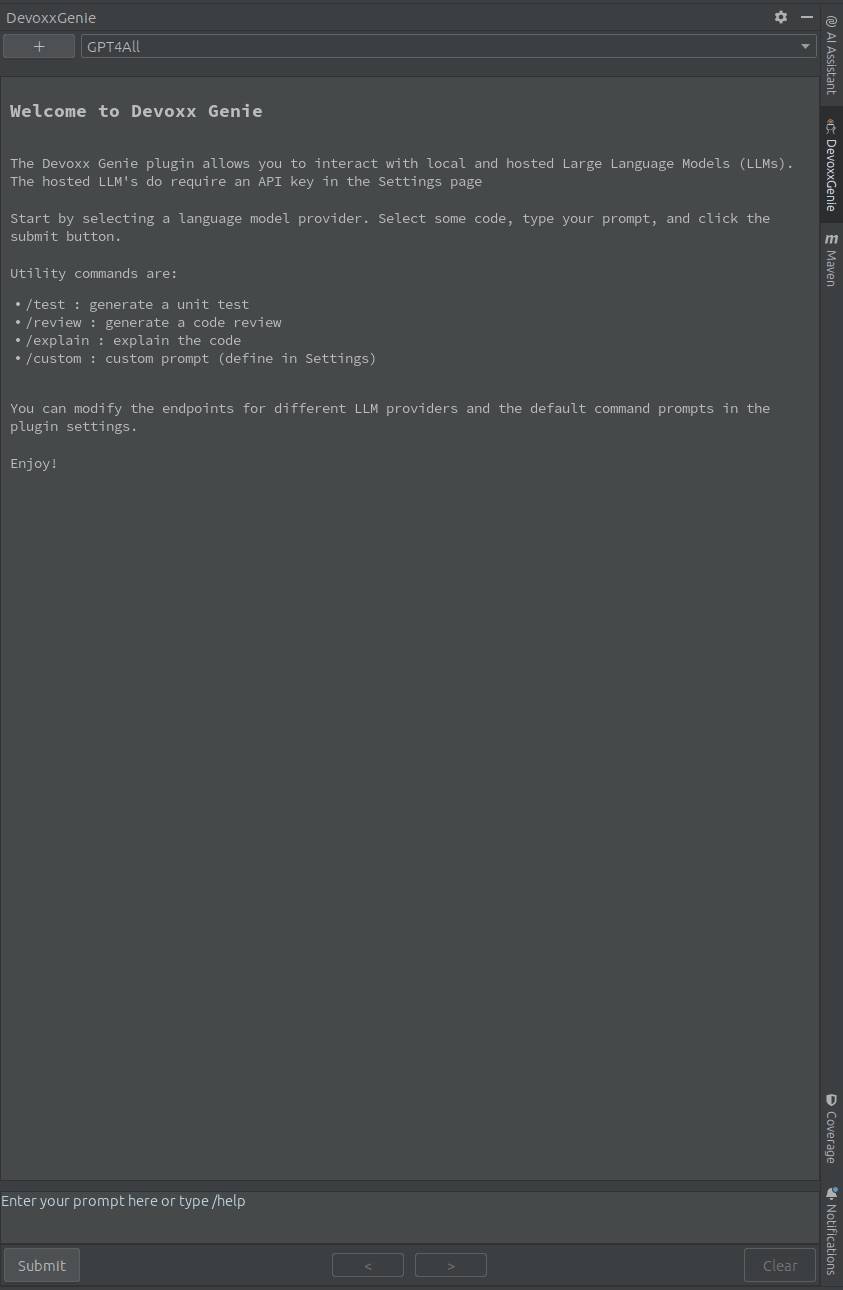

最后,在选择源码后,插件控制面板可使用 /help、/test、/review、/explain 及 \custom 提示词:

不过 LLM 的使用可能会导致大模型幻觉,也就是说答案通顺且语法正确,但事实上却不正确或无意义。检索增强生成(RAG)可被用于改进传统 LLM 的生成结果,原理是利用向量数据库或特征存储,通过提供上下文提示来增强传统的 LLM。

Stephan 还于 2024 年 4 月推出一款 LLM 的 RAG 原型,RAG Genie,用于评估嵌入和拆分策略。这项工具通过 GUI 提供详细信息,如句子的分割位置等。Stephan 在未来计划将 RAG 纳入 Devoxx Genie 插件,将其用于上下文和问题回答。RAG 还可以根据答案的质量和成本对模型进行协调,对不太重要的答案使用价格较低的模型,对较为重要的答案使用价格较高的模型。

Stephan 在法国 Devoxx 的一次分享中介绍了 RAG Genie 和 Devoxx Genie。

查看英文原文:

The Devoxx Genie IntelliJ Plugin Provides Access to Local or Cloud Based LLM Models (https://www.infoq.com/news/2024/05/devoxx-genie-intellij-plugin/)

声明:本文为 InfoQ 翻译,未经许可禁止转载。