包阅导读总结

1.

“`

AI 模型微调、Axolotl、开源项目、Huggingface 模型、配置定制

“`

2.

Axolotl 是一个在 GitHub 上受关注的开源项目,能轻松微调各种 AI 模型,支持多种主流架构和功能,配置灵活,使用方便,有稳定的维护团队,文中还给出了项目地址和成员等信息。

3.

– 背景介绍

– 人工智能模型微调过程复杂,耗时耗力。

– 项目介绍

– Axolotl 能微调各种 AI 模型,如 Huggingface 模型及多种主流架构。

– 支持通过 yaml 文件或命令行覆写定制配置,加载不同数据集格式。

– 集成多种强大功能,可在本地或云端通过 Docker 运行,结果可记录到 wandb。

– 使用方法

– 需 Python 3.9 及以上和 Pytorch 2.0 及以上,可从 GitHub 下载源代码或在项目目录用 pip 安装。

– 提供了训练、推理等操作的示例命令。

– 项目推介

– 开发团队来自 OpenAccess AI Collective,有长期维护团队。

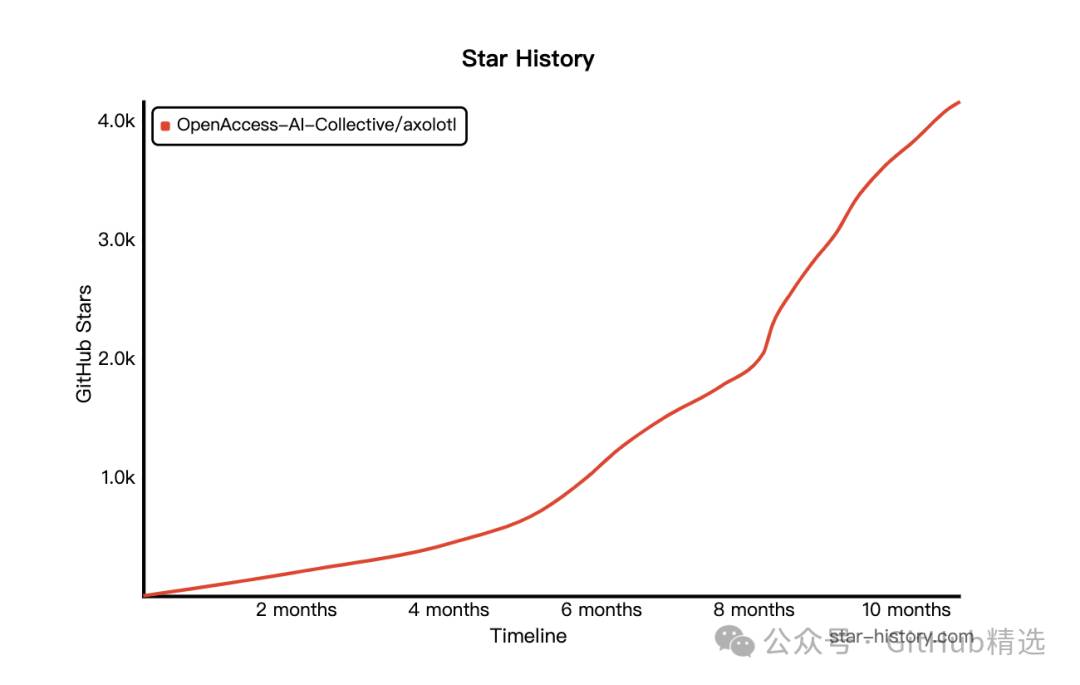

– 给出了项目 Star 趋势图、开源地址和作者及成员信息。

思维导图:

文章地址:https://mp.weixin.qq.com/s/N3bnZSnXjWmJ_8_UIlupSA

文章来源:mp.weixin.qq.com

作者:精选君

发布时间:2024/6/17 0:33

语言:中文

总字数:996字

预计阅读时间:4分钟

评分:86分

标签:AI,微调,Huggingface,开源,GitHub

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

大家好,又见面了,我是 GitHub 精选君!

背景介绍

在人工智能(AI)模型的开发过程中,通常需要对模型进行微调以适应特定任务和数据集。然而,各种模型的微调过程和配置各不相同,差异很大,涉及到的参数众多,微小的改变可能导致模型的性能有显著的差距。这使得微调成为一项耗时耗力却又关键至极的过程。如何用更少的时间和更低的复杂度细调模型,并在多个配置和架构中流畅无阻,是 AI 开发者一直在探索和实践的问题。

今天要给大家推荐一个 GitHub 开源项目 axolotl,该项目在 GitHub 有超过 2.8k Star,用一句话介绍该项目就是:“Go ahead and axolotl questions”。

项目介绍

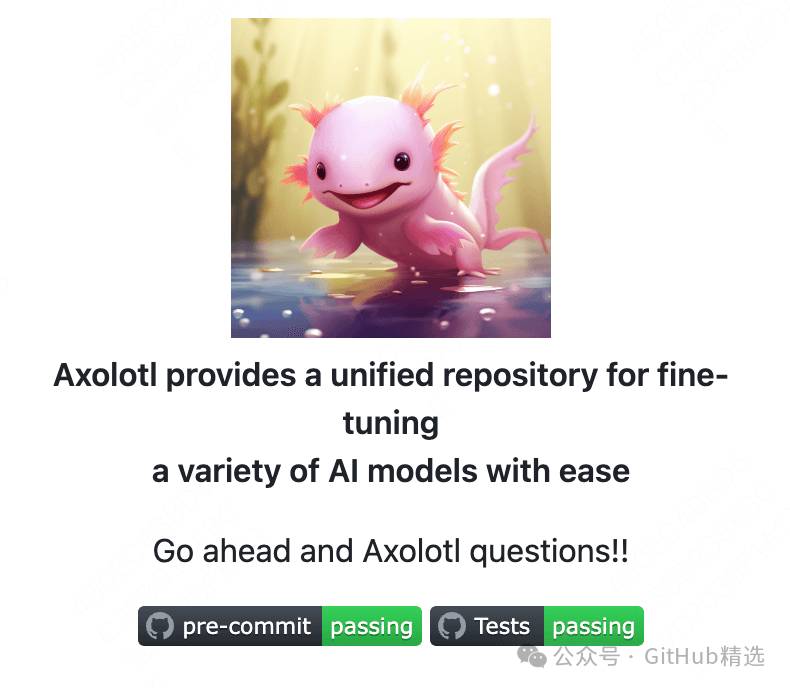

Axolotl 能帮你轻松地微调各种 AI 模型,无论是各种Huggingface模型,如llama,pythia,falcon,mpt,还是其他一些主流架构如lora、qlora、relora、gptq,Axolotl 都能提供全面的支持。

你可以通过简易的yaml文件或者命令行覆写来定制配置,支持加载不同的数据集格式,甚至可以携带自定义的分词数据集。Axolotl 还与xformer,flash attention,rope scaling,multipacking等强大功能集成,无论是使用单个GPU还是通过FSDP或Deepspeed使用多个GPU,Axolotl 都能处理。其过程可以轻松地在本地或云端通过Docker运行,并且你还可以将结果以及可选的检查点记录到wandb。

如何使用

安装 Axolotl 只需要拥有Python 3.9 或以上版本以及 Pytorch 2.0 或以上版本。你可以直接从 GitHub 下载源代码并运行 install 命令,或者在项目目录文件夹下通过 pip 运行 install 命令。

配置完成后,你就可以开始进行微调操作了,无论是训练、推理还是其他操作,只需要一行命令,轻松完成。以下是一些示例:

#preprocessdatasets-optionalbutrecommended

CUDA_VISIBLE_DEVICES=""python-maxolotl.cli.preprocessexamples/openllama-3b/lora.yml

#finetunelora

acceleratelaunch-maxolotl.cli.trainexamples/openllama-3b/lora.yml

#inference

acceleratelaunch-maxolotl.cli.inferenceexamples/openllama-3b/lora.yml\

--lora_model_dir="./lora-out"

#gradio

acceleratelaunch-maxolotl.cli.inferenceexamples/openllama-3b/lora.yml\

--lora_model_dir="./lora-out"--gradio项目推介

项目的开发团队来自 OpenAccess AI Collective,这是一个主张 AI 开放的团体。Axolotl 有一队长期维护并保障其运行稳定和功能更新的工程师团队,你无需担心项目的维护和更新问题,并可以享受到这个开源项目带来的所有优点。

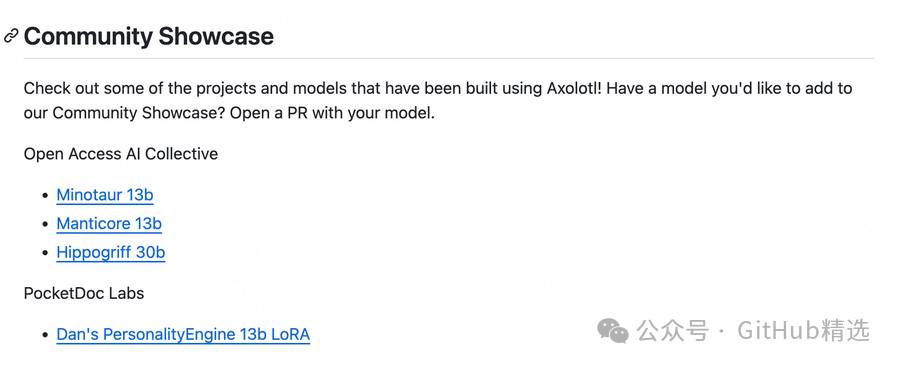

以下是该项目 Star 趋势图(代表项目的活跃程度):

更多项目详情请查看如下链接。

开源项目地址:https://github.com/OpenAccess-AI-Collective/axolotl

开源项目作者:OpenAccess-AI-Collective

以下是参与项目建设的所有成员:

关注我们,一起探索有意思的开源项目。

点击如下卡片后台回复:加群,与技术极客们一起交流人工智能、开源项目,一起成长。如果你正在寻求开源项目推广、DevOps、AIGC 大模型、软件开发等领域的付费服务,可参考推文了解详情。