包阅导读总结

1. `Falcon Mamba 7B`、`Mamba 架构`、`长序列处理`、`开源模型`、`性能提升`

2. Falcon Mamba 7B 模型采用 Mamba 架构换掉 Transformer,性能全方位提升,能处理任意长序列且内存需求不增,在多个方面表现出色,遵循开放协议,在 Hugging Face、GitHub 可访问。

3.

– 模型介绍

– Falcon Mamba 7B 采用 Mamba 状态空间语言模型架构,取消传统注意力机制。

– 能处理无限长序列,内存需求不增加,生成每个 token 时间基本一样。

– 性能优势

– 全方位超越一众开源模型,如 Llama-3.1(8B) 等。

– 基于第一代 Mamba,结合 RNN 和 CNN 特点,设计硬件感知并行算法,简化架构。

– 训练与应用

– 用 5500GT 数据训练,后期增加高质量策划数据。

– 使用额外 RMS 标准化层确保训练稳定。

– 支持多种 Hugging Face API,有指令调优版本,准确性更高。可在 Hugging Face、GitHub 访问。

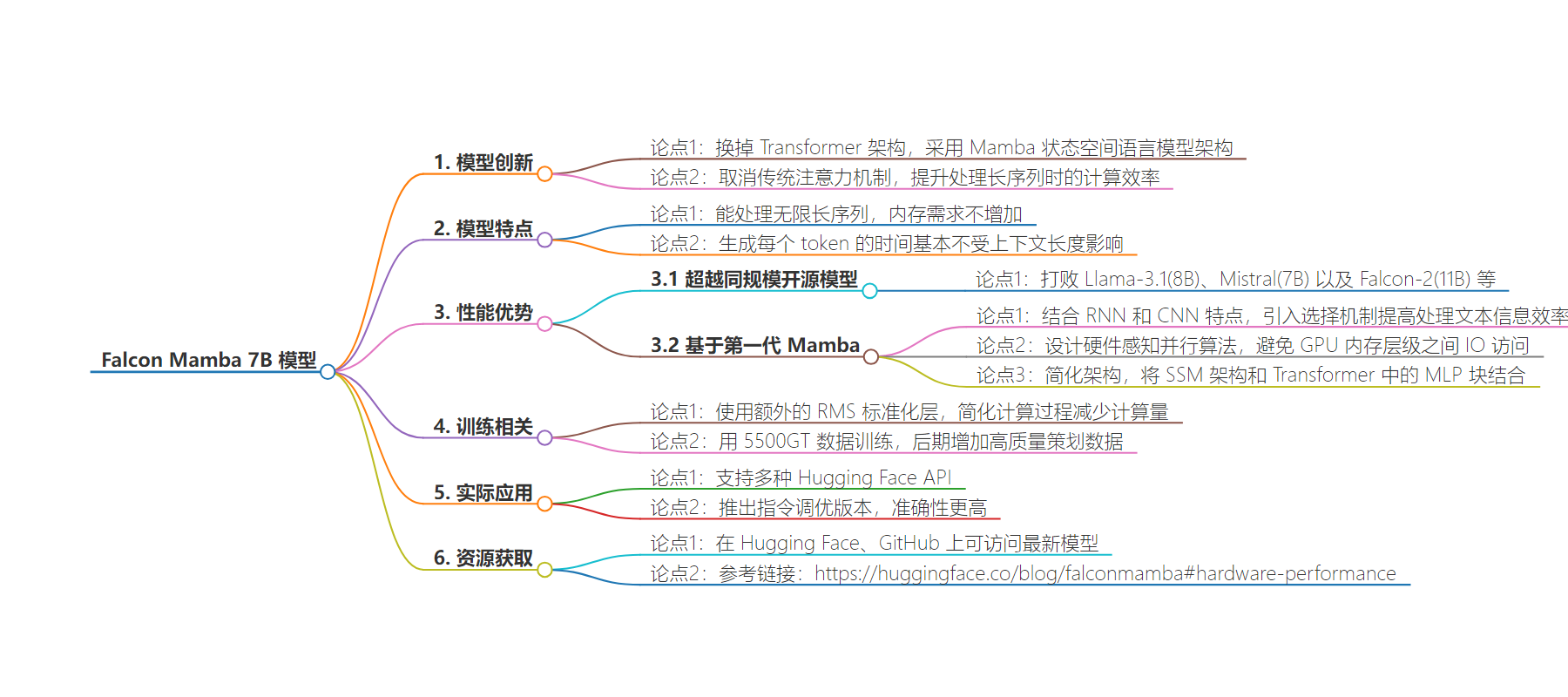

思维导图:

文章地址:https://www.qbitai.com/2024/08/178445.html

文章来源:qbitai.com

作者:明敏

发布时间:2024/8/13 6:48

语言:中文

总字数:1176字

预计阅读时间:5分钟

评分:84分

标签:AI模型,状态空间模型,开源,长序列处理,计算效率

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

换掉Transformer,7B开源模型立刻登顶!任意长序列都能处理

明敏2024-08-1314:48:09 来源:量子位

明敏2024-08-1314:48:09 来源:量子位 明敏 发自 凹非寺

量子位 | 公众号 QbitAI

只是换掉Transformer架构,立马性能全方位提升,问鼎同规模开源模型!

(注意力机制不存在了)

这就是最新Falcon Mamba 7B模型。

它采用Mamba状态空间语言模型架构来处理各种文本生成任务。

通过取消传统注意力机制,有效提升了模型处理长序列时计算效率低下的问题。

它可以处理无限长序列,但内存需求不增加。

无论上下文多长,生成每个token的时间基本一样。

由此,Falcon Mamba模型性能全方位提升,打败一众Transformer架构模型,如Llama-3.1(8B)、Mistral(7B)以及Falcon-2(11B)。

如上成果由阿联酋阿布扎比技术创新研究所(TII)带来,他们正是Falcon模型的开发团队。

该系列共包含四个模型:基础版本、指令微调版本、4bit版本和指令微调4bit版本。

最新模型遵循TII Falcon License 2.0开放协议,它在Apache 2.0协议下。

围观网友直呼:游戏规则要改变了!

全球首个开源SSLM

在性能上,Falcon Mamba 7B全方位超越一众开源模型。

它基于第一代Mamba。

Mamba是一种状态空间模型(SSM,State Space Model)。它结合了RNN和CNN的特点,通过引入一种选择机制,它允许模型根据当前的输入有选择地传播或忘记信息,从而提高处理文本信息的效率。

同时,它设计了一种硬件感知的并行算法,以递归模式运行,避免了GPU内存层级之间IO访问,提高计算效率。

最后它还简化了架构,将SSM架构和Transformer中的MLP块结合为单一的块。

从Transformer换到Mamba,能够让Falcon模型可以处理任意长序列,但无需增加内存。尤其适合单个A10 24GB GPU。

研究还讨论了两种不同的处理序列方法。

并行预填充方法适用于GPU并行处理,对内存需求较高;顺序填充方法适用于SSM模型,可以处理任意长度序列,从而不会受到内存限制。

为了确保大规模训练稳定,Falcon Mamba模型使用了额外的RMS标准化层。

RMS标准化层能够简化LayerNorm的计算过程,可减少计算量。

模型使用了5500GT数据训练,这些数据主要来自RefedWeb数据集以及公开数据。训练过程基本匀速,在训练后期增加了一小部分高质量策划数据,这有助于模型在最后阶段的优化。

在H100上,批大小为1、提示词长度为1-130k生成token的测试中,Falcon Mamba能够在生成新token时保持稳定的吞吐量,这意味着它的性能不受文本长度影响,可以稳定处理长序列,不会出现性能下降情况。

Falcon Mamba支持多种Hugging Face API,包括AutoModelForCausalLM、pipline。

还推出了一个指令调优版本,通过额外50亿个token进行微调,可以让模型准确性更高。

在Hugging Face、GitHub上都可访问最新模型~

参考链接:

https://huggingface.co/blog/falconmamba#hardware-performance

版权所有,未经授权不得以任何形式转载及使用,违者必究。