包阅导读总结

思维导图:

文章地址:https://mp.weixin.qq.com/s/oRS121Z1H7mLDCAaR9aXaQ

文章来源:mp.weixin.qq.com

作者:LLM??SPACE

发布时间:2024/7/16 13:06

语言:中文

总字数:3061字

预计阅读时间:13分钟

评分:90分

标签:大语言模型,多模态模型,语言模型,Qwen2,音频处理

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

我们希望能够搭建一个AI学习社群,让大家能够学习到最前沿的知识,大家共建一个更好的社区生态。

https://www.feishu.cn/community/article/wiki?id=7355065047338450972

点击「订阅社区精选」,即可在飞书每日收到《大模型日报》每日最新推送

如果想和我们空间站日报读者和创作团队有更多交流,欢迎扫码。

欢迎大家一起交流!

论文

Qwen2技术报告

http://arxiv.org/abs/2407.10671v1

http://arxiv.org/abs/2407.10671v1Qwen2-Audio 技术报告

http://arxiv.org/abs/2407.10759v1

http://arxiv.org/abs/2407.10759v1竞技学习:通过模拟聊天机器人竞技场为LLM后期培训构建数据飞轮

http://arxiv.org/abs/2407.10627v1

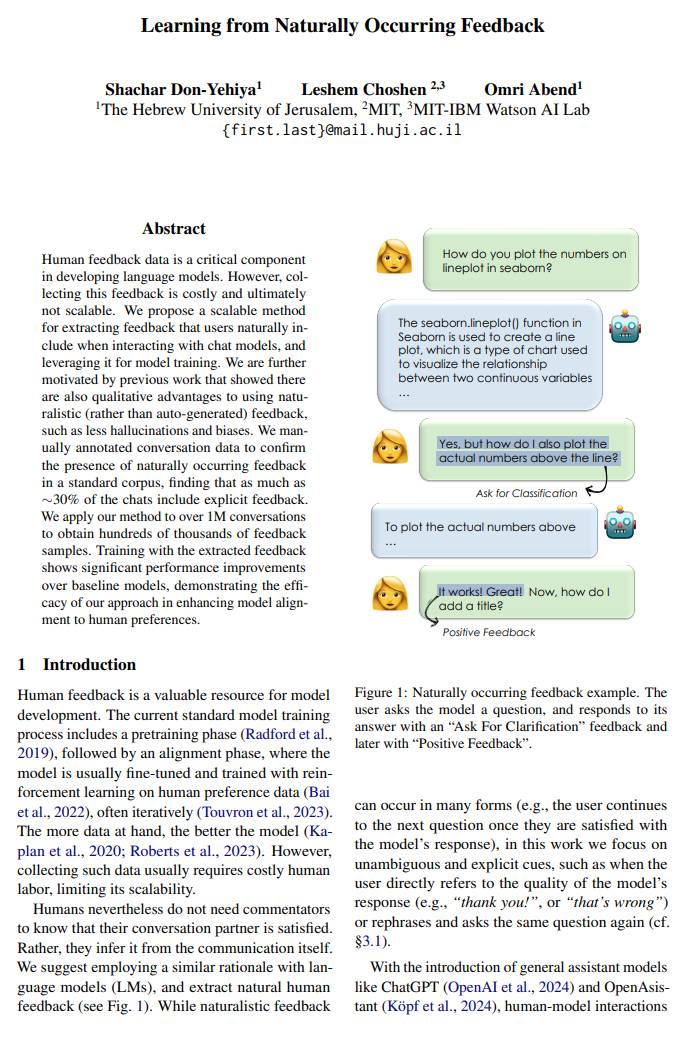

http://arxiv.org/abs/2407.10627v1从自然反馈中学习

http://arxiv.org/abs/2407.10944v1

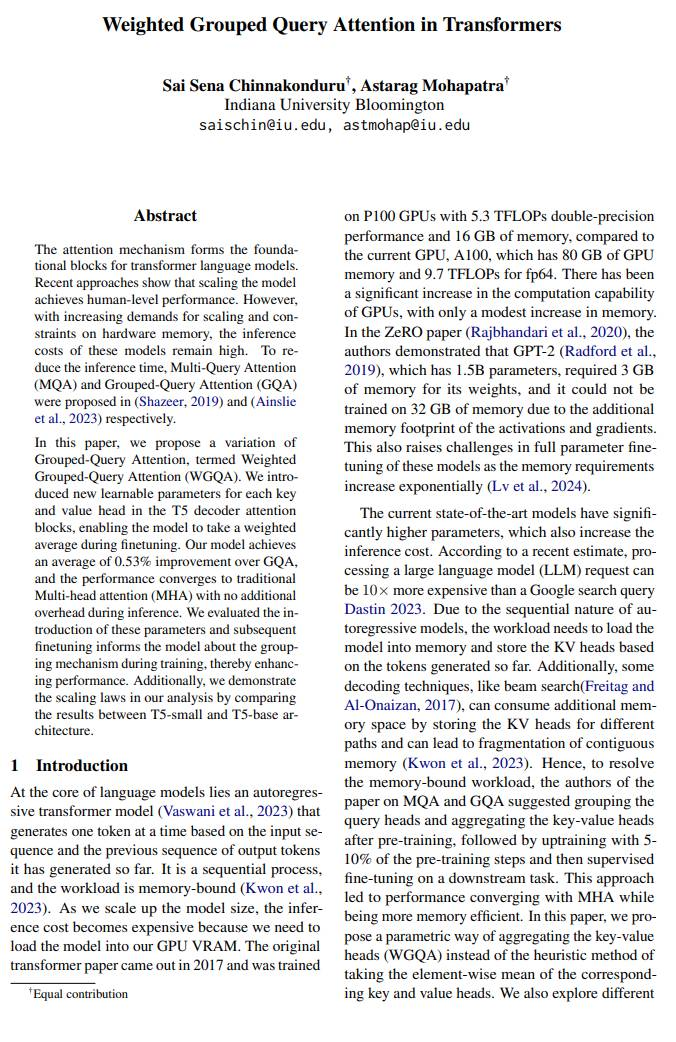

http://arxiv.org/abs/2407.10944v1Transformer中的加权分组查询注意力

http://arxiv.org/abs/2407.10855v1

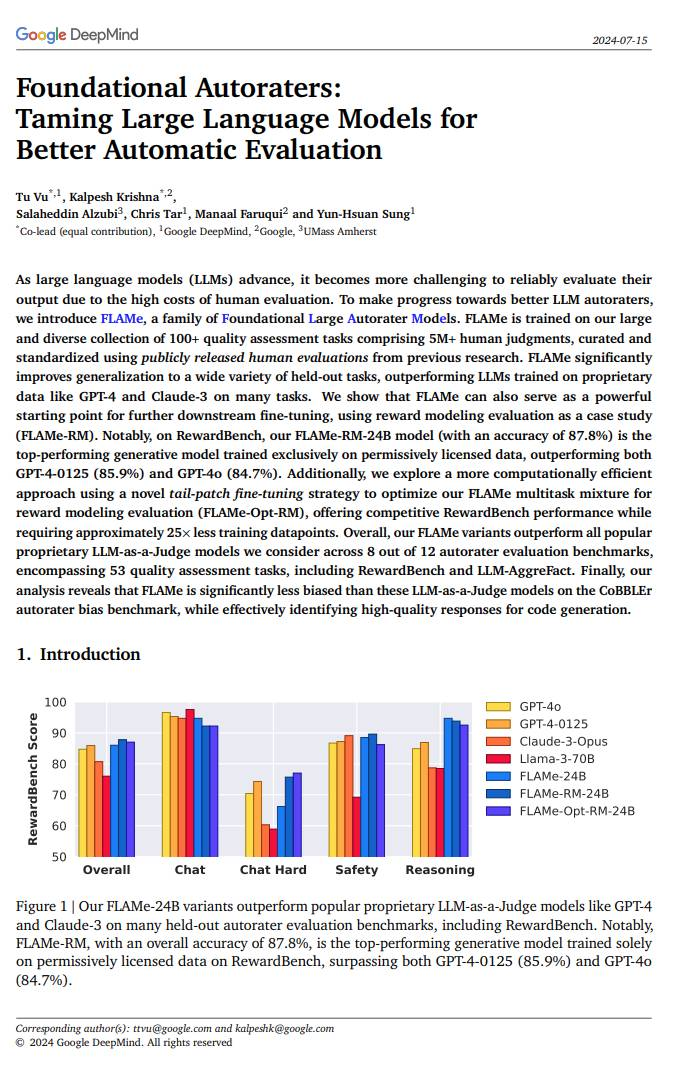

http://arxiv.org/abs/2407.10855v1基础自动评估者:驯服大语言模型以实现更好的自动评估

http://arxiv.org/abs/2407.10817v1

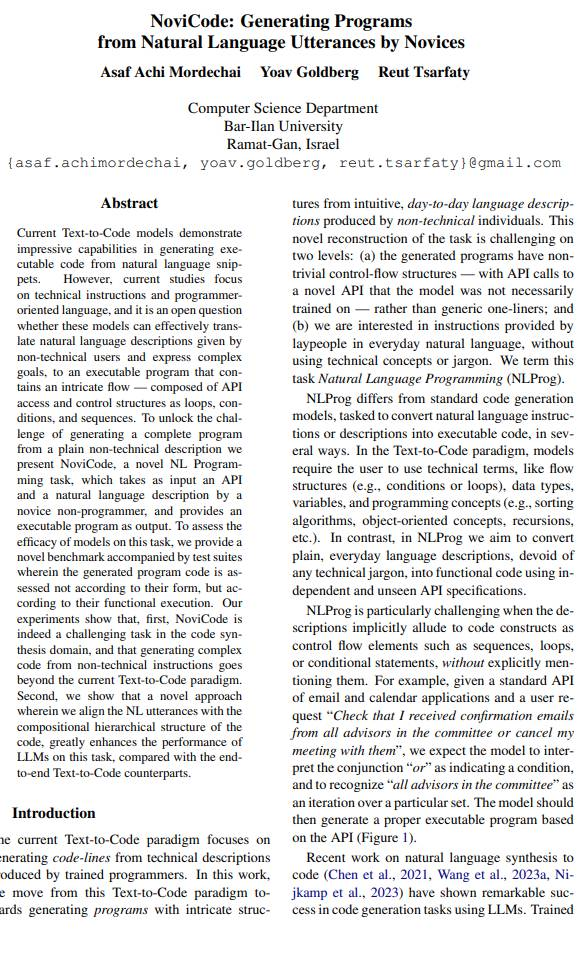

http://arxiv.org/abs/2407.10817v1NoviCode:基于编程新手的指令生成程序

http://arxiv.org/abs/2407.10626v1

http://arxiv.org/abs/2407.10626v1llm-graph-builder

baml

https://github.com/BoundaryML/baml

https://github.com/BoundaryML/baml-

— END —