包阅导读总结

1. 关键词:大模型、机器学习、推理加速、机器人、开源

2. 总结:7 月 24 日学术篇涵盖了多个领域的内容,包括波士顿动力的机器人控制技术、ServerlessLLM 的创新、CUTLASS 版本的进展、推理加速的总结、NVIDIA 开源 GPU 内核模块等。

3. 主要内容:

– 大模型日报

– 希望搭建 AI 学习社群

– 介绍波士顿动力在机器人控制中机器学习的归纳偏好

– 技术文章

– ServerlessLLM 的概念及优势

– CUTLASS 2.x 与 3.x 的特点

– Cutlass swizzle 机制解析

– 学习推理加速的总结与展望

– 行业动态

– NVIDIA 全面转向开源 GPU 内核模块

– Robotaxi 的相关要求及技术应用

– 大型语言模型相关的资源收集项目

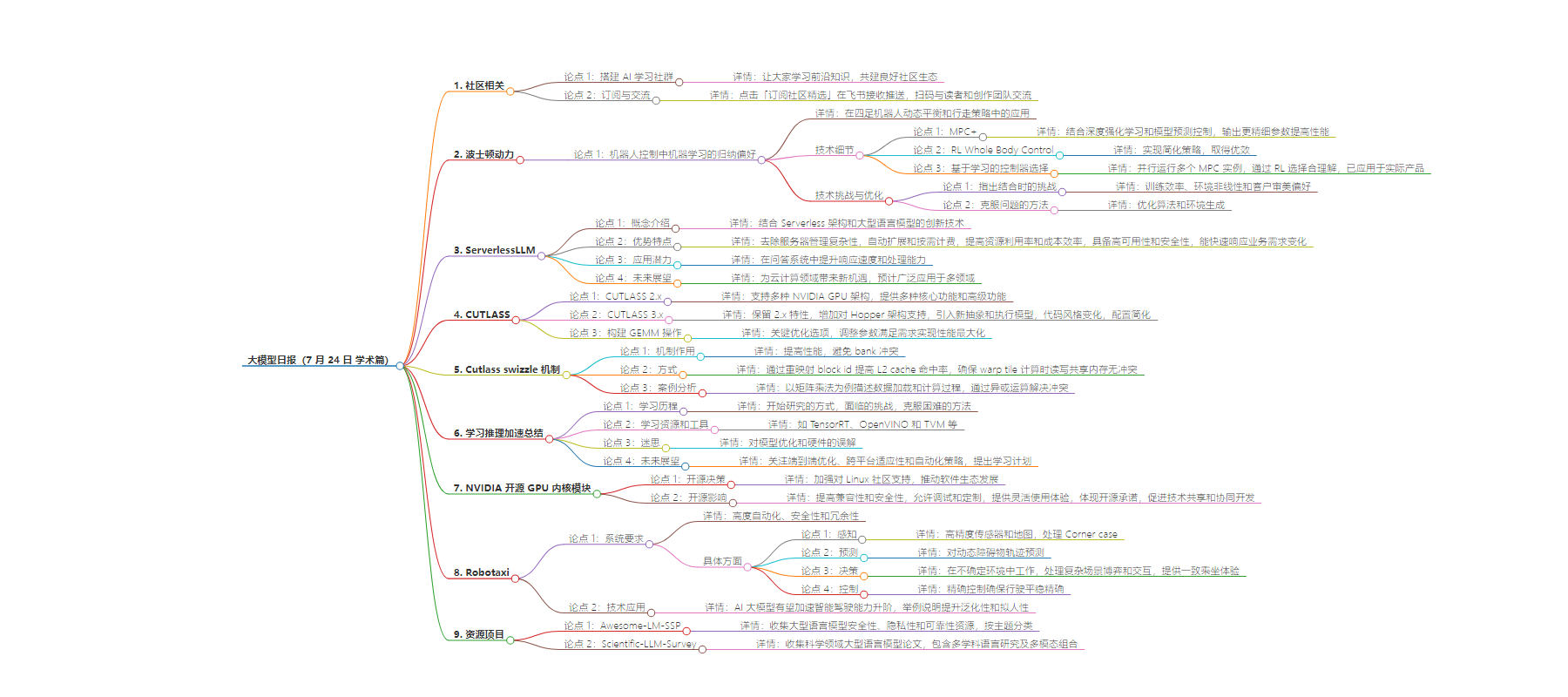

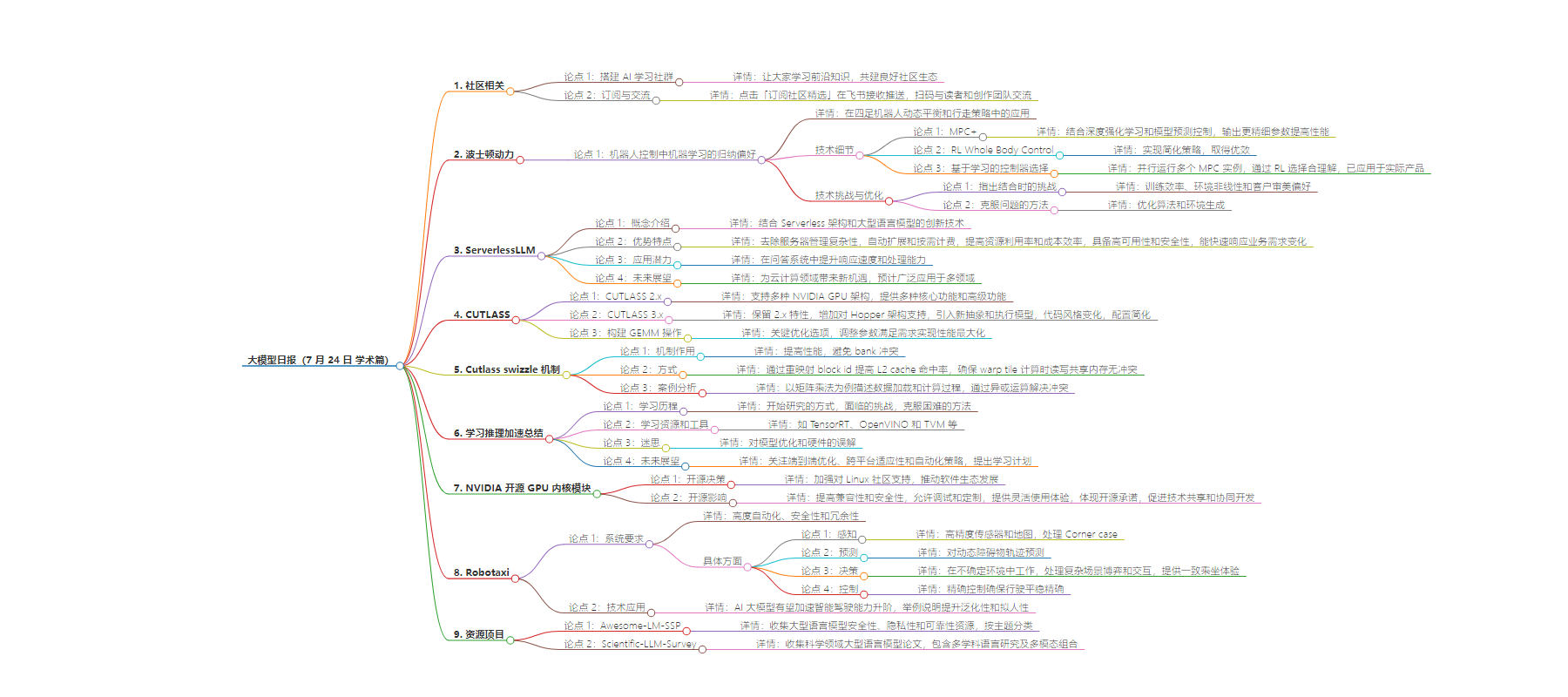

思维导图:

文章地址:https://mp.weixin.qq.com/s/-Zza8vexwqyoeAgaBNXaQQ

文章来源:mp.weixin.qq.com

作者:LLM??SPACE

发布时间:2024/7/24 13:52

语言:中文

总字数:2662字

预计阅读时间:11分钟

评分:88分

标签:技术动态,AI 应用,机器人技术,Serverless 架构,CUDA 库

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

我们希望能够搭建一个AI学习社群,让大家能够学习到最前沿的知识,大家共建一个更好的社区生态。

https://www.feishu.cn/community/article/wiki?id=7355065047338450972

点击「订阅社区精选」,即可在飞书每日收到《大模型日报》每日最新推送

如果想和我们空间站日报读者和创作团队有更多交流,欢迎扫码。

欢迎大家一起交流!

学习

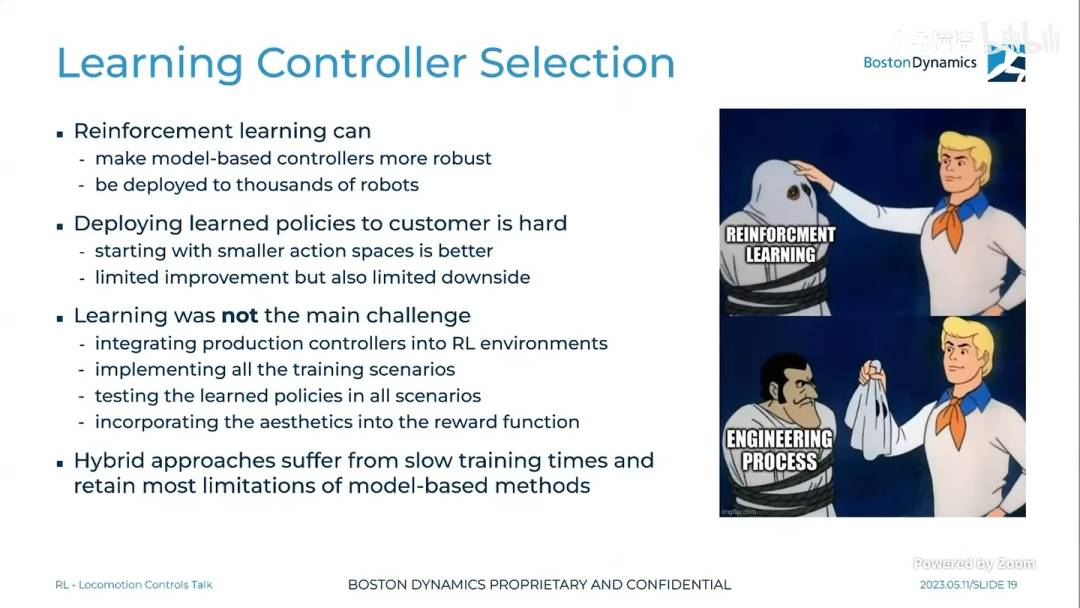

波士顿动力:机器人与控制中机器学习的归纳偏好(四足部分)(RSS 2024)

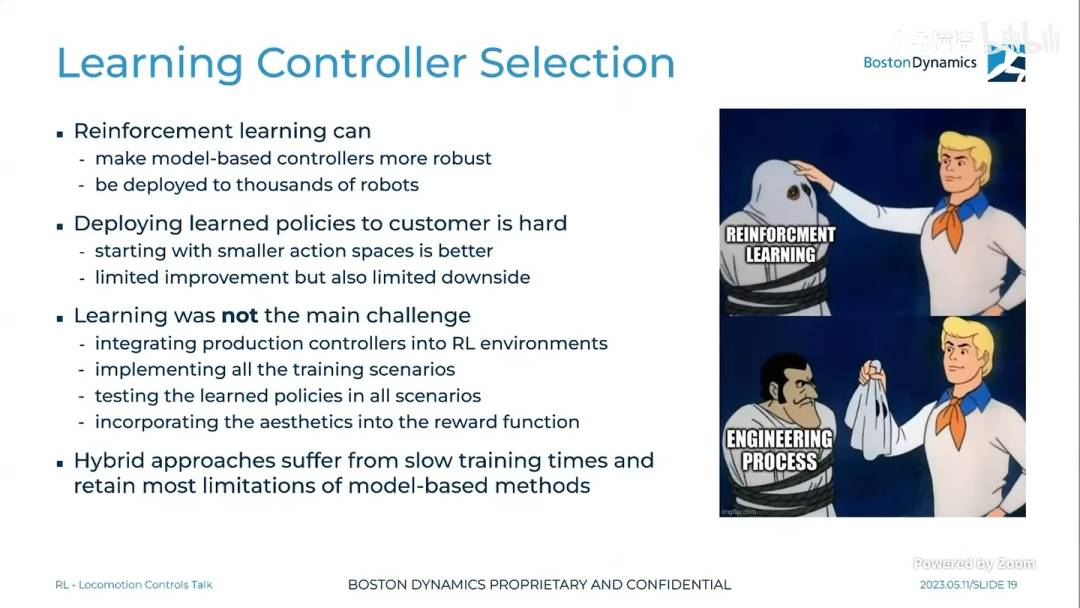

在 RSS 2024 的工作坊上,波士顿动力探讨了机器人控制中机器学习的归纳偏好,特别是在四足机器人的动态平衡和行走策略中的应用。技术细节包括:

-

MPC+: 结合了深度强化学习(RL)和模型预测控制(MPC),使得 RL 策略能够输出更精细的落脚点、接触序列和速度修正量,以提高 MPC 的性能。

-

RL Whole Body Control: 实现了一个简化的 PMTG 策略,不依赖特权信息或复杂训练方法,取得了与量产 MPC 算法相当甚至更优的效果。

-

基于学习的控制器选择: BD 采用了并行运行多个 MPC 实例的策略,并通过 RL 选择最合理的解,这一方法已在实际产品中得到应用。

-

技术挑战与优化: 指出了 RL 与 MPC 结合时的技术挑战,如训练效率、环境非线性和客户审美偏好,以及如何通过优化算法和环境生成来克服这些问题。

https://zhuanlan.zhihu.com/p/709997736?utm_psn=1799347579873550337

https://zhuanlan.zhihu.com/p/709997736?utm_psn=1799347579873550337

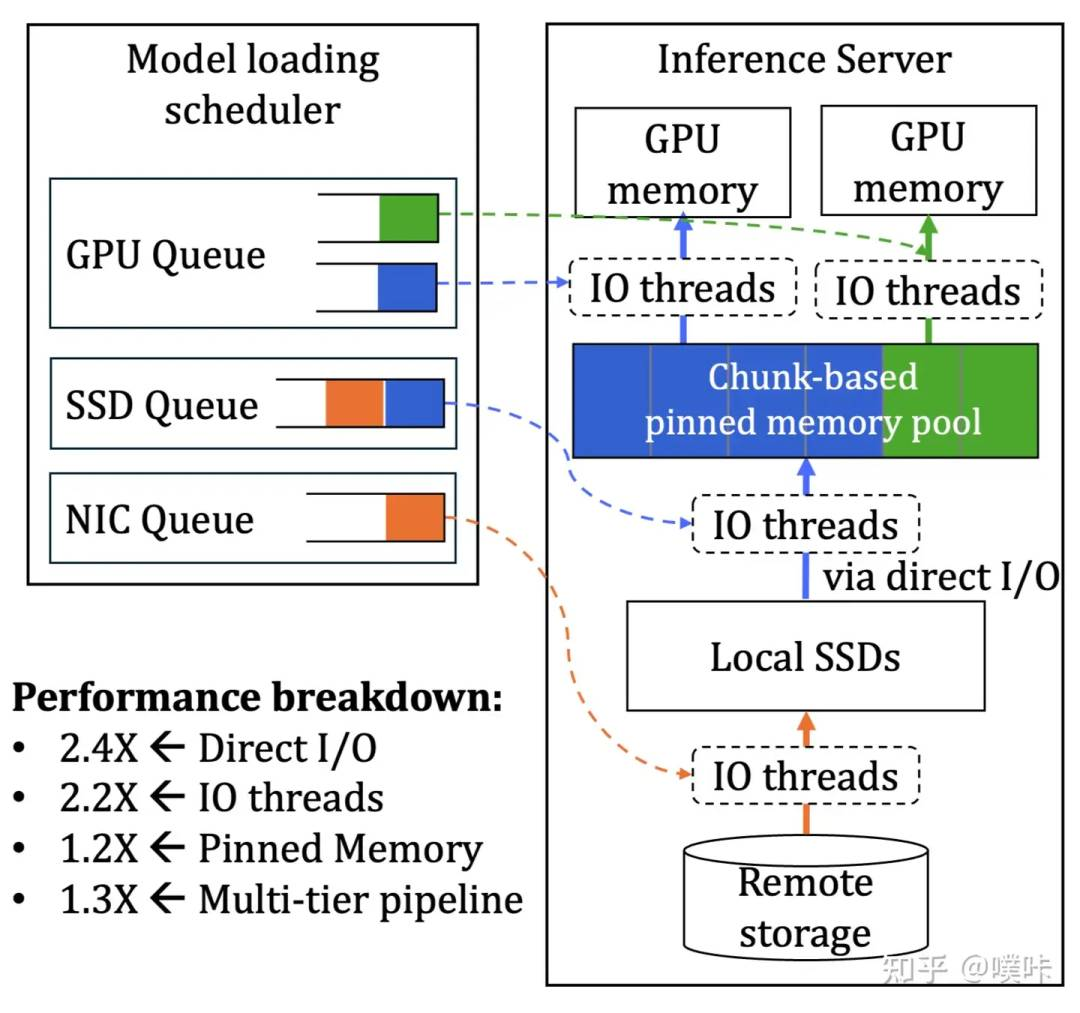

第一视角下关于 ServerlessLLM 的故事(上)

文章详细介绍了 ServerlessLLM 的概念,它是一种结合 Serverless 架构和大型语言模型的创新技术。ServerlessLLM 通过去除服务器管理的复杂性,实现了自动扩展和按需计费,显著提高了资源利用率和成本效率。此外,该架构还具备高度的可用性和安全性,能够快速响应业务需求变化。通过具体案例分析,ServerlessLLM 在问答系统中的应用展示了其在提升系统响应速度和处理能力方面的潜力。作者认为,ServerlessLLM 为云计算领域带来了新的发展机遇,预计未来将广泛应用于多个领域。

https://zhuanlan.zhihu.com/p/710476102?utm_psn=1799348933778092032

https://zhuanlan.zhihu.com/p/710476102?utm_psn=1799348933778092032

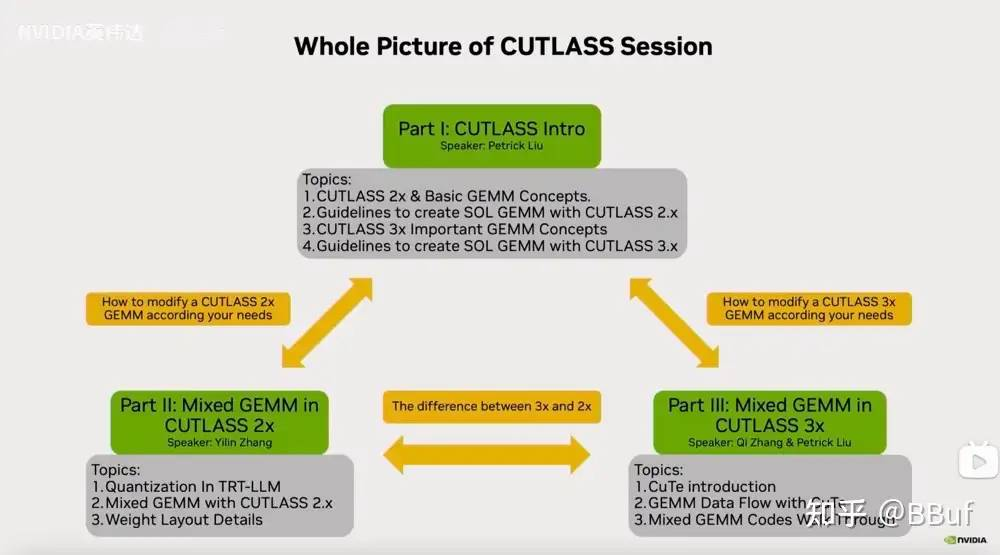

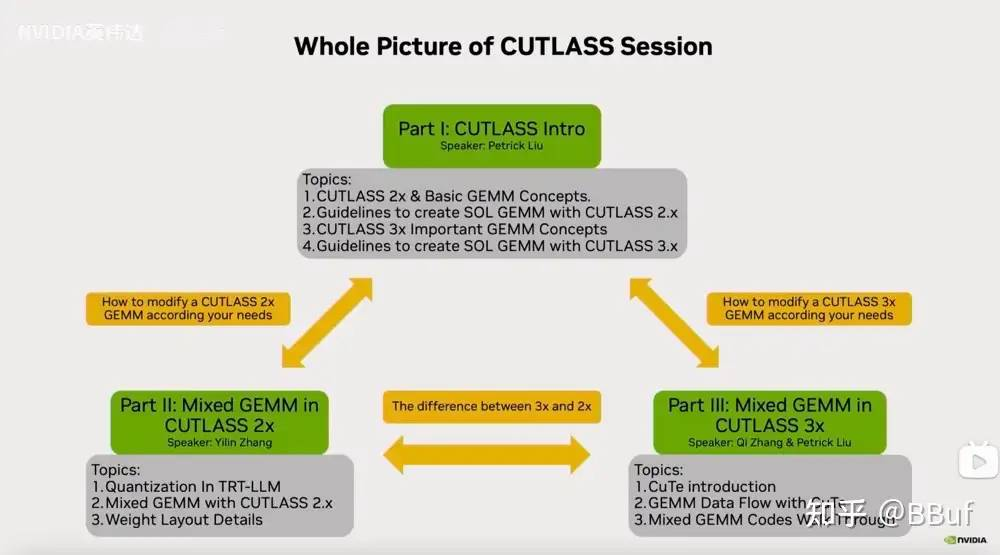

CUTLASS 2.x & CUTLASS 3.x Intro 学习笔记

CUTLASS 是 NVIDIA 推出的一个 CUDA C++ 模板库,旨在提供高效的线性代数运算,特别是矩阵乘法(GEMM)。CUTLASS 2.x 支持多种 NVIDIA GPU 架构,包括 Ada、Ampere、Turing 和 Volta,提供了多种核心功能,如 GEMM、卷积和稀疏 GEMM,以及对 Group GEMM、B2B GEMMs、FMHA 的支持。它还支持 GEMM layernorm 融合、GEMM softmax 融合等高级功能。在 CUTLASS 3.x 中,除了保留 2.x 版本的特性,还增加了对 Hopper 架构的支持,引入了 CuTe 抽象,并采用了新的执行模型,如 TMA、wgmma 和集群配置,以及持久化风格和生产者 – 消费者模型,以进一步提高性能。CUTLASS 3.x 的代码风格有显著变化,配置更加简化,主要需要指定矩阵的元素类型、布局和对齐方式,以及核心 kernel 配置。此外,文章还详细介绍了如何在 CUTLASS 2.x 和 3.x 中构建 GEMM 操作,包括关键的优化选项,如 ThreadBlockShape、WarpShape、InstructionShape 等,以及如何通过调整这些参数来满足不同的需求,并实现性能的最大化。

https://zhuanlan.zhihu.com/p/710516489?utm_psn=1799349278482755585

https://zhuanlan.zhihu.com/p/710516489?utm_psn=1799349278482755585

cutlass swizzle机制解析(一)

Cutlass 是一个高性能的 CUDA 库,用于实现通用矩阵乘法(GEMM)。在 Cutlass 的 GEMM 实现中,swizzle 机制扮演着重要角色,它主要通过两种方式提高性能:一是通过 Thread Block Swizzle 重映射 block id,改变其发射顺序以提高 L2 cache 命中率;二是确保在进行 warp tile 计算时,读写共享内存是无 bank 冲突的。共享内存被组织成 32 路 bank,每路 4 字节,当一个 warp 中的不同线程访问同一个 bank 时,访问过程将会被串行化,影响效率。为了避免这种情况,swizzle 机制通过物理 layout 到逻辑 layout 的重映射确保读写过程中不会发生 bank 冲突。文章以一个 16x8x16xfp16 大小的矩阵乘法为例,详细描述了 ldmatrix 指令如何从共享内存加载数据到寄存器文件,然后通过 mma 指令进行计算。为了完成这一过程,需要分成多个 phase,每个 phase 负责读取一个 8x8xfp16 矩阵,并确保每个线程读取的 4 bank 数据连续,但线程间的数据不要求连续。通过对 bank 冲突的讨论,文章指出只有传给 ldmatrix 每个线程的地址合理,才能避免 bank 冲突。最后,文章通过一个 Swizzle<3, 3, 3> 的例子,说明了 swizzle 机制如何通过异或运算对矩阵元素进行重映射,以解决 bank 冲突问题。

https://zhuanlan.zhihu.com/p/710337546?utm_psn=1799350115741331457

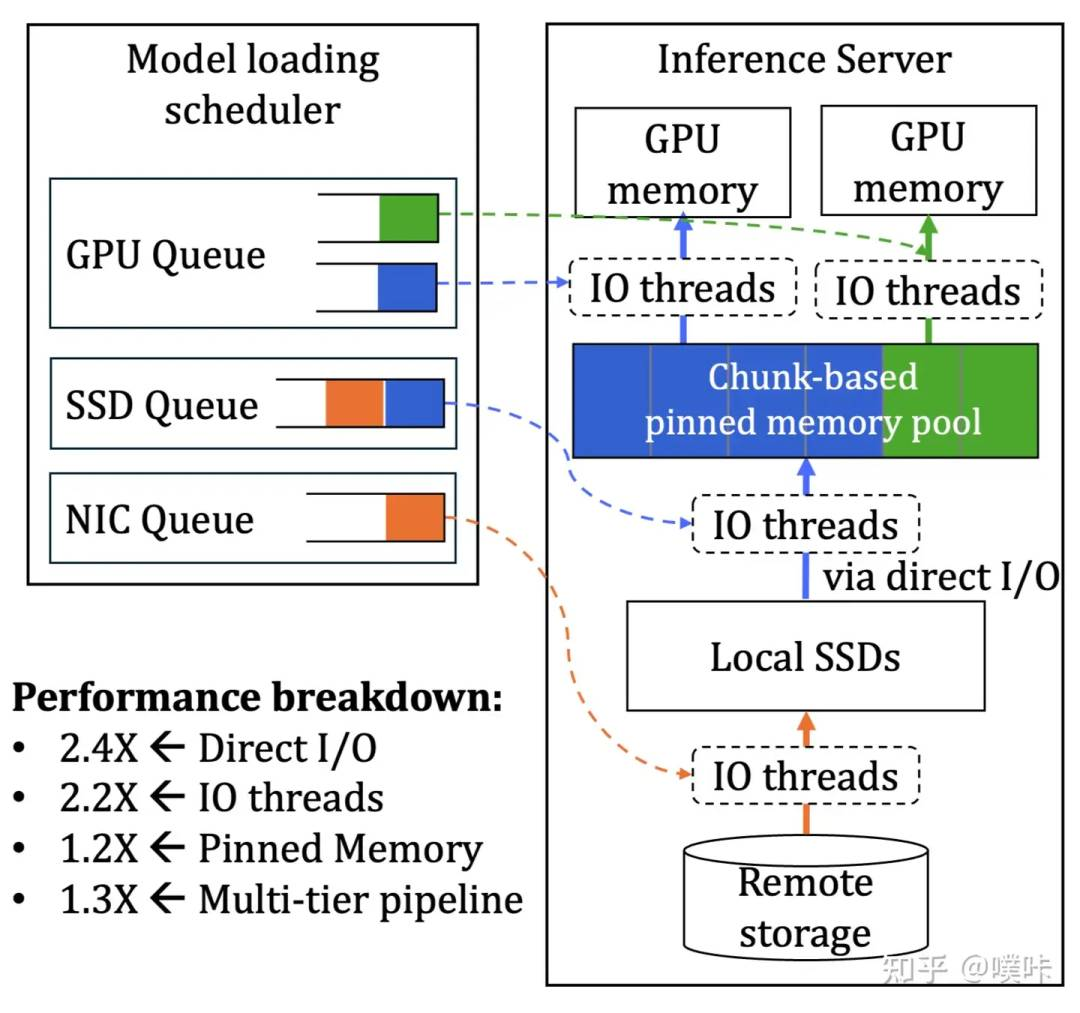

笔记:学习推理加速半年之总结与迷思

作者首先介绍了自己是如何开始研究推理加速的,包括阅读相关论文、编写代码实践以及参与开源项目。在学习过程中,作者面临了理解复杂算法、掌握软件工具以及优化性能的挑战。为了克服这些困难,作者采取了阅读更多资料、参与社区讨论以及不断实践的方法。

作者在文章中分享了一些关键的学习资源和工具,如 TensorRT、OpenVINO 和 TVM 等。同时,文章还提到了在推理加速领域遇到的一些迷思,例如对于模型优化的误解以及对硬件的不同理解。作者强调,推理加速不仅仅是提高速度,还包括降低延迟、减少功耗和资源消耗等多个方面。

最后,作者对未来的学习方向和行业发展趋势进行了展望。预测未来推理加速将更加关注端到端的优化、跨平台的适应性以及自动化的优化策略。作者也提出了自己的学习计划,包括深入研究某一领域的特定问题、参与更多的实际项目以及持续关注行业动态。

https://zhuanlan.zhihu.com/p/704938096?utm_psn=1799350718194397186

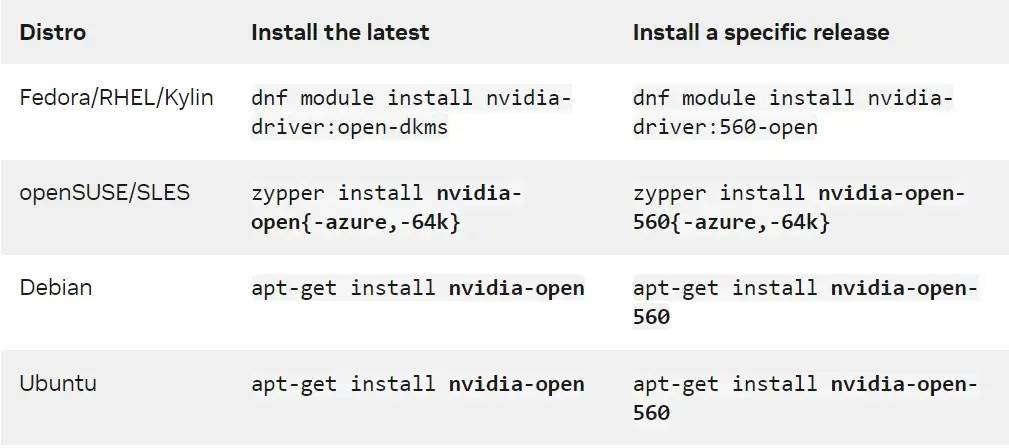

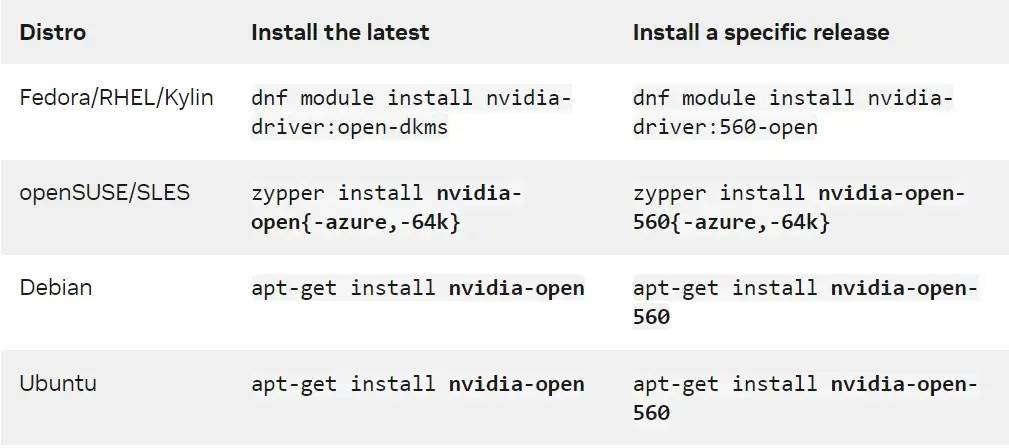

NVIDIA 全面转向开源 GPU 内核模块

NVIDIA 宣布开源其 GPU 内核模块,这标志着公司对 Linux 社区的支持加强,并将推动软件生态系统的发展。开源驱动程序将提高兼容性和安全性,同时允许更多的调试和定制,为开发者和高级用户提供更灵活的使用体验。这一决策体现了 NVIDIA 对开放源代码和软件自由原则的承诺,预计将促进技术共享和协同开发,推动计算机科技行业的进步。

https://zhuanlan.zhihu.com/p/710506291?utm_psn=1799352486617825280

https://zhuanlan.zhihu.com/p/710506291?utm_psn=1799352486617825280

Robotaxi四问四答

文章指出 Robotaxi 要求系统具备高度的自动化、安全性和冗余性,具体包括:

-

感知:需要高精度的传感器(如激光雷达)和高精度地图,以及对 Corner case(如编织袋、临时改道等)的处理能力。

-

预测:涉及对动态障碍物未来轨迹的预测,特别是在多主体交互和长尾障碍物轨迹预测方面。

-

决策:决策模块需要在不确定的环境中工作,处理复杂场景下的博弈和交互,以及提供与人类驾驶员一致的乘坐体验。

-

控制:控制模块需要精确控制,以确保车辆的行驶平稳和精确。

文章还提到,AI 大模型如 Transformer、端到端、多模态和世界模型等前沿技术的应用,有望加速智能驾驶能力的升阶,例如通过大模型提升神经网络的渗透率、模型架构的复杂性和数据的精细化处理。此外,文章举例说明了如何通过模型的训练和实车采集的数据来提升自动驾驶技术的泛化性和拟人性。

Awesome-LM-SSP

这个项目是一个收集与大型语言模型的安全性、隐私性和可靠性相关的资源的列表。它主要关注多模态LM(如视觉-语言模型和扩散模型)的这些方面,并按照不同的主题(如对抗性攻击、版权、数据重建等)对资源进行分类。

https://github.com/ThuCCSLab/Awesome-LM-SSP

https://github.com/ThuCCSLab/Awesome-LM-SSP

Scientific-LLM-Survey

这个仓库收集了关于科学领域大型语言模型的论文,特别是生物学和化学领域。它包含了文本、分子、蛋白质和基因组等科学语言的相关研究,以及它们的多模态组合。

https://github.com/HICAI-ZJU/Scientific-LLM-Survey

-

-

-

— END —

https://zhuanlan.zhihu.com/p/709997736?utm_psn=1799347579873550337

https://zhuanlan.zhihu.com/p/709997736?utm_psn=1799347579873550337 https://zhuanlan.zhihu.com/p/710476102?utm_psn=1799348933778092032

https://zhuanlan.zhihu.com/p/710476102?utm_psn=1799348933778092032 https://zhuanlan.zhihu.com/p/710516489?utm_psn=1799349278482755585

https://zhuanlan.zhihu.com/p/710516489?utm_psn=1799349278482755585 https://zhuanlan.zhihu.com/p/710506291?utm_psn=1799352486617825280

https://zhuanlan.zhihu.com/p/710506291?utm_psn=1799352486617825280 https://github.com/ThuCCSLab/Awesome-LM-SSP

https://github.com/ThuCCSLab/Awesome-LM-SSP