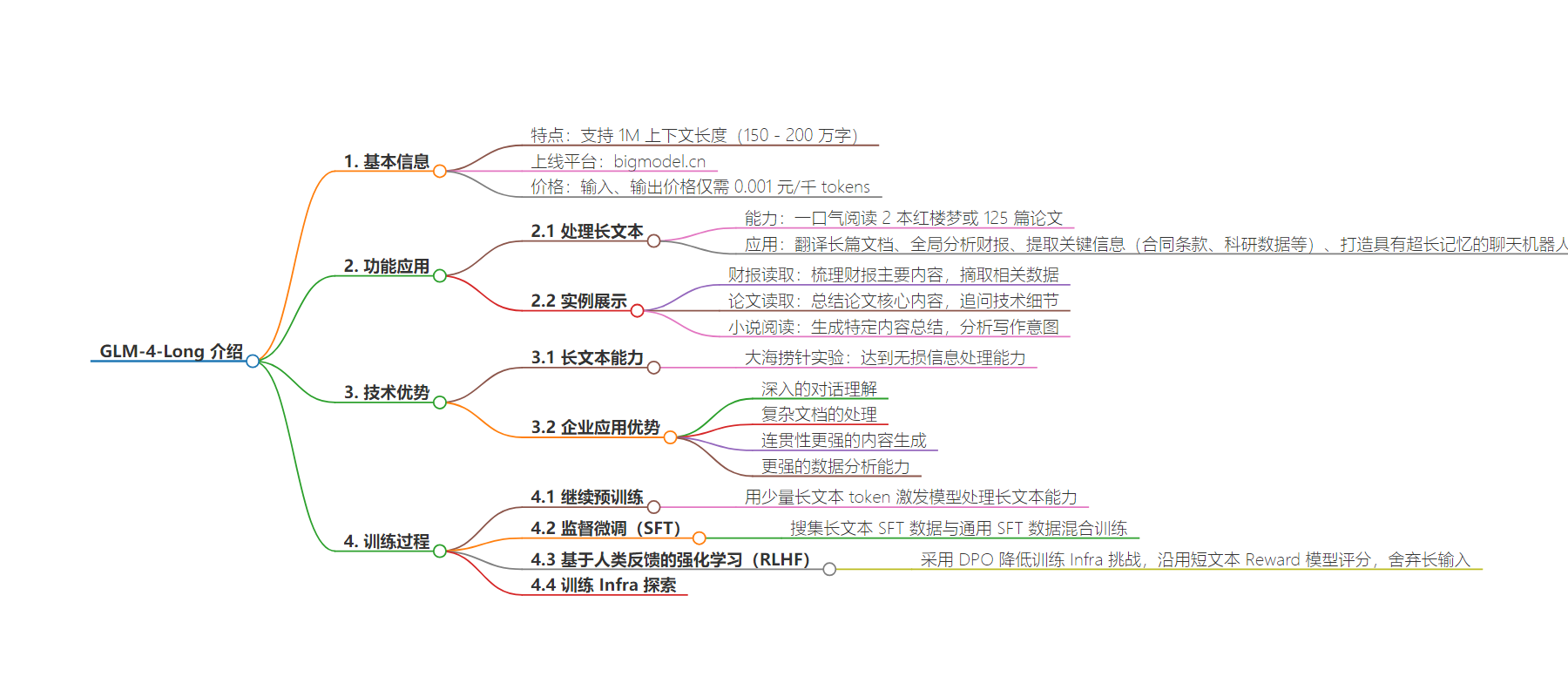

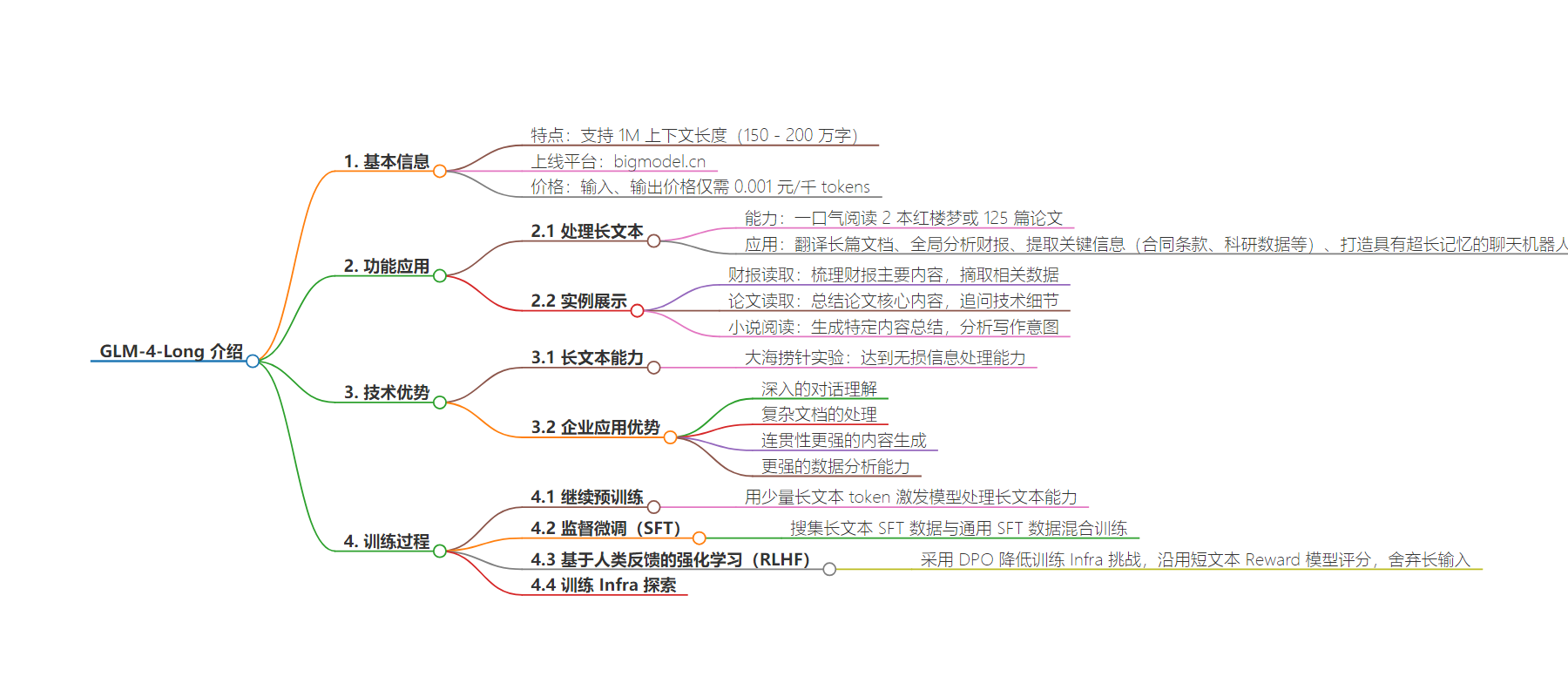

包阅导读总结

1. `GLM-4-Long`、`长文本能力`、`上下文长度`、`技术迭代`、`应用场景`

2. GLM-4-Long 已上线,支持 1M 上下文长度,价格有优势,在处理超长文本上表现出色,如财报读取、论文总结等,其长文本能力历经多个训练阶段逐步实现。

3.

– GLM-4-Long 上线

– 支持 1M 上下文长度(150 – 200 万字)

– 价格具竞争力,输入、输出 0.001 元/千 tokens

– 长文本处理能力

– 能完成多种复杂任务,如翻译长篇文档、分析财报等

– 在大海捞针实验中达到无损信息处理能力

– 实测中处理财报、论文、小说效果好

– 为企业应用带来优势

– 深入对话理解

– 处理复杂文档

– 生成连贯内容

– 增强数据分析

– 长文本能力的实现

– 继续预训练

– 监督微调

– 基于人类反馈的强化学习

– 训练 Infra 探索

思维导图:

文章地址:https://mp.weixin.qq.com/s/fOriXFuj9CghfqCx_wsG3A

文章来源:mp.weixin.qq.com

作者:智谱AI

发布时间:2024/8/13 9:45

语言:中文

总字数:1750字

预计阅读时间:7分钟

评分:93分

标签:语言模型,长文本处理,成本效益,应用场景,技术迭代

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

一个操作系统需要足够大的内存才能完成各种各样的复杂任务。与之类似,一个优秀的 LLM 也需要足够长的上下文长度来完成各种复杂的任务。

GLM-4-Long 现已在开放平台 bigmodel.cn 上线,支持 1M 上下文长度( 150-200 万字 ) ,真正将长文本能力交到企业和开发者手中。

GLM-4-Long 为处理超长文本而设计,能够一口气阅读 2 本红楼梦或 125 篇论文,可以翻译长篇文档、全局分析财报、提取关键信息(合同条款、科研数据等),甚至可以打造一个具有超长记忆的聊天机器人。GLM-4-Long 在价格方面也极具竞争力,输入、输出价格仅需0.001元 /千 tokens。

从最初的仅支持2K上下文的ChatGLM-6B,发展到ChatGLM2-6B(32K)、ChatGLM3-6B(128K),直至现在的GLM-4-Long(1M),GLM技术团队始终追求最领先的上下文能力,不断进行技术迭代。GLM-4-Long集成了我们在长文本领域的大量研究成果。

从现在开始,欢迎大家使用 GLM-4-Long ,解锁更多有价值的应用场景。

https://bigmodel.cn/dev/api#glm-4

https://bigmodel.cn/console/trialcenter

大海捞针实验作为评估长文本能力最著名的实验,核心思想是在长文本中随机插入一个与文本不相关的句子,看模型能否准确地从文本中提取出这个隐藏的句子。从下图可以看出,GLM-4-Long模型在 1M 上下文长度的“大海捞针”实验,达到了无损信息处理的能力。

拥有 1M 上下文长度的 GLM-4-Long,表现究竟怎么样?我们第一时间在大模型开放平台 bigmodel.cn 体验中心进行了实测:

实例1 |财报读取

将一份120页左右的 A 公司企业财报内容交给 GLM-4-Long 处理,他会帮我们梳理财报的主要内容。还可以追问报告中的细节问题,比如2022年是如何分红的,GLM-4-Long会帮助准确摘取相关数据。

实例2 |论文读取

GLM-4-Long可以总结英文论文《ChatGLM: A Family of Large Language Models from GLM-130B to GLM-4 All Tools》的核心内容,将内容分主题输出;对于回答中提到的一些关键技术,还可以进一步追问技术细节。

实例3 |小说阅读

让 GLM-4-Long 阅读《钢铁是怎样炼成的》,可以生成一些特定内容的总结,例如对关键人物进行总结,并分析作者的写作意图。

在需要处理大量数据和复杂多层次信息的场景中,GLM-4-Long为企业应用带来了显著的优势:

1)深入的对话理解:在客户服务场景,长上下文能力使模型更好地理解长篇或多回合交流中的细节及关系,能更好地处理技术支持或复杂咨询。

2)复杂文档的处理:在法律、金融和科研等领域,经常需要分析长篇的文档。模型更好地理解整个文档的结构和内容,提高信息提取和文档总结的质量。

3)连贯性更强的内容生成:在营销和广告领域,可以帮助生成更连贯、更具吸引力、风格和语境一致的内容。例如,根据一系列的营销材料生成一个完整的广告剧本。

4)更强的数据分析能力:在大数据分析中,能够处理长上下文意味着可以更准确地预测趋势。例如,长时间序列的数据可以用来精确预测金融市场波动。

1M 的上下文能力,并非一蹴而就,需要经过多个阶段,来逐步激活和保持模型的长文本能力。

在继续预训练(Continue Pre-Training)、监督微调(SFT)和基于人类反馈的强化学习(RLHF)阶段,我们进行了小心地混合训练,来保持模型在短文本上的通用能力。

具体来说,在继续预训练方面,经过海量 token 的预训练之后,Base Model 具备了卓越的信息捕获和推理能力。为了将这种能力泛化到长文本上,我们需要用少量长文本的 token 对 Base Model 进行继续预训练。这一步对于激发模型处理长文本的能力至关重要。

在 SFT 阶段,我们同样为长文本专门搜集了相应的 SFT 数据,并将这些数据与通用 SFT 数据进行了恰当的混合,以实现训练,确保模型在提升长文本处理能力的同时,保持其通用性。

在 RLHF 阶段,我们采用 DPO 来尽可能降低训练 Infra 所面临的挑战。在此阶段,我们主要需要解决的问题是如何构建长文本 DPO 数据。我们沿用与短文本相同的 Reward 模型来对长文本的答案进行评分。为了防止超出 Reward 模型的上下文限制,我们仅保留了问题和答案,而舍弃了文档等长输入。此外,我们还在训练 Infra 方面进行了大量探索。

既然看到这里了,不妨点击“阅读原文”,或前往大模型开放平台 bigmodel.cn,与我们一起解锁新的可能。