包阅导读总结

1. 关键词:AIGC、Llama3.1、OpenAI、Deepmind、AI搜索

2. 总结:

– 本周 AIGC 领域动态丰富,Meta 发布 Llama3.1 模型,OpenAI 推出 AI 搜索,Deepmind 数学模型获奥数银牌,还有多个相关工具和模型更新。

– 同时包括相关研究、文章及事件,如 Sam 资助的 UBI 调研报告等。

3. 主要内容:

– Meta 发布 Llama3.1 模型

– 包含 8B、70B、405B 型号

– 提供更好推理能力等改进

– 第三方评估结果出炉

– 采用多种合成数据监督微调

– 大量使用基于 Llama 2 生成结果的 DPO 数据

– OpenAI 推出 AI 搜索 SearchGPT

– 结合对话能力和实时网络信息

– 为数据展示形式做了多种创新

– Deepmind 数学模型获国际数学奥林匹克竞赛银牌

– 两个模型 AlphaProof 和 AlphaGeometry 2 表现出色

– 引发对 OpenAI 模型表现的猜测

– 其他更新和成果

– AI 音乐生成工具 Udio 大规模更新

– 多个视频生成和相关模型的更新与发布

– 精选文章

– 包括 UBI 调研报告、AI 训练数据争议等

– 涉及 LLM 应用评估、AI 未来发展等主题

– 研究成果

– 如利用规则改善模型安全行为等

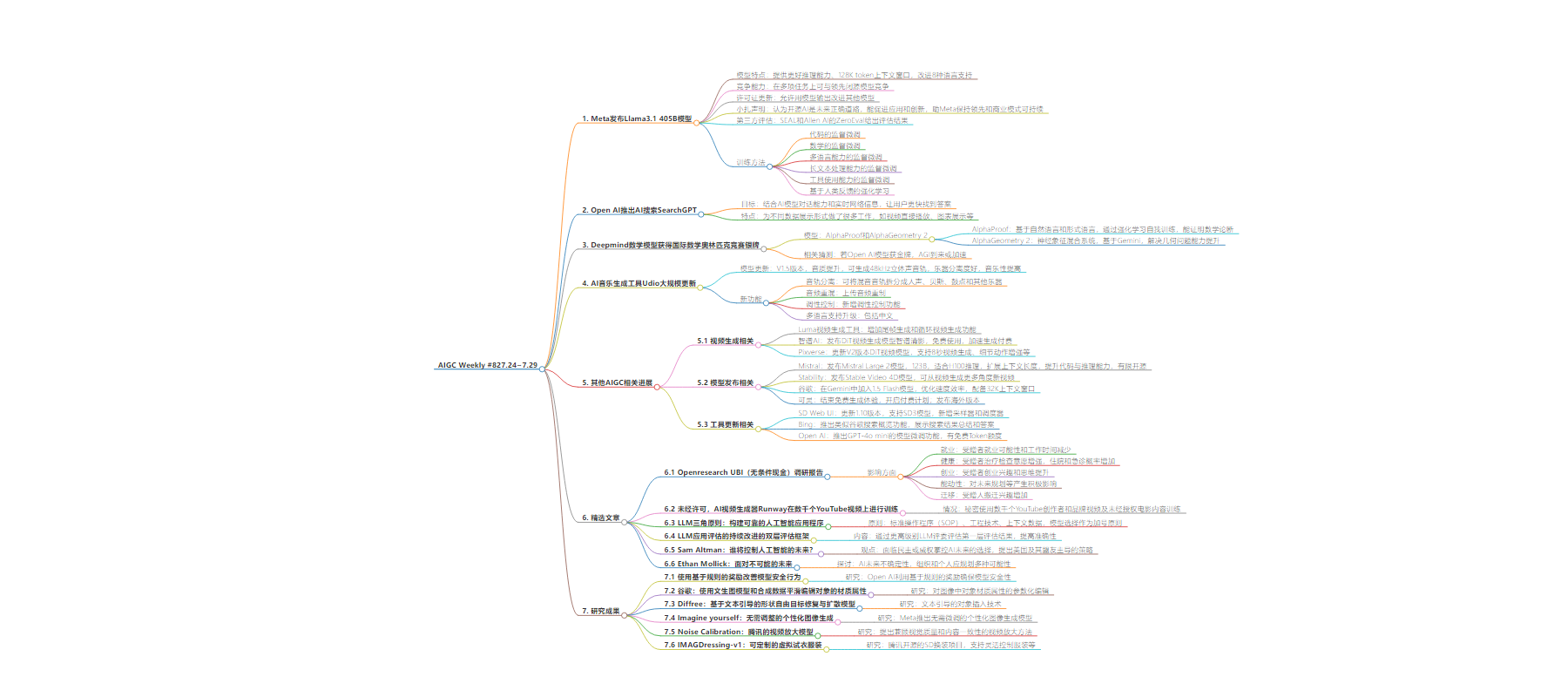

思维导图:

文章地址:https://mp.weixin.qq.com/s/kFocY_YcF2UjTCxORnywLg

文章来源:mp.weixin.qq.com

作者:歸藏的??AI??工具箱

发布时间:2024/7/28 12:16

语言:中文

总字数:7023字

预计阅读时间:29分钟

评分:89分

标签:AI 模型,开源AI,AI 搜索,AI 竞赛,数学推理

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

7.24~7.29,又是刺激的一周。

这周的AI大事件,就都在这里啦。

1. Meta如约发布Llama3.1 405B模型

Meta 上周如约正式发布了 Llama3.1 版本模型,与泄露的内容一致包含8B、70B、405B 三个型号。

提供了更好的推理能力、更大的 128K token 上下文窗口,并改进了对8种语言的支持等其他改进。

-

代码的监督微调 (SFT for Code):405B 模型采用了 3 种合成数据方法来提升自身的代码能力,包括代码执行反馈、编程语言翻译和文档反向翻译。 -

数学的监督微调 (SFT for Math):使用了多种方法包括从数学背景中获取相关的预训练数据,并将其转换为问答格式,以用于监督微调;使用Llama 3来生成一组提示的逐步解决方案;训练结果和逐步奖励模型,以过滤其中间推理步骤错误的训练数据;提示Llama 3通过结合文本推理和相关的Python代码来解决推理问题;为了模拟人类反馈,我们利用不正确的生成进行训练,并进一步通过提示Llama 3来消除这些错误。 -

多语言能力的监督微调 (SFT for Multilinguality):”为了收集更高质量的非英语语言人工标注,我们从预训练过程中分出一个分支,继续在由 90% 多语言标记 (tokens) 组成的数据混合集上进行预训练,以此来培养一个多语言专家模型。” -

长文本处理能力的监督微调 (SFT for Long Context):主要依靠合成数据来解决超长上下文训练的需求。长上下文预训练使用了8000亿(B)个Token,分为6个阶段,并有一个退火阶段。**使用早期版本的 Llama 3 来生成基于关键长文本处理场景的合成数据,包括多轮问答、长文档摘要和代码库推理。” -

工具使用能力的监督微调 (SFT for Tool Use):针对 Brave Search、Wolfram Alpha 和 Python 解释器(一个特殊的新 ipython 角色)进行了训练,以实现单一、嵌套、并行和多轮函数调用的能力。 -

基于人类反馈的强化学习 (RLHF):大量使用了基于 Llama 2 生成结果的直接偏好优化 (DPO) 数据。

2.Open AI推出AI搜索SearchGPT

泄露了三四个月的 Open AI AI 搜索 SearchGPT 终于发布了,他们说这个功能的目标是,通过结合 AI 模型的对话能力和实时网络信息,让用户更快地找到所需答案。

目前从演示以及一些获得资格的用户测试来看,相较于其他 AI 搜索 SearchGPT 为不同的数据展示形式做了非常多的工作。

比如搜索到的 youtube 视频可以在搜索结果直接播放,天气搜索结果会展示带图标的天气列表,数据类的结果会直接匹配适合的图表展示。

虽然 Open AI 的产品能力确实堪忧,但这次又给 AI 搜索展示了下一步的发展方向,就是获取到的信息打撒重新按照用户方便阅读的方式组合,尤其是除了文字之外的更多模态内容,实现图文、视频、数据混排。

3.Deepmind数学模型获得国际数学奥林匹克竞赛银牌

数学和代码LLM 推理能力的两个最重要的领域。

谷歌 Deepmind 上周宣布自己通过两个专门的数学模型解答了这次国际数学奥林匹克竞赛6 道题中的 4 道,获得了银牌。

两个模型分别是 AlphaProof 和 AlphaGeometry 2,AlphaProof 是一个基于自然语言和形式语言的 AI 系统,它通过强化学习自我训练,能够证明数学论断。

AlphaGeometry 2 是一个神经象征混合系统,语言模型基于Gemini,它在解决几何问题方面有了显著提升,包括关于物体运动和角度、比例或距离方程的问题。

另外在推上有个博主拿着谷歌的图询问如果 Open AI 的模型的话可以的几分,Sam 给了一个很有趣的语气词回答,可能在暗示 Open AI 可以获得金牌。

如果 Open AI 真的可以在 IMO 中获得金牌的话,按照 RLHF 的发明者 Paul Christiano 几年前的预测如果 LLM 可以在 2025 年前在 IMO 中获得金牌,AGI 很快就会到来,如果不能的话 AGI 的到来可能需要几十年的时间。

期待 Open AI 在年底的新模型,很多的迹象都说明他们在集中攻克 LLM 的推理能力问题。

4.AI音乐生成工具Udio大规模更新

-

音轨分离:可以将完整混音音轨拆分成四个独立的音轨:人声、贝斯、鼓点和其他乐器。 -

音频重混功能 (上传音频进行重制):**通过音频重混功能,用户可以上传自己的音轨并进行重新创作。这使您能够以全新的创意方式重塑自己的音乐作品。 -

调性控制:新增的调性控制功能让您能够将创作引导至特定的音乐调性。只需在提示中添加一个调性,比如 C 小调、降 A 大调等。 -

多语言支持升级:Udio v1.5 版本扩大了语言支持范围,其中就有中文,他们还专门放了一个中文的展示。

https://x.com/op7418/status/1816321699434139774

https://chatglm.cn/?redirect=/video

https://mistral.ai/news/mistral-large-2407/

https://huggingface.co/stabilityai/sv4d

https://klingai.kuaishou.com/

https://klingai.com/

https://pixverse.ai/

https://x.com/elonmusk/status/1815325410667749760

https://github.com/AUTOMATIC1111/stable-diffusion-webui/releases/tag/v1.10.0

https://x.com/GoogleDeepMind/status/1816804250313457804

https://blogs.bing.com/search/July-2024/generativesearch

https://x.com/OpenAIDevs/status/1815836887631946015

精选文章✦

1. Openresearch UBI(无条件现金)调研报告

-

就业:受赠者比对照组参与者更不可能就业。受赠者平均每周工作时间比对照组参与者少 1.3 小时。 -

健康:受赠者更愿意去治疗和检查,去年住院人数增加了 26%,去年急诊室(ED)就诊的概率增加了 10%。 -

创业:受赠者表现出对创业的兴趣增加,并更有可能具备创业思维。拥有创业点子的可能性增加了3%。 -

能动性:无条件现金对未来预算和规划、追求进一步教育以及对创业的兴趣产生了积极而显著的影响。 -

迁移:受赠人对搬迁更感兴趣,并采取了行动寻找新住房,特别是在转移的最后一年。

2. 未经许可,AI视频生成器Runway在数千个YouTube视频上进行训练

据 404 Media 获得的一份大规模内部训练数据表格显示,市值数十亿美元的公司 Runway 开发的一款备受赞誉的 AI 视频生成工具,在训练过程中秘密使用了数千个来自知名 YouTube 创作者和品牌的视频,以及未经授权的电影内容。泄露这个消息的内部人士还给出了这些 youtube 频道的详细内容。

今年 6 月,当科技新闻网站 Techcrunch 询问 Runway 联合创始人 Anastasis Germanidis 关于 Gen-3 训练数据的来源时,Germanidis 并未透露具体细节。

他对 Techcrunch 表示:”我们有专门的内部研究团队负责监督所有训练过程,我们使用经过精心筛选的内部数据集来训练我们的模型。”

3. LLM三角原则:构建可靠的人工智能应用程序

4. LLM应用评估的持续改进的双层评估框架

作者提出了一个双层评估框架,通过一个更高级别的 LLM 评委(最高 LLM 评委)来评估第一层 LLM 评委的评估结果。这个框架旨在提高评估的准确性和可靠性,减少不正确的评估。

作者通过实验验证了这个框架的有效性,发现最高 LLM 评委能够识别出第一层 LLM 评委错误评估的 70% 的案例。这一发现对于持续改进 LLM 应用的评估过程具有重要意义。

5. Sam Altman:谁将控制人工智能的未来?

Sam Altman认为,我们正面临一个战略性选择:是由美国和盟国推进的民主愿景主导AI的未来,还是由不认同美国价值观的威权国家掌控。

为确保民主愿景胜出,Altman提出了四个关键策略:加强安全措施、发展基础设施、制定AI商业外交政策、建立全球AI治理机制。他强调了行动的紧迫性,指出美国虽然目前在AI领域领先,但这种领先地位并非永久。

文章呼吁美国及其盟友立即采取行动,以确保AI技术的发展能够最大化其益处,同时最小化风险,从而创造一个更加民主的世界。

6. Ethan Mollick:面对不可能的未来

探讨了人工智能(AI)未来发展的不确定性,指出尽管 AI 的未来充满不确定性,但组织和个人应该为多种可能性进行规划。他指出,尽管 AI 的未来发展存在分歧,但许多 AI 实验室的内部人士相信在不久的将来实现人工通用智能(AGI)是可能的。

Mollick 强调,即使不考虑 AI 的进一步进步,现有的 AI 技术已经足够引起颠覆性变化,因此需要现在就开始规划和思考如何使用 AI。他还批评了 AI 系统的不透明性,认为 AI 文档对非技术用户来说不够友好,导致人们对 AI 当前能力的了解不足。

文章中还提到了 AI 能力的锐角形成,即 AI 在某些任务上表现出超过人类的能力,而在其他看似简单的任务上却表现出限制。

1. 使用基于规则的奖励改善模型安全行为

-

命题定义:关于模型响应期望或不期望方面的简单陈述。 -

规则形成:基于命题制定规则,以捕捉安全和适当响应的细微差别。 -

-

硬拒绝(Hard refusals):简短道歉和无法遵从请求的声明。 -

软拒绝(Soft refusals):更具同情心的道歉,承认用户情绪状态,但最终拒绝请求。

-

2. 谷歌:使用文生图模型和合成数据平滑编辑对象的材质属性

谷歌研究,对图像中对象材质属性的参数化编辑。

能够在保持图像逼真性的同时,对对象的颜色、光泽度或透明度等材质属性进行精确控制。

本质上还是滑块Lora的思路,数据集创建的思路可以借鉴,基于SD1.5做的。

3. Diffree:基于文本引导的形状自由目标修复与扩散模型

Diffree,一种文本引导的对象插入技术,它能够在不改变图像背景一致性和空间适当性的前提下,根据文本描述将新对象自然地融入图像。

Diffree 通过在 OABench 数据集上训练,该数据集由 74K 个实世界的图像组成,包括原始图像、经过物体移除后的图像、物体掩码和物体描述。

OABench 数据集是通过高级图像修复技术移除物体后构建的,以实现高质量的文本引导对象添加。Diffree 不仅能够添加多种对象,而且能够通过生成的掩码在单个图像中迭代插入对象,同时保持背景的一致性。

4. Imagine yourself:无需调整的个性化图像生成

-

-

全并行注意力架构,包含三个文本编码器和一个可训练的视觉编码器

5. Noise Calibration:腾讯的视频放大模型

提出了一种新的方法,同时兼顾视觉质量和内容一致性。我们通过设计一种新的损失函数 (loss function) 来确保内容一致性,该函数能够保持输入的结构特征。同时,我们利用预训练扩散模型的去噪过程来提升视觉质量。

为了解决这个优化问题,我们开发了一种即插即用 (plug-and-play) 的噪声优化策略,称为噪声校准 (Noise Calibration)。通过对初始随机噪声进行几轮迭代优化,我们可以在很大程度上保留原始视频的内容,同时显著改善增强效果。

6. IMAGDressing-v1:可定制的虚拟试衣服装

腾讯开源的 SD 换装项目,支持对服装的灵活控制、可选的面部、姿势和场景。

模型包含一个服装 UNet,用于捕获来自 CLIP 的语义特征和来自 VAE 的纹理特征。还设计了一个混合注意力模块,包括一个冻结的自注意力 (self-attention) 和一个可训练的交叉注意力 (cross-attention),将服装 UNet 的特征整合到冻结的去噪 UNet 中,确保用户可以通过文本控制不同的场景。

IMAGDressing-v1 可以与其他扩展插件结合使用,如 ControlNet 和 IP-Adapter,以增强生成图像的多样性和可控性。