包阅导读总结

1. 关键词:苹果、DCLM-7B、开源模型、性能超越、数据集

2. 总结:

OpenAI 上线小模型 GPT-4o-mini 后,苹果也加入小模型赛道。苹果发布的 DCLM-7B 开源模型性能超越 Mistral-7B,逼近其他领先开源模型。该模型不仅开源权重,还开源训练代码和预训练数据集,研究旨在通过新基准提高模型性能。

3. 主要内容:

– 小模型赛道开卷

– OpenAI 上线小模型 GPT-4o-mini

– 苹果加入,发布 DCLM-7B 开源模型

– DCLM-7B 模型特点

– 性能超越 Mistral-7B,逼近 Llama 3 和 Gemma

– 开源模型权重、训练代码和预训练数据集

– 被描述为“真正开源的最佳模型”

– 研究背景与方法

– 大型语言模型评估缺乏受控比较

– 提出新基准 DCLM,旨在提高模型性能

– 使用标准化框架找出最佳数据整理策略

– DCLM-7B 模型细节

– 基于 OpenLM 框架预训练,MMLU 基准 5-shot 准确率达 64%

– 在 53 个自然语言理解任务上表现媲美其他模型,计算量仅为 Llama 3 8B 的 1/6

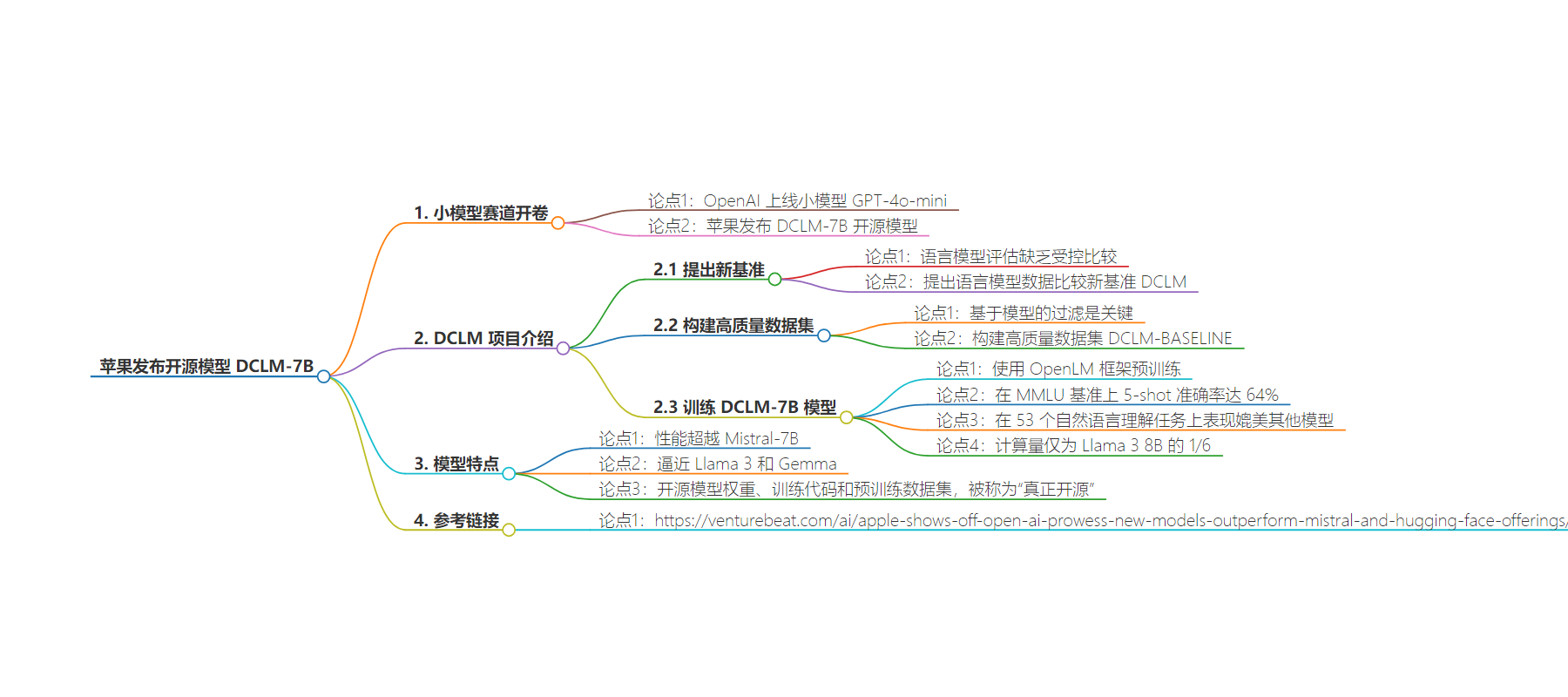

思维导图:

文章地址:https://www.jiqizhixin.com/articles/2024-07-22-3

文章来源:jiqizhixin.com

作者:机器之心

发布时间:2024/7/22 2:49

语言:中文

总字数:974字

预计阅读时间:4分钟

评分:83分

标签:自然语言处理,预训练模型,小模型,开源,语言模型

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

本周,OpenAI 上线小模型 GPT-4o-mini,小模型赛道正式开卷。近期加入这一赛道的还有苹果。

最近,苹果公司作为 DataComp-LM(DCLM)项目的研究机构之一,在 Hugging Face 上发布了 DCLM-7B 开源模型。该模型性能已经超越了 Mistral-7B,并且正在逼近其他领先的开源模型,包括 Llama 3 和 Gemma。

论文作者之一、苹果机器学习团队 Vaishaal Shankar 将 DCLM 模型描述为「真正开源的最佳模型」,因为 DCLM 不仅开源了模型权重,还开源了训练代码和预训练数据集。

研究介绍

大型语言模型(LLM)目前面临的一个评估挑战是缺乏受控比较。LLM 研究通常会比较采用不同架构、计算或超参数的模型,因此难以理清影响语言模型质量的因素。

基于此,研究团队提出了语言模型数据比较新基准 ——DCLM,这是语言模型训练数据整编(curation)的第一个基准,旨在让 LLM 通过设计高质量数据集来提高模型性能,特别是在多模态领域。

研究团队发现基于模型的过滤,即由机器学习 (ML) 模型从较大的数据集中自动过滤和选择高质量数据,可能是构建高质量训练集的关键。

DCLM 整体思路很简单:使用一个标准化的框架来进行实验,包括固定的模型架构、训练代码、超参数和评估,最终找出哪种数据整理策略最适合训练出高性能的模型。

使用 DCLM,研究团队构建了一个高质量数据集 DCLM-BASELINE,并用该数据集从头开始训练了一个 7B 参数模型 —— DCLM-7B。

DCLM-7B 模型的细节。

DCLM-7B 使用基于 OpenLM 框架的预训练方案,在 MMLU 基准上 5-shot 准确率达到 64%,可与 Mistral-7B-v0.3(63%)和 Llama 3 8B(66%)相媲美,并且在 53 个自然语言理解任务上的平均表现也可与 Mistral-7B-v0.3、Llama 3 8B 相媲美,而所需计算量仅为 Llama 3 8B 的 1/6。

以下是 DCLM-7B 在各种任务(部分)上的评估结果:

DCLM-7B 与其他同等大小模型比较结果如下表所示:

值得注意的是,大部分其他模型虽然开放权重但封闭数据。这就是 Vaishaal Shankar 将 DCLM 模型描述为「真正开源」的原因。

参考链接:https://venturebeat.com/ai/apple-shows-off-open-ai-prowess-new-models-outperform-mistral-and-hugging-face-offerings/