包阅导读总结

1. 长文本、成本下降、应用场景、多模态、推理能力

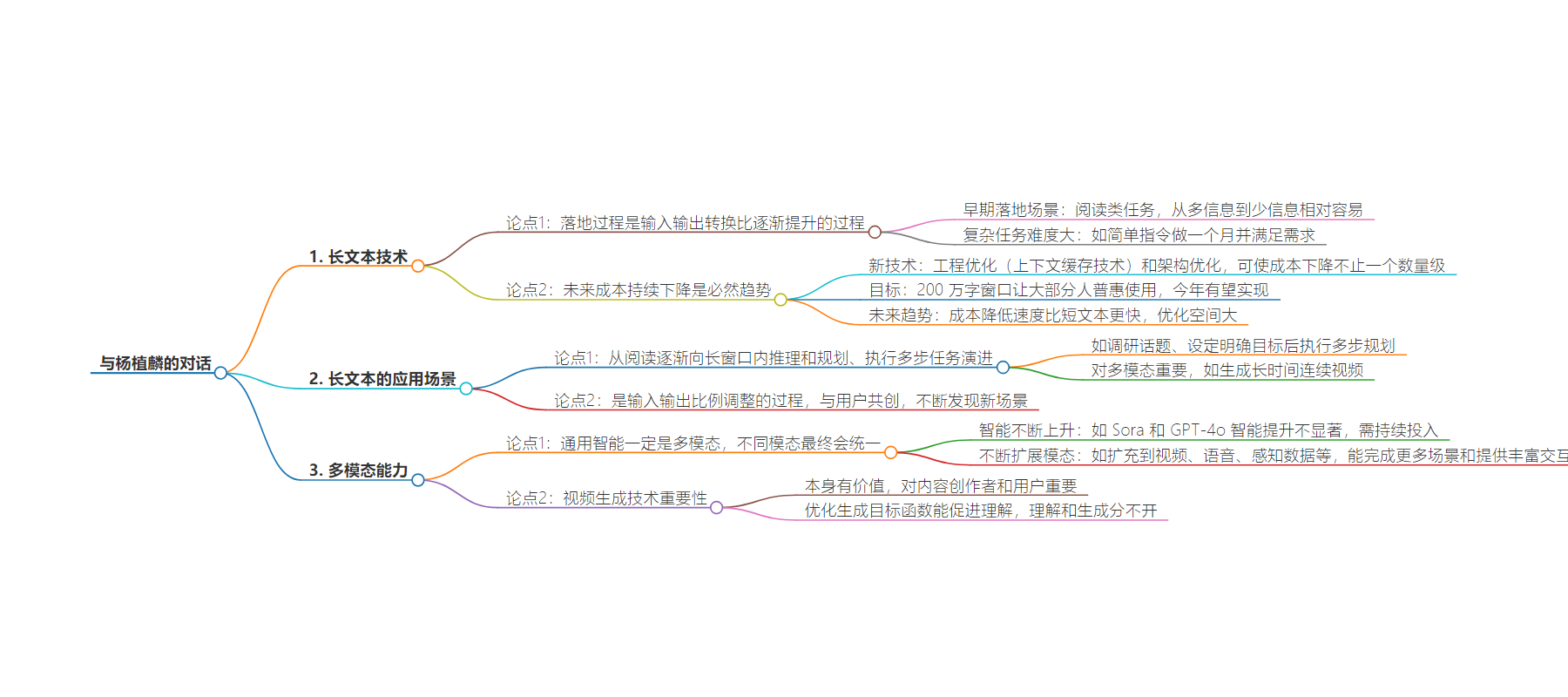

2. 本文主要探讨了长文本技术,包括其落地过程中输入输出转换比的问题,成本下降的趋势及新技术优化,未来应用场景的演进方向,以及多模态如视频生成能力在通用智能中的重要性。

3.

– 长文本技术

– 落地过程是输入输出比例逐渐提升

– 早期用于阅读类任务,因信息从多到少相对容易

– 长文本成本

– 持续下降是必然趋势

– 工程和架构优化能大幅降低成本,200 万字窗口普惠使用有望今年实现

– 长文本应用场景

– 从阅读发展到在长窗口内推理、规划和执行多步任务

– 多模态中生成长时间连续视频也需要

– 多模态能力

– 通用智能应是多模态,不同模态最终会统一

– 智能提升和扩展模态是两个重要维度

– 以视频生成为例,生成和理解分不开,做好生成能促进理解

思维导图:

文章地址:https://mp.weixin.qq.com/s/CWWfJbfxR-6VkicMzVT30Q

文章来源:mp.weixin.qq.com

作者:Founder??Park

发布时间:2024/7/30 6:37

语言:中文

总字数:10192字

预计阅读时间:41分钟

评分:78分

标签:AI创业,AIGC,AGI,知识工作生产力,AI应用

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

Q:就是它最终其实是跟用户在做数据的输入、指令的输入和最终交付服务的转换比的计算,转换比越高,带来的价值就越高。

杨植麟:对,这个确实很有意思。比如,即使只看长文本这个技术,它的落地过程也是一个比例逐渐提升的过程。

因为在最早期的时候,就是用长上下文去做一些阅读类任务。阅读类任务肯定是最早落地的,因为它是一个从很多的信息变成很少的信息的过程,相对会容易一些。

比如让 AI 读 10 篇文章,然后形成总结。这个难度肯定小于我只给 AI 一个很简单的指令,但是要一口气做一个月,并且最好还要满足用户的需求。

这确实是个比例的问题,就是输入和输出的比例,它可能是更本质的东西。

Q:理解了,你觉得未来长文本的成本会快速下降吗?因为现在真的把 200 万 token 扔进去跑一圈,成本还是蛮高的,而且这又跟长文本应用在哪些场景、能否高价值地解决问题有关,这两个问题其实是绑定在一起的,你怎么看?

杨植麟:我觉得成本的持续下降肯定是个必然趋势。最近我们有一些新技术,一方面是一些工程上的极致优化,比如 context caching(上下文缓存)技术。另一方面,我们在架构上也做了很多优化。这能够让成本在现在的基础上,下降甚至不止一个数量级。

所以如果是 200 万字的窗口、并且能够让大部分人普惠地用起来,我觉得这是一个大概率能在今年实现的目标。

Q:今年就可以做到吗?

杨植麟:对,我觉得这是我们的目标。在接下来很长一段时间内,成本会持续降低、而且速度会比 short context(短文本)更快。

今天还有很多东西是没有被挖掘的。比如说,如果考虑一个人处理一个很长的记忆、或长周期的任务,他其实并不需要记住所有东西,对吧?它是一个动态计算的过程,你可以选择哪些东西要记下来、哪些要扔掉,这里面有非常大的优化空间。

而今天 AI 的效率远远高于人类,所以它的优化空间很大,整体成本降低的速度会比短文本更快。

Q:那我们站在这个角度去想象一下,这种变量放在应用场景上,大家会怎么用这样的一个能力呢?比如说之前我们把一本书扔进去让它做总结,这是非常直接的,那按照你的推理,接下来还会有哪些用户场景会更可用?

杨植麟:这跟我们刚才说的话题有点相关。它是一个输入输出比例调整的过程,一开始可能就是阅读,阅读是目前最刚需的场景之一。之后它可能会变成,模型能够在很长的窗口内做推理和规划、并且执行多步任务的能力。

比如说你今天想调研某个话题,或者说甚至就是给了 AI 一个明确的目标,那它就可以去执行多步规划、然后调用不同的工具、甚至有中间的思考分析过程。我觉得它会逐渐往这个方向演进。

当然,对于多模态来说也很重要。比如你今天想生成一个长时间的连续视频,背后可能也需要很好的上下文技术。

Q:所以我现在理解你为什么说,其实长文本在接下来可能更接近长推理。它本质上不是传统意义上的「我给它多少文本,它处理多少」,而是「它有多长的推理能力、能在多少信息下进行进一步的推理和创造」,这变得更重要。

杨植麟:对,因为如果只有长的文本,但是脑子不够用(推理能力不够),那其实没有太大价值。它肯定是要两个同时都做好。

Q:它会从一个产品的 feature 转化为一种产品的后台能力,然后这种能力会产生更强大的 feature,这可能是它的行进路线对吧?

杨植麟:对,而且这其实也是跟用户一起探索的过程。比如说今天我们上下文中的很多场景,其实是 Day One 的时候都没预想到的。

即使是阅读这个事情,我们之前也没想到它可以被用来快速入门一个新领域,甚至在不同的行业里、它可能都有不同的用法。比如有的用户可能会用这个功能去做一些分析,但这些分析如果你不给大家提供上下文,那分析效果可能没那么好。当你给它提供了之后,它的分析可能会更有结构化,更像麦肯锡分析法那样。

所以我觉得这是一个跟用户共创的过程,你会不断发现新的应用场景。

Q:对,这就是智能带来的增益价值。

Q:最近业界大家看到的技术变化,比如说我们今天看到的 Sora 和 GPT-4o,你怎么看待 Sora 这种视频生成的能力?会是未来 Kimi 特别看重的能力吗?

杨植麟:这个肯定很重要。因为对于通用智能来说,它肯定是多模态的,你很难想象一个单模态的通用智能。所以我觉得最终不同模态之间,一定会是统一的模型。当然,现在我们可以看到技术的发展,可能有两个不同的维度。

第一个维度是智能的不断上升。比如说我们看到 Sora 和 GPT-4o,它们的智能提升虽然有一些,但没有非常显著。如果让它们去做智商测试或者一些更复杂的任务,它们可能还是做不了。所以这个方向肯定需要持续投入,我认为这是最重要的方向。

另外一个维度是不断扩展模态。比如现在有视频模态、语音模态,未来可能会扩充到感知数据、动作数据、甚至机器人的模态。这背后的价值在于,(模型)能够完成更多的场景、提供更丰富的交互方式,能够帮助产品 cross the chasm(跨越鸿沟),让技术真正变得非常易用、被越来越多的人使用。

这是两个不同的维度,但最终它们会统一起来。

Q:像 GPT-4o 这样的多模态能力,一定是所有做模型的公司都在研究的能力。但像 Sora 这样的视频生成技术,它是在智能成长这条线上吗?还是更多的是在给用户交付服务?这条线到底是因为什么而重要?

杨植麟:其实这个问题在纯语言模型的时代就已经被讨论过了。

我记得在 2019 到 2020 年期间,有一个重要的讨论话题就是,语言模型到底应该侧重理解还是生成?一开始有像 BERT 这样的模型,后来有 GPT 系列,可能 GPT 的生成能力更好,但 BERT 在相同算力下的效率永远更高、也就是说单位算力下 Benchmark 的提升更大。

那段时间所有人都关注 BERT,觉得能做理解就行了,工业界大部分的价值都在于理解。但这里面可能忽略了一个很重要的问题,那就是如果你想做非常好的理解,实际上你需要做非常好的生成,这两个问题最终是一个问题。

对于视频来说也是一样。我们今天想做很好的视频生成,一方面是因为视频生成本身有很高的价值,尤其是对于内容创作者和用户来说。但我觉得更重要的还不是这个,更重要的是说如果能把生成的目标函数优化得非常好,它最终一定能把理解做得更好。

我觉得文本已经是个很大的 lesson,过去几年,一开始大家有很多争论,但后来基本上就是共识,就是理解和生成是分不开的。你很难单独训练一个理解的模型,最后这两个可能就是一个模型。