包阅导读总结

1.

关键词:谷歌、Gemma 2 2B、小模型、参数规模、性能优越

2.

总结:谷歌不断推出端侧小模型,Gemma 2 2B 是最新的 20 亿参数版本,在同等参数规模中表现最强。它性能卓越、部署灵活经济、开源易用,可在多种设备运行,颠覆了参数越大性能越好的观点。此外,谷歌还发布了 ShieldGemma 和 Gemma Scope 等专业模型,以构建负责任的 AI 未来。

3.

主要内容:

– 背景

– 语言模型发展迅速,但规模大带来计算资源需求和应用限制。

– Gemma 系列模型

– 2 月发布首批 Gemma 系列,与旗舰产品 Gemini 对比。

– 6 月开源 Gemma 2,27B 版本在排行榜表现出色。

– 今日凌晨推出 Gemma 2 2B,参数 20 亿。

– Gemma 2 2B 特点

– 通过知识蒸馏技术,效果超乎寻常。

– 性能卓越,超越 GPT-3.5 系列模型。

– 灵活经济部署,优化适配多种硬件。

– 开源易用,适用研究和商业应用。

– 新模型发布

– ShieldGemma 用于捕捉有害回应和过滤恶意提示。

– Gemma Scope 提高 Gemma 2 透明度,帮助理解内部机制。

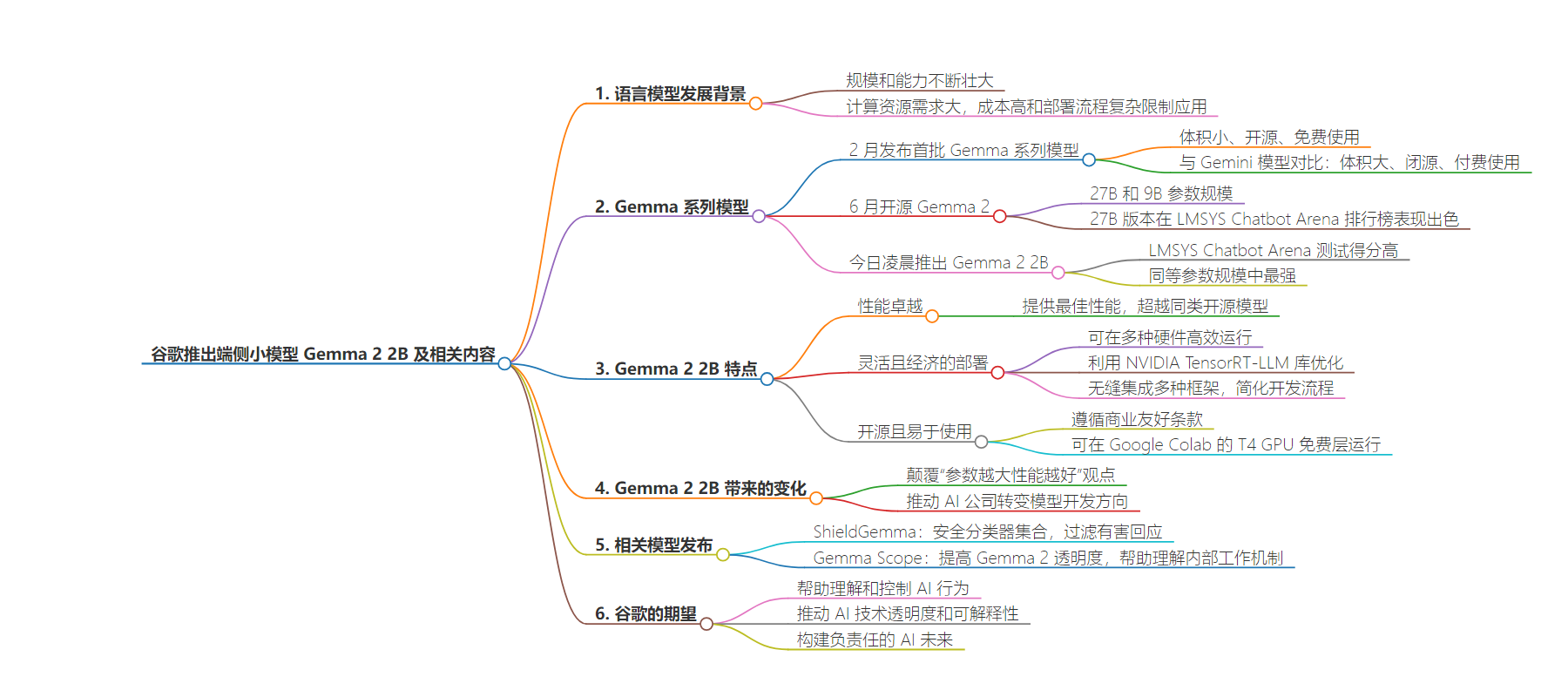

思维导图:

文章地址:https://mp.weixin.qq.com/s/ppMQgZhUNoEFIHgcj0cx3A

文章来源:mp.weixin.qq.com

作者:CSDN

发布时间:2024/8/1 10:20

语言:中文

总字数:2250字

预计阅读时间:9分钟

评分:87分

标签:AI模型,谷歌,知识蒸馏,端侧部署,性能优化

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

在 AI 技术的快速发展下,语言模型的规模和能力也在不断壮大。从最初的几百万参数发展到如今动辄数十亿甚至数百亿参数的模型,每一次技术革新都伴随着巨大的计算资源需求——然而,高昂的成本和复杂的部署流程也因此成为了限制模型广泛应用的主要障碍。

在这样的背景下,今年 2 月谷歌发布了首批 Gemma 系列模型。不同于其旗舰产品 Gemini 模型,Gemma 的体积更小、完全开源、可免费使用,而 Gemini 系列模型体积更大且闭源,此外开发者需付费才能使用。

到了 6 月份,谷歌又开源了 Gemma 2,拥有 27B(270 亿)和 9B(90亿)两种参数规模,其中 27B 版本很快就在 LMSYS Chatbot Arena 排行榜上占据高位,在实际对话中甚至超越了参数规模是其两倍多的热门模型。

事实证明,在搞「小」模型这件事上,谷歌贯彻的路线似乎是“既然卷不死,就往死里卷”。

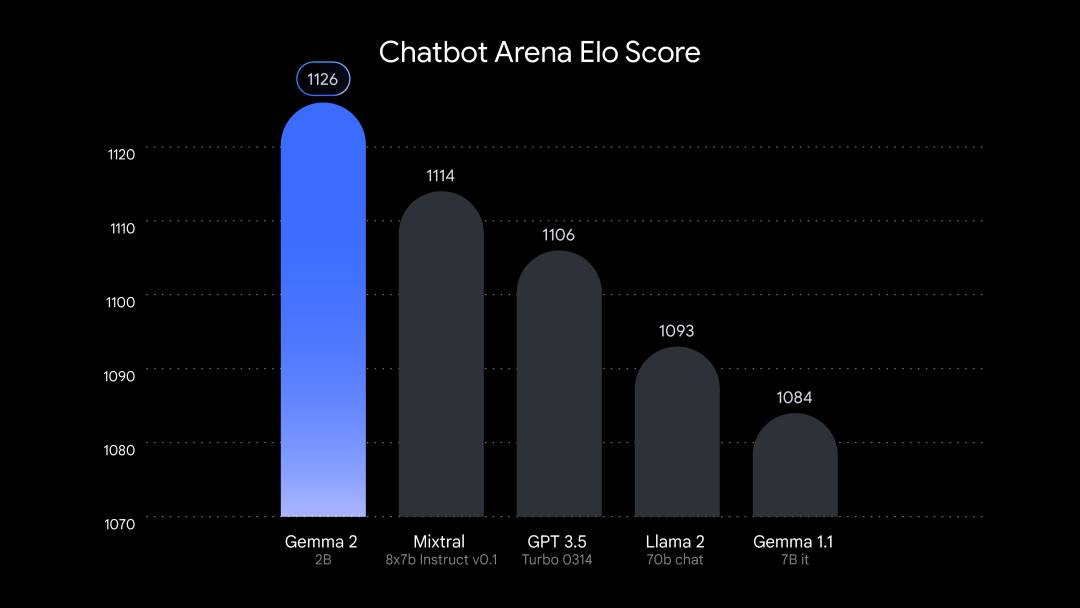

今日凌晨,谷歌再次最新推出了 Gemma 2 的 2B(20 亿)参数版本。据了解,这个 2B 模型在 LMSYS Chatbot Arena 测试中得分 1130,比 GPT-3.5-Turbo-0613的 1117 分和 Mixtral-8x7b 的1114 分都要高——Gemma 2 2B 几乎可谓是:同等参数规模中最强模型。

那么接下来,我们就来看看 Gemma 2 2B 究竟有何特点以及它可能会带来怎样的变化。

规模变小了,但 Gemma 2 2B 更强了

从谷歌的官方博客介绍来看,Gemma 2 2B 通过知识蒸馏技术(一种能将大规模深度学习模型的知识迁移到小规模模型中的方法),从更大规模的模型中学习,实现了超乎寻常的效果。

在 Chatbot Arena 上,Gemma 2 2B 得分超越了所有 GPT-3.5 系列模型,展现了其卓越的对话能力:

整体而言,作为一款轻量级 LLM,Gemma 2 2B 是谷歌专为在笔记本电脑和智能手机等本地设备上运行而设计的,故而其具备以下三个特点:

-

性能卓越:以其规模而言,它提供了同等模型中的最佳性能,也超越了同类中的其他开源模型。

-

灵活且经济的部署:Gemma 2 2B 可以在广泛的硬件上高效运行,从边缘设备、笔记本电脑,到依托 Vertex AI 和 Google Kubernetes Engine(GKE)的强大云部署环境。为了进一步提升速度,该模型利用 NVIDIA TensorRT-LLM 库进行了优化,并作为 NVIDIA NIM 提供。这种优化面向各种部署场景,包括数据中心、云端、本地工作站、PC 及边缘设备——利用 NVIDIA RTX、NVIDIA GeForce RTX GPU 或 NVIDIA Jetson 模块进行边缘 AI 处理。此外,Gemma 2 2B 无缝集成 Keras、JAX、Hugging Face、NVIDIA NeMo、Ollama、Gemma.cpp,并即将支持 MediaPipe,大幅简化了开发流程。

-

开源且易于使用:Gemma 2 2B 遵循商业友好的 Gemma 条款,适用于研究和商业应用。它体积小巧,足以在 Google Colab 的 T4 GPU 免费层上运行,让实验和开发变得更加容易。

除了 Chatbot Arena 得分,谷歌透露 Gemma 2 2B 在“大规模多任务语言理解”(Massive Multitask Language Understanding)基准测试中获得了 56.1 分,在“基本 Python 编程”(Mostly Basic Python Programming)测试中也获得了 36.6 分,相比早期 Gemma 模型得分均有所提高。

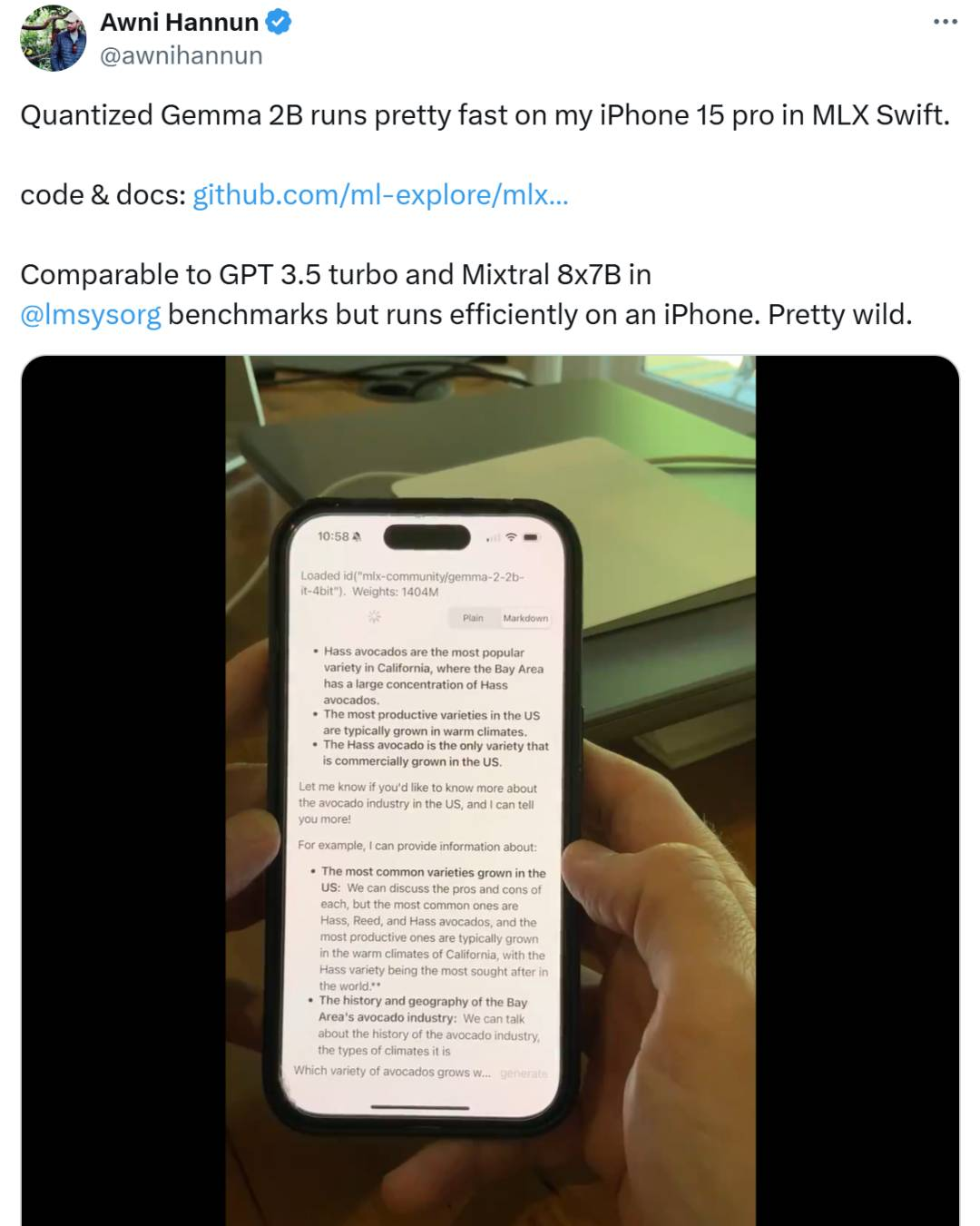

由于参数量较小,性能又很优越,相信 Gemma 2 2B 在本地运行和部署有着巨大的应用潜力——这不,苹果机器学习研究(MLR)团队研究成员 Awni Hannun 就试着在 iPhone 15 pro 上用 Gemma 2 2B 跑了一下,他的评价是:“运行得非常快。”

很显然,这些结果在一定程度上颠覆了过去 AI 领域“参数越大性能越好”的传统观点,反而证明:通过采用更复杂的训练技术、使用卓越的架构和更高质量的训练数据,就可能弥补参数数量较少的不足。

谷歌也提到,希望他们在 Gemma 2 2B 上所做的工作,能有助于推动 AI 公司开始转变,让他们不再追求建立越来越大的模型,而是专注于完善现有模型,使其表现更好,从而开发出更易于使用、对算力要求更低的 AI 模型。

据悉,即日起,开发者不仅可以从 Kaggle、Hugging Face 以及 Vertex AI Model Garden 下载 Gemma 2 的模型权重,还可以在 Google AI Studio 中体验其强大功能。

构建一个负责任的AI 未来

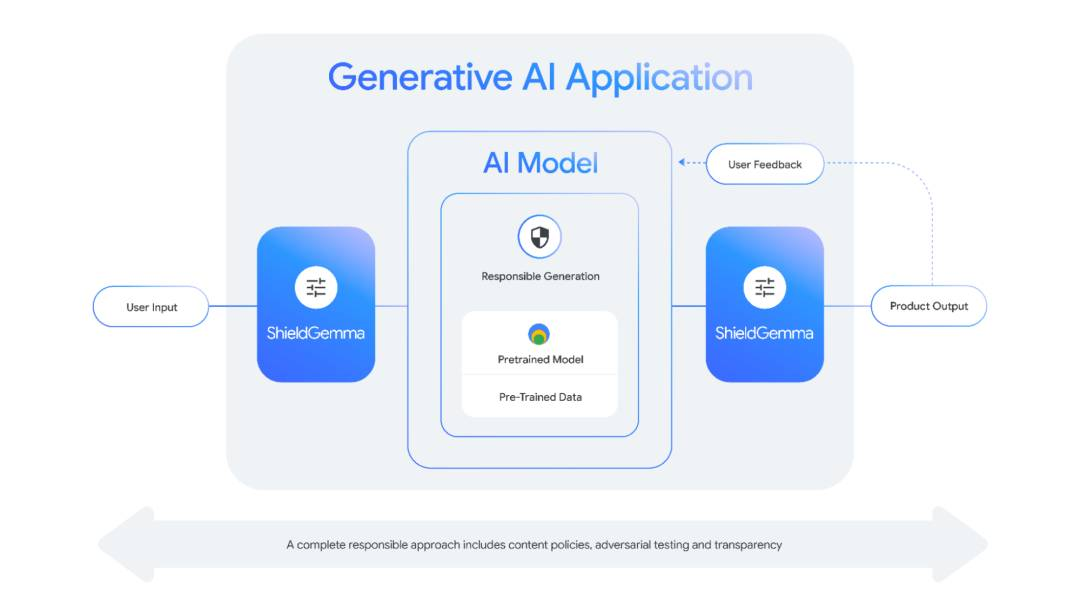

除了 Gemma 2 2B,本次谷歌还发布了两种专业模型 ShieldGemma 和 Gemma Scope:

实际上,ShieldGemma 是一组安全分类器的集合,旨在捕捉诸如仇恨言论、骚扰和性暗示内容等有害回应。ShieldGemma 建立在原始的 Gemma 2 模型之上,开发者可以用它来过滤那些诱导模型以不良方式回应的恶意提示。此外,它还可以用于过滤大型语言模型(LLMs)的实际回应。

至于 Gemma Scope 的推出,是为了给 Gemma 2 带来更大的透明度。通过聚焦 Gemma 2 模型的特定部分,Gemma Scope 可帮助开发者理解其内部工作机制:

“Gemma Scope由专门的神经网络组成,有助于我们解析 Gemma 2 处理的密集、复杂信息,并将其扩展为更易于分析和理解的形式。通过研究这些扩展视图,研究人员可以深入了解 Gemma 2 如何识别模式、处理信息并最终进行预测。”

通过发布如 Gemma 2 2B、ShieldGemma 和 Gemma Scope 这样的模型,谷歌希望能用不同的方式帮助开发者、研究人员和最终用户更好地理解和控制 AI 的行为,提供必要的工具和资源来推动 AI 技术的透明度和可解释性,构建一个 AI 能够惠及每一个人的未来。

参考链接:https://developers.googleblog.com/en/smaller-safer-more-transparent-advancing-responsible-ai-with-gemma/

▶太贵了!Oracle让Java SE按“人头收费”的550天后,最新报告:86%的人想弃用

▶QQ 客户端性能稳定性防劣化系统 Hodor 技术方案

▶年薪平均减少1万美元,76%的人在用AI开发!调查了6.5万名开发者,Stack Overflow年度报告出炉!

能学习到新知识、产生共鸣,解答久困于心的困惑,这是《新程序员》的核心价值。欢迎扫描下方二维码订阅纸书和电子书。