包阅导读总结

1. 关键词:大模型、呼叫中心、TTS、Voice Agent、落地难点

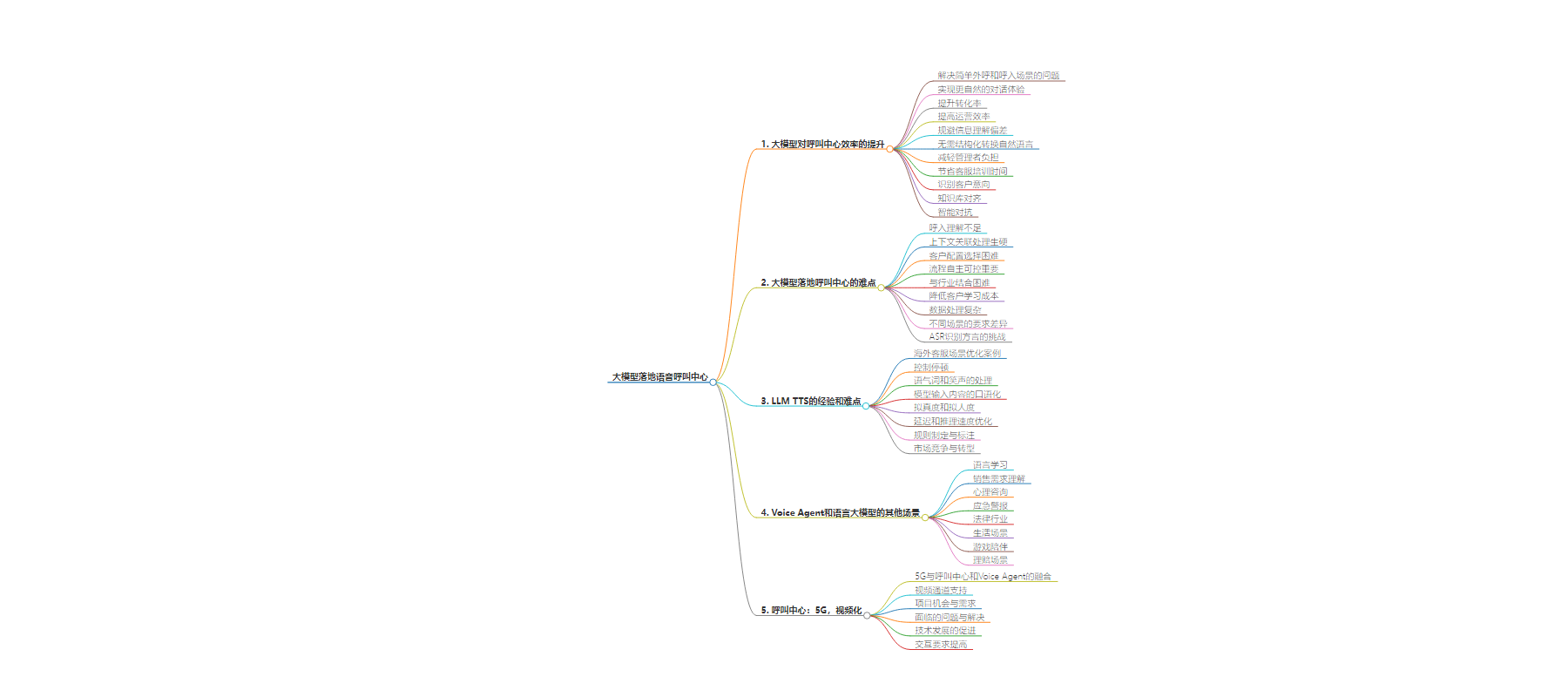

2. 总结:本文探讨了大模型在呼叫中心落地的相关问题,包括其提升效率的表现、落地难点、TTS 经验,还介绍了 Voice Agent 和语言大模型的其他场景,以及 5G 与呼叫中心和 Voice Agent 的融合情况。

3. 主要内容:

– 大模型在呼叫中心的应用

– 提升效率:解决常见问题,优化运营效率等。

– 落地难点:呼入理解不佳、上下文关联处理生硬、客户配置复杂等。

– LLM TTS 的经验和难点

– 海外落地场景。

– 停顿、语气词和笑声等情感表达的处理。

– 拟真度和拟人度的优化。

– Voice Agent 和语言大模型的其他场景

– 语言学习、销售需求理解、心理咨询等。

– 生活中的旅行规划、游戏陪伴等。

– 呼叫中心:5G,视频化

– 5G 对音频和视频的支持。

– 项目实施中的问题与解决。

– 运营商基础设施的发展。

思维导图:

文章地址:https://mp.weixin.qq.com/s/s0BXaZdNS7fLnPBsPzDBUw

文章来源:mp.weixin.qq.com

作者:AI芋圆子

发布时间:2024/7/25 13:23

语言:中文

总字数:7752字

预计阅读时间:32分钟

评分:91分

标签:呼叫中心,大模型,TTS技术,Voice Agent,语音识别

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

大模型对呼叫中心效率的提升

-

首先很多的外呼场景其实不需要那么复杂的对话。对于一些呼进来的场景中,用传统的机器人也能解决掉很多的 QA,不需要 LLM 做到非常强。 -

它只需要一层 ASR 和一层 GTS,把这两个优化好,它就非常像人了。这样你能解决掉可能 80% 的问题。 -

如果遇到太难的问题,AI 没办法回答。可以用 LLM 检测一下,然后发给普通的客服。 -

所以呼叫中心是一个相对来说比较简单、比较好落地的场景,而其他的场景都需要 LLM 做得非常强,即理解和智能能力要变得非常强。

-

原来的意向型 IVA 在效率上对客户已经有了很大提升,国内很多银行都在用,确实节省了成本。但是当对话更加复杂,受限度是意向型 IVA 长期解决不了的问题。 -

所以客户对 LLM 的期望是能有更自然的对话体验,能够结合通话数据,对历史数据分析后,能有营销转化的提高,并能用在营销任务上。 -

还有大模型的自学习能力,希望能够在受限的交互上有提升,提升了客户满意度与忠诚度,或者实现获新客或者老客户的增收等。 -

另外,相比过去主要衡量的接通率,转化率提升是业务人员更关注的,因为最后的买单主要是业务说了算。运营效率上,以前交互需要大量的标注,需要去看哪些问题不行,然后需要人工过度的参与。所以也希望运营效率上有一些提高。

-

电话后总结可以有效规避个人主观性带来的信息理解偏差:在一通会话结束之后,坐席都会去做小结。企业可能依赖销售顾问或者服务坐席,通过小结来去总结会话中发现了什么。但是当坐席去做总结的时候,一定带来了他个人的主观性,那主观性有可能会给管理者带来洞察上的偏差。LLM 可以做到更加客观。 -

自然语言以后不需要做结构化转换:比如想知道呼叫中心的坐席表现如何?谁表现最好?谁表现差?以往需要把脑子里想的这个需求经历一个 SaaS 的结构化转换,就是我需要知道去点击哪个配置,看哪个报表,看哪个监控;包括在垂直领域 workflow 也是一样的。当他有了这个理解的价值之后,不需要再让客户学习这些配置,去看大量的报表去做这些管理分析。 -

减轻管理者负担:作为管理者太累了,并且人的能力模型和视野也有局限性,比如看 10 个指标管理者可能就已经超载了,但是 LLM 不会累,可以弥补管理者的视野。

-

节省客服培训时间:电销一般会频繁离职,新入职员工就要做培训,传统模式中电销都要先经过学习培训期,然后考试通过后才能上岗。 -

识别客户意向:比如卖车,电销给客户打电话,邀约到店。用户提到,「我知道哪个品牌、哪个直播的渠道是价格是比你这个店低的,但我很想去你的店,因为在我当地,我来修车售后很方便。」这个时候客户其实表现出了是很高的意向,并且他只是关心价格问题,但是你会发现有些销售顾问不一定理解,他只会是说,我去跟领导沟通一下。辅助客服这时候就可以作为案例,提醒碰到类似情况如何处理。 -

知识库对齐:在电销的时候经常会遇到竞品分析问题。往往电销无法直接针对性回答,此时需要拉群,产生新的组织内部沟通,也会影响销售效率。辅助电销+RAG 可以及时同步电销信息。 -

智能对抗:同时还可以采用 LLM 作为智能对抗工具,在和员工对抗的过程中看是否能达到某一目标,达到类似培训的效果。类似在司法的场景目前就比较多,因为最近失信的案例多,需要招聘扩充司法团队,就需要快速提高员工素质。

-

语音通话升级到视频的过程中解决了用户看的问题了,但是在看的过程当中,客户会需要收集一些业务字段,比如说地址,出险的位置,那在视频过程中把语音抽离出来,传给大模型,然后再去提炼修正内容,再填到某个具体的字段。 -

那这样在沟通过程当中,各种填表过程不需要人工来去填,大大的提高了接待员的工作效率。以往大概需要 15 分钟,通过这种方式 10 分钟以内就可以的。 -

除了文字客服,现在在音视频客服中,也可以加入中英翻译互动。

-

相比较以前传统的外呼机器人,如果不理解用户,就会回到主流程。但对于 Retail.AI,我可以问他,你可以为我唱一首歌吗?他会在理解我的基础上回答我的问题,然后他并不一定是直接回答,而是会转到他主要的目标。但是能做到给人的体验很流畅。 -

不像传统的机器人,比如我接一个电话,问了一个稀奇古怪不相关的问题,然后我直接能感觉到这是一个机器人没命中,然后对话就结束了。 -

Retell.AI 的这个产品,很难感受到它是一个机器人,它可以在对话的同时保有它的目标性。比如他要做一个预约,在他没有得到这个问题的确认之前,他一直会坚定这个目标去跟你对话。他不会让顾客直接感觉到是「命中」还是「没命中」。

-

例如 Hume.AI 做了一套直连系统,国内如果复现也就是 15 个人团队+3 个月时间,搭一套 TTS+ASR+LLM。 -

更多还需要依靠 GPT 的每一代版本做优化,不过未来很可能模型在迭代过程中就把 AI 客服的一部分功能也给优化掉了。 -

最后落地效果,非常取决于 AI 客服公司的优化能力,光是 Prompting 远远不够。

02

大模型落地呼叫中心的难点

最大的难点是呼入的理解

-

无论什么 LLM 方案,在呼入理解上做得都不是特别好。文本短的理解不够好,再叠加音频识别上的误差,以及很多极端口音的差别。特别方言在国内是个非常大的问题,国内的方言和极端口音太多了。 -

还有一些更细节的东西,比如情感,然后背景环境,都会对生成的内容有一定的影响,尤其是报警的场景。提高理解能力可能是未来很长一段时间要去做的事情。 -

从上一代 AI 产品来看,小模型的方式相对比较生硬,且超过范围的内容,如果流程设计的不够合理,或者没有兜底方案就比较生硬,给用户的挫败感比较强。这种情况,人其实不想使用这样的服务了,就直接就说我转人工,然后其实就增加人力成本了。LLM 虽然理解能力还需要完善,但在这块的提高空间很大。 -

上下文的关联。我们在沟通的时候,它实际上是跳跃的,可能临时想到某一个问题,所以上下文的关联实际上也是比较大的痛点。目前这种多轮对话的处理上比较生硬。

-

比如说有些场景并不是需要去理解它,而是需要精准的命中,传统的关键词的识别有它的优势,而不是说大模型的理解可以解决所有问题。 -

客户在配置的时候就选择在这个节点上,它到底是要用这种精准的识别,还是要用理解型的这种识别?这也会增加客户的部署难度。

-

流程画布是很多客户的需求,流程做到业务人员的自主可控,实际上是比较重要。如果频繁的乙方到企业里交互调整流程,服务成本太高。大模型和行业结合,与这种行业的库结合实际上比较重要。客户一般一大半的场景都需要 Workflow。 -

部分行业有非常明确的专业性要求。比如金融保险,很多有法律方向的专业性诉求,而且它一定是在企业需求下,某一个特定的框架下的。比如两个不同的保险公司,产品范围和条款的专业性都不同。 -

部分行业有非常明确的准确性要求。如医疗保险领域,它需要针对特定行业,精准的给到客户回答,甚至回答受到银保监会的监管,不能有任何给用户产生理解上的偏差。 -

同时需要考虑如何降低客户的学习成本。大型项目还好,会匹配运营人力。但小型项目,他需求可能是一个 Excel 或者是个自然语言,然后再把它转化成 workflow。但是如果一些客户它自助化的使用,它只是一个小规模的 workflow,那就要考虑客户产品体验的问题。

-

海外很多 LLM 落地 IVA 的流程要 7-9 个月时间,中间涉及到部署人力不够,以及大量的数据清洗、适配 Workflow、Finetune 工作。 -

还要涉及数据冷启动,很多客户的客服信息在知识库内不够结构化,可能同时有文字、视频,或者散落在各个地方。以嘉宾的经验为例,需要通用的 RAG 产品对文档做理解。

-

如果用户主动找企业来去解决问题的。那可能我延迟速度是有一定的预期和容忍度的,当然不好的情况下可能也会转人工。 -

呼出的场景下,如果是做通知,或者预约,用户可能也会有一定的包容性。 -

营销场景下,那要求肯定非常高。人都不一定可以,更何况是个机器人。除非做到 Retail.ai 那种感觉,你完全就感受不到这是个机器人。 -

如果是营销场景,他可能一开始就要吸引你,比如是个非常好听的无法拒绝的声音,那有可能可以有多轮的对话,才能持续转化。在很多延迟场景,800ms 以内算比较理想,400ms 以内算很优秀。如果到视频场景,延迟可以放得更宽。

-

ASR 能够识别方言,但发现当用户说话的时候,需要先给他配置一个引擎的参数,得先识别粤语,或者是识别中文,识别其他的这个语言,再去传递一个参数,但其实人在自然对话的情况下,随时有可能切换成方言或者英文。 -

在 ASR 上的探索还有很长距离,甚至作为产品经理也会疑惑,为什么这里学术界还会缺很多细节研究。

03

LLM TTS 的经验和难点

-

看到 TTS 能够在海外落地的一些场景。比如 Y Combiner 在 2024 年投了至少三家做客服的团队,Toma.AI,Retail.AI 和 Mars Lab。所做的东西其实都都比较类似。 -

介绍下 Toma.AI 和 Mars Lab。在美国的披萨店和肯德基这类,类似于车速达这种业务,去拿外卖的模式。用户打电话给店铺说我要什么样的披萨。AI 再做一些简单的询问,然后把这个单下了。然后还有一个场景是牙医预约,比如今天牙齿不舒服了?用户给客服介绍一下情况,然后 AI 客服给你找时间,反馈给医生。这些全部都是 AI 做的。 -

前面介绍的 Retail.AI,是 AI 提前生成好对话,通过很多的电话线路,外呼打推广电话,每天可以打几千通。这是我看到的 TTS 在做客服场景的优化。

-

停顿是独立于前两者之外的一个东西,它其实是想要增加控制力。普通的玩家他们做 TTS 的时候,想在这里控制停顿,就加一个控制停顿的东西到模型里。但是传统的 TTS 也有这个功能,只不过没有放到模型里就会显得比较生硬,会突然就停下了,不是很自然,所以,把它放模型里发现效果会变好。 -

语气词和笑声是一种情感的表达,也是非常常见的人会发出的声音事件。这两个方面之前大家在 TTS 上的探索是比较少的,仅限于学术上的研究,比如一个开源的库。这种能够即开即用的产品做的比较少。学界研究里,它叫 Spontaneous TTS,只不过一直都没有做的比较好,然后放到大模型里面发现好像性能有些提升。 -

第三部分是在 ChatTTS 的模型输入内容后,它会过一个语言模型,把说话的内容口语化,其实这是一个纯的 LLM 任务,和 TTS 没有任何关系。所以就不看 break 了,break 其实是给一个离线 TTS 用的。拟真度一方面是刚才说的语气词和情感,另一方面需要把文本对齐到口语的状态。ChatTTS 觉得更重要的是大家平时没有对齐到口语状态,因为输入是按照很书面的说法把文本输进去,如果不做口语化的转换,效果肯定不好。 -

所以未来在 LLM 这一块还是有些东西可以做的。拟人度上可多加一些拟人化的预训练,或者在生成这种对话的时候,要在 prompt 上说明你应该是什么样的说话语气。 -

声音事件要继续去丰富。情感目前只有 laughter 开心。可以加上伤心,语气词现在只有嗯、啊,也不是特别全面的语气词。还有时候人会把一句话说两次,或单词说到一半,然后卡住再说一遍,这些都要加上。 -

在延迟和推理速度的优化方面,其实相对比较简单。包括 GPT-4o 的演示,他一开始会给你说一些废话,比如」嗯,让我想一想类似这种东西」。那你只是加一段这样的文字,首 Chunk 就可以压到非常低。这并不需要你真正去思考,开始出现正式的文段,而是在前面插一些这种文字,就会给人一种好像他的首 Chunk 非常快的感觉。

-

有常见的词汇去打断他。还有语气控制,安静,语气急促,加上闭嘴,他很快就知道他要打断。 -

主要要把这个任务跟 ASR 任务放到一起去训练。其实更多是规则如何制定,确实需要找很多语料,找类似的 pattern,需要很多人去标注。

-

ChatTTS 才拿到融资,然后在去想之后要去做一个什么样的东西。 -

之前觉得 TTS 独立厂商是有机会的,因为它是相对来说比较小的市场,要和大厂做一些简单的差异化,或者大厂愿意把它集成到自己的产品,比如字节前段时间 TTS 接到剪映,或者直接上抖音,不会单独拿出来卖。像这种情况,觉得是有机会的。 -

这段时间很多 VC 就在市场上找各种各样的做语音 TTS 小公司的机会,所以现在可能 TTS 也会像 LLM 一样去卷一波。比如字节,OpenAI,阿里等,会像早期那种百模大战一样。 -

独立厂商的机会就是要去找一些 TTS 场景的差异化。无论你做任何一个大模型,都是先要一个模块去优化,比如说先优化这个外呼场景,那么别人如果没有优化外呼场景,他一定是做不过你的。类似的或者你去优化一个教育场景等。所以你可能先要去找一些独立的场景,然后把它做好。 -

6 个月之后主要场景都优化过了。如果有 4- 5 家左右的 TTS 厂商的话,今年年底就能达到这个状态。最后要考虑做产品,像 Elevan lab 他们也在积极的转型,感觉最后大家都得去做产品,如果只是卖 TTS 的 API,很快大家都打成平手,就像现在大模型一样。

-

LLM 这两年持续降价,有模型优化的原因,也有行业竞争的原因。特别 LLM 属于空间特别大的行业。 -

语音相对小众,在 NLP 时期就远没有 NLP 热度高。到了 LLM 时期,给包括 ElevenLabs 等留了很大的空窗期,甚至现在做 AI Voice Agent,ElevenLabs 占成本 70%,NLP+数据库占成本 20%,网络带宽占成本 10%。

04

Voice Agent 和语言大模型的其他场景

-

语言学习相关。当时 4O 能够直接理解语音之后,以后口语可以很好的练习了。比如,之前学日语或者英语的时候都用多邻国,它的方式是教你」欢迎开头的打招呼怎么说呀?」「数字怎么说呀?」。以后语言的学习可能就不是这样了,语言学习应该就是一个对话式的学习,不需要再按照各个章节去学习了,这个是会有一个很大的影响。 -

销售需求理解。做公有云的产品,工作中会遇到客户过来,他的第一反应是直接通过一段自然语言,一段话,来表达他对业务的思考和想法,他的需求需求,我们就需要人去理解他的需求,怎么适用到我们的产品,能不能帮助客户解决这个问题,有没有匹配这个需求。以后 AI 可以帮助我们更好的去理解我客户需求,甚至是说直接就自助化的让客户理解我们的产品,而不需要很重的售前去解释。 -

心理咨询。可能除了情感陪伴之外,以后会往更专业的方向去做心理辅导。因为很多人都会有心理上需要倾诉,需要专业解答的阶段,那这个时候他需要助理帮助他解决这样的问题 -

除了传统的客户服务之外,在银行、电信政务其实有一些需求,比如应急或者警报,自然灾害的应急响应。比如说快速的通过号码,或者视频进行外呼。 -

在法律行业,和用户沟通或者提高他的催收效率,也可以通过 voice agent。比如和别人沟通他欠了多少钱,以及其他相关案例去说服对方等场景 -

生活上,旅行的时候基本上会用 voice agent 做日常规划,或者临时性的安排,另外包括开车的过程中的智能化,还有智能家居的互动操作场景等。 -

游戏陪伴。游戏分类别,像国内的恋与深空,里面的男角色会给用户打个电话,TTS 其实已经满足了这个要求,也不用再做什么复杂的改进。还有一类像永劫无间手游,会有一个 AI 队友跟你互动,比如说你杀了一个敌人,他会跟你说你,因为你好厉害啊,你看你好牛啊。对游戏画面的要求目前还没有看到。

-

之前海外有一款产品叫做 limitless.AI,挂在人身上,像一个收音器一样。每天会总结你的对话,然后分析一下这个人今天说的话。这个在海外卖的挺好的,因为它确实是有价值,而且平时也需要录音。 -

相当于把生活当中所有的信息转录出来,然后再对自己的一天做总结,再做规划。光是这一个场景就应该付费意愿是很强了。 -

理赔场景也是这样的需求,现在的做法还是有中间转的过程,然后实时性上会损失一些,如果能把这个语音直接接入到模型里,直接输出相关结果,更及时性一些。肯定是市场需求。

05

呼叫中心:5G,视频化

-

5G 的支持首先是音频的提升增强。然后 97% 安卓手机可以支持视频通道。安卓手机打电话有三个按钮,即语音按钮,短信按钮,和视频按钮,这个实际上就是一个视频通道。 -

95% 的人在遇到问题情况下,支持在电话上一键升级到视频,方便度会有显著提高。最近我们中标了很多 5G 相关项目。其中一个机会点是传统的语音在一部分场景下是不能满足用户需求的,比如说车出险的过程中,如果是人保的话,会打个 9518,然后人过来了以后,后端有多个岗位的人在服务我们,比如说他们记录一个班号,班号有客服,视频团队,查勘的,定损的,推修的,甚至如果车损比较严重的时候,还要和第三方合作。这里边有大量的需要视频的场景,比如视频的定损,智能定损,拆车过程记录,多人沟通场景(公众空间),这样场景里边它有音频、有视频等 -

同时这个技术拉齐视频不需要装任何 APP。所以普及性会很高。我们在实施这个项目的过程当中,因为客户以前是上了一些视频平台的,但为了整合各个系统,会有做统一,比如统一路由、统一排队、统一报表类似这样的需求。 -

当中也会遇到问题,比如网络会有延迟,视频传输如果 480 的话大概需要一兆左右,如果是 720 的话需要两兆,并不是所有的带宽都能够保证足够。不过目前运营商也在提高带宽,并发数量也在指数级里增加。比如以前它能支持 500 个到 600 个并发,现在可以支持 2 万 1 万个并发。 -

另外还要解决终端的适配,比如华为手机的兼容性可能会好一些,OV 的兼容性稍微弱一点,小米的一部分机型支持的很好,一部分机型支持不好。另外是运营商的信令,三大运营商的信令还不太一样。 -

随着 5G 的技术的发展,高速度、低延迟的增强,会对转 voice agent 或者是 video agent,或者是 CC 这一块会有很大的促进。这个过程也需要做丰富的交互,加上视频后,对于交互的响应度要求更高,因为我不光是听见,我还要能看见,还不绿屏、不花屏。所以这块要求会增加,我们现在和运营上一起逐渐解决这些问题。

目前 SIP 视频线路的客户都在增加。有一些场景需要在电话的通道里,把视频拉起来,技术方案是 VRote 或者 5G,要运营商调 SIP 视频,类似的需求目前是数量级的在增加。