包阅导读总结

1. 模型崩溃、AI 生成数据、无意义内容、数据过滤、机器学习

2. 牛津大学研究发现,用 AI 生成数据二次训练大模型会导致模型崩溃产生无意义内容。现有缓解方法如添加水印存在问题,行业需建立有效数据过滤手段,网友对这一现象看法不一。

3.

– 模型崩溃现象

– 牛津大学研究团队发现用 AI 生成数据集训练未来模型可能产生无意义内容。

– 如模型从关于中世纪欧洲建筑文本到谈论野兔的胡言乱语。

– 原因与影响

– 可能无法捕捉不太常见文本行,基于此的后续模型无法继承细微差别,导致递归循环。

– 以生成狗图像系统为例,常见犬种过度代表,稀有犬种被遗忘,最终模型崩溃。

– 缓解方法与问题

– 现有方法如添加水印,易移除且需大量协调,实践中可能不可行。

– 行业需建立有效数据过滤手段,区分 AI 生成数据与其他数据。

– 网友看法

– 认为是数据的“第二定律”,存在“垃圾进,垃圾出”现象。

– 有人认为问题在于整个问题域,也有人认为 LLMs 目的合理但应用价值有争议。

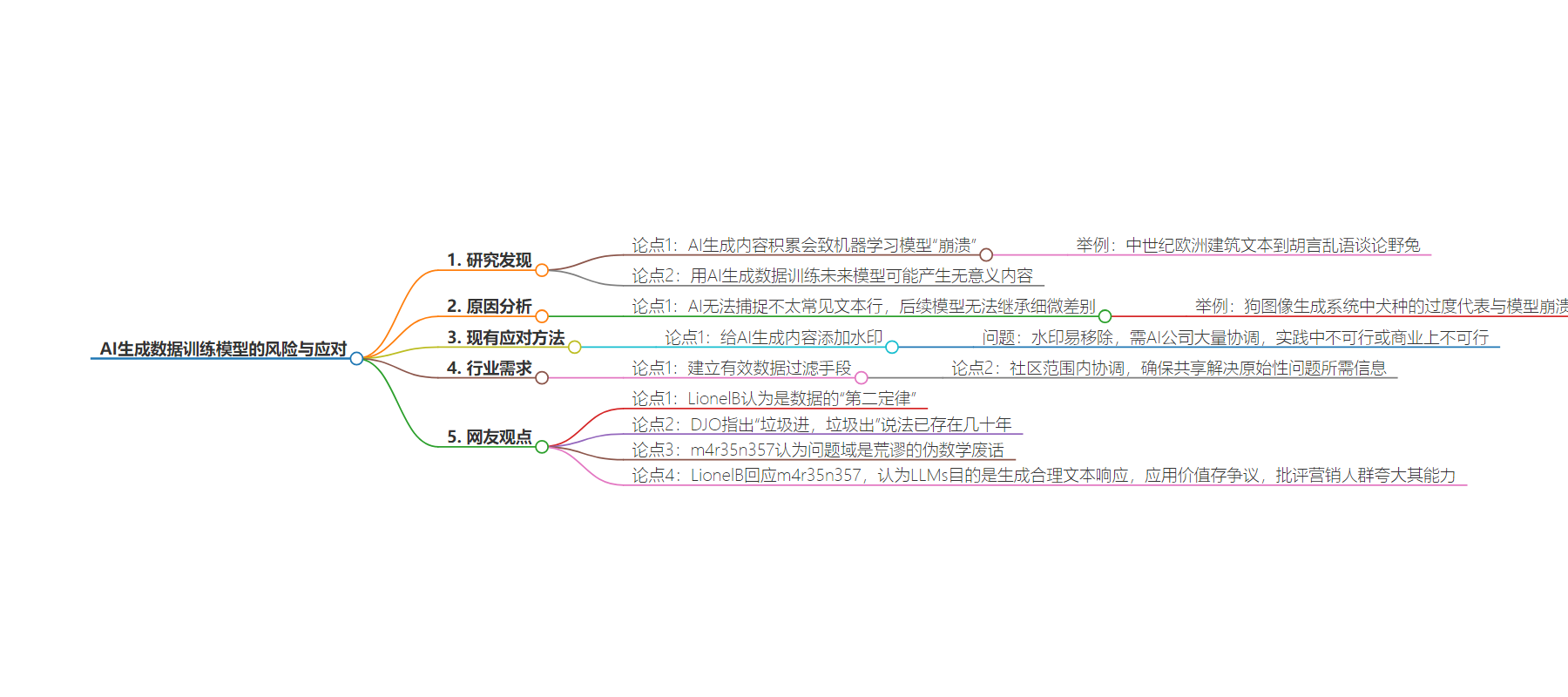

思维导图:

文章地址:https://mp.weixin.qq.com/s/nT9T6Up9VUAmFBrPSZgbhA

文章来源:mp.weixin.qq.com

作者:51CTO技术栈

发布时间:2024/7/29 3:57

语言:中文

总字数:1545字

预计阅读时间:7分钟

评分:87分

标签:模型崩溃,AI模型训练,数据质量,牛津大学,数据过滤

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

编辑 | 星璇

研究人员发现,网络上AI生成内容的积累将导致机器学习模型“崩溃”,除非该行业能够缓解这一风险。

牛津大学的研究团队发现,使用AI生成的数据集来训练未来的模型可能会产生无意义的内容,这一现象被称为模型崩溃。在一个例子中,一个模型起初是关于中世纪欧洲建筑的文本,但到了第九代时,却开始胡言乱语地谈论野兔。

在昨日发表于《自然》杂志的一篇论文中,由谷歌DeepMind和牛津大学博士后研究员Ilia Shumailov领导的研究表明,AI可能无法在训练数据集中捕捉到不太常见的文本行,这意味着基于这些输出训练的后续模型无法继承这些细微差别。以这种方式训练新模型会导致递归循环。

“对语言模型的长期中毒攻击并非新鲜事物,”论文指出。“例如,我们看到了点击、内容和欺诈工厂的创建,这是一种人类‘语言模型’,其工作是误导社交网络和搜索算法。这些中毒攻击对搜索结果产生的负面影响导致了搜索算法的变化。例如,谷歌降低了来自这些工厂的文章的排名,更加重视来自教育等可信来源的内容,而DuckDuckGo则完全移除了这些内容。与LLMs(大型语言模型)的出现不同的是,一旦自动化,这种中毒可以发生的规模。”

举例:什么是模型崩溃

在另一篇配套文章中,杜克大学电气与计算机工程助理教授Emily Wenger用一个生成狗图像的系统为例来说明模型崩溃。

“AI模型会倾向于在其训练数据中重新创建最常见的犬种,因此可能会过度代表金毛寻回犬,而相对于更罕见的比熊格里芬凡丁犬,”她说。

“如果后续模型是在过度代表金毛寻回犬的AI生成数据集上进行训练的,那么问题就会加剧。经过足够多的循环,模型将忘记比熊格里芬凡丁犬等稀有犬种的存在,并只生成金毛寻回犬的图片。最终,模型将崩溃,无法生成有意义的内容。”

虽然她承认过度代表金毛寻回犬可能并非坏事,但崩溃的过程对于包含不太常见想法和写作方式的有意义代表性输出来说是一个严重问题。“这是模型崩溃的核心问题,”她说。

缓解这一问题的一个现有方法是给AI生成的内容添加水印。然而,这些水印可以很容易地从AI生成的图像中移除。共享水印信息还需要AI公司之间进行大量协调,“这在实践中可能不可行或商业上不可行,”Wenger说。

Shumailov及其同事表示,使用AI生成的数据来训练模型并非不可能,但行业需要建立一种有效的数据过滤手段。

“需要将LLMs生成的数据与其他数据区分开,这引发了关于从互联网上抓取的内容的原始性的问题:目前尚不清楚如何在大规模上追踪由LLMs生成的内容,”论文指出。

“一个选择是社区范围内的协调,以确保参与LLM创建和部署的不同方面能够共享解决原始性问题所需的信息。否则,如果没有在LLM技术大规模应用之前从互联网上抓取的数据或大规模直接访问由人类生成的数据的权限,训练LLM的新版本可能会变得越来越困难。”

万能的网友:这是数据的第二定律

网友们对此纷纷吐槽:

-

LionelB:认为这一现象早在ML圈中就已知,并将其比作数据的“第二定律”。 -

DJO:指出“垃圾进,垃圾出”的说法已经存在了几十年。 -

LionelB(再次):认为即便原始输入并非垃圾,输出也可能因迭代应用损失性算法而变得无意义。 -

m4r35n357:认为问题不在于输入或算法实现,而在于整个问题域本身是荒谬的伪数学废话。 -

LionelB(回应m4r35n357):认为LLMs的目的是生成与查询相关的人类般合理的文本响应,并非伪数学,但认为其应用价值仍存争议。同时批评营销人群过度夸大LLMs的能力。