包阅导读总结

1. 关键词:NIST、AI 模型、安全、指南、风险缓解

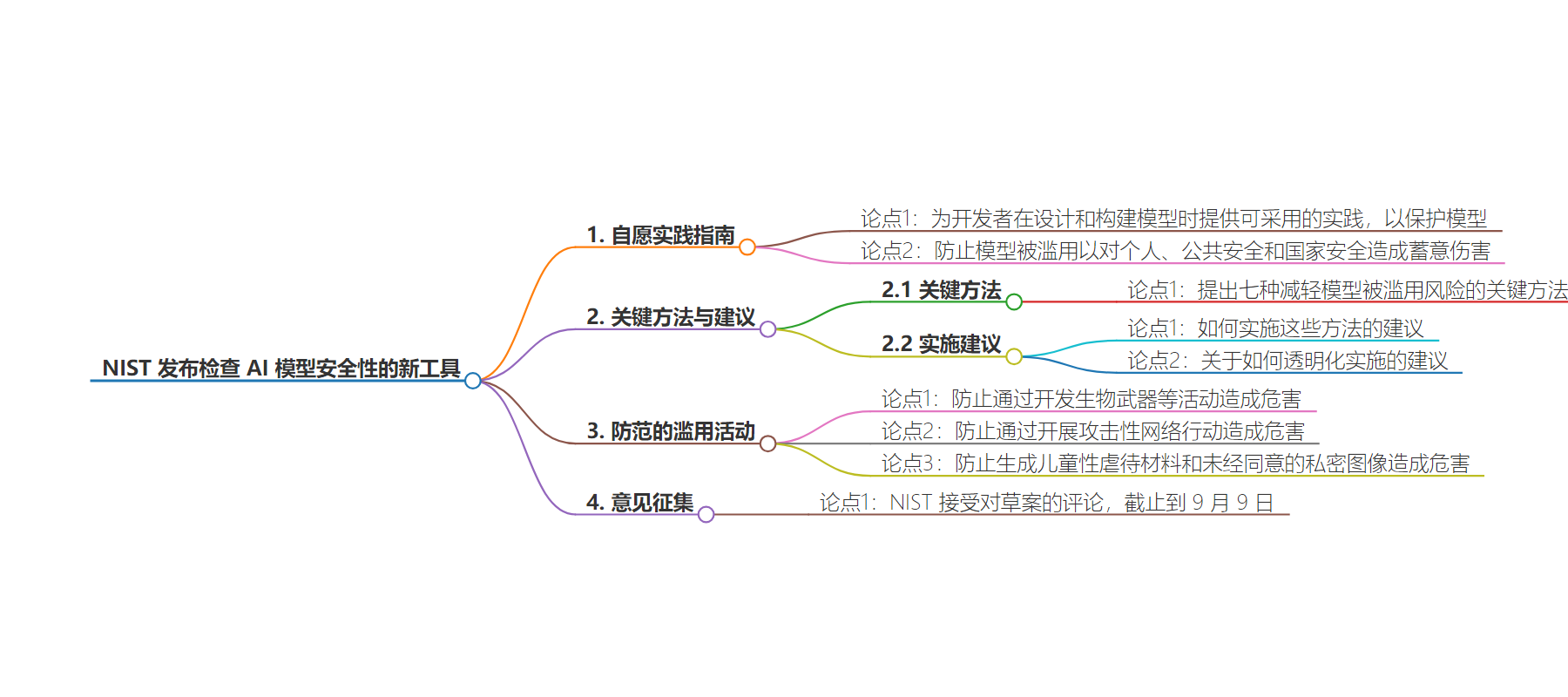

2. 总结:NIST 发布新工具以检查 AI 模型的安全,其指南提出自愿实践供开发者采用,草案提供七种关键风险缓解方法,就实施及透明化给出建议,NIST 接受对草案的评论至 9 月 9 日。

3. 主要内容:

– NIST 发布新工具检查 AI 模型的安全。

– 指南概述了开发者在设计和构建模型时可采用的自愿实践,以保护模型不被滥用从而对个人、公共安全和国家安全造成蓄意伤害。

– 草案提供了七个关键的风险缓解方法。

– 包含关于如何实施这些方法及如何透明化实施的建议。

– 举例说明防止模型被用于制造生物武器、进行攻击性网络操作、生成儿童性虐待材料和未经同意的私密图像等有害活动。

– NIST 接受对草案的评论直至 9 月 9 日。

思维导图:

文章地址:https://www.infoworld.com/article/3478308/nist-releases-new-tool-to-check-ai-models-security.html

文章来源:infoworld.com

作者:InfoWorld

发布时间:2024/7/29 8:16

语言:英文

总字数:619字

预计阅读时间:3分钟

评分:88分

标签:人工智能安全,Dioptra,NIST,对抗性攻击,人工智能风险管理

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

The guidelines outline voluntary practices developers can adopt while designing and building their model to protect it against being misused to cause deliberate harm to individuals, public safety, and national security.

The draft offers seven key approaches for mitigating the risks that models will be misused, along with recommendations on how to implement them and how to be transparent about their implementation.

“Together, these practices can help prevent models from enabling harm through activities like developing biological weapons, carrying out offensive cyber operations, and generating child sexual abuse material and nonconsensual intimate imagery,” the NIST said, adding that it was accepting comments on the draft till September 9.