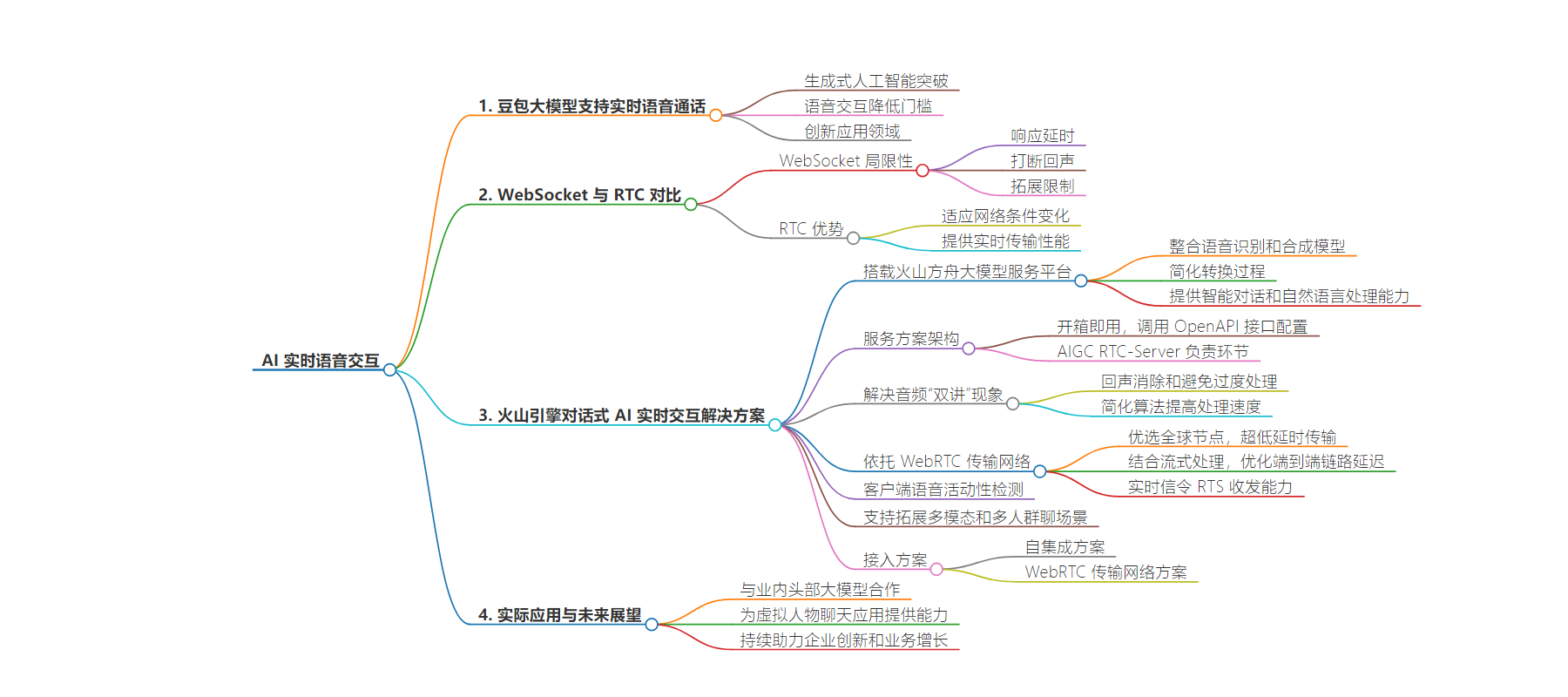

包阅导读总结

1. 关键词:豆包大模型、语音通话、RTC 技术、实时交互、火山引擎

2. 总结:豆包大模型支持实时语音通话,AI 实时语音方案采用 RTC 技术更优,火山引擎推出相关解决方案,具备多种优势和接入方案,助力企业实现高质量 AI 实时语音场景创新。

3. 主要内容:

– 豆包大模型支持实时语音通话,语音交互降低与 AI 对话门槛,诸多领域出现相关创新应用

– WebSocket 用于构建语音对话有局限性,如响应延时、打断回声、拓展限制等

– 火山引擎推出对话式 AI 实时交互解决方案

– 搭载火山方舟大模型服务平台,整合语音识别和合成模型

– 服务方案架构开箱即用,简化开发流程

– 解决音频“双讲”问题,实现全球超低延时传输

– 支持多模态和多人群聊等场景

– 提供自集成方案和 WebRTC 传输网络(WTN)方案等接入方式,助力企业创新

思维导图:

文章地址:https://mp.weixin.qq.com/s/1rOJ1icv5wct218hjF3-kg

文章来源:mp.weixin.qq.com

作者:面向AI时代的

发布时间:2024/8/14 7:21

语言:中文

总字数:2505字

预计阅读时间:11分钟

评分:94分

标签:AI 实时语音,火山引擎,RTC 技术,多模态交互,语音识别

以下为原文内容

本内容来源于用户推荐转载,旨在分享知识与观点,如有侵权请联系删除 联系邮箱 media@ilingban.com

生成式人工智能正以令人惊叹的速度实现突破,像与 ChatGPT、豆包这类 AI 智能助手对话,不再局限于文字,也可以通过语音通话进行实时、生动的交流。语音是人类最自然便捷的沟通方式,语音交互大幅降低与 AI 对话的门槛。人们只需说出需求,AI 就能快速理解并反应,无需复杂的操作,都在简单的话语中。

在这一趋势推动下,诸多领域出现 AI 实时语音创新应用,如 AI 社交陪伴、AI 口语学习、游戏 AI NPC 及 AI 呼叫中心等。这些应用既展现 AI 技术潜力,也体现人们对更自然、更丰富的 AI 交流体验的期望。

我们与 AI 交互的流畅度和效率,不仅取决于大模型毫秒级的理解生成能力,还依赖于所选择的网络传输技术。起初,开发者鉴于 WebSocket 广泛的应用及普及性,常常选用它来构建语音对话。但随着方案的演进以及用户需求的提升,其局限性也逐渐展露:

打断回声:我们发现当前主流 AIGC 语音通话应用少有能实现用户随时打断,体验上更像“对讲机”而非“打电话”。因为用户在智能体输出时讲话,会混入智能体的回声,导致用户所说内容无法准确识别。

拓展限制:WebSocket 对于视频或多人交互场景显得“力不从心”。视频比音频使用更多的网络带宽,丢失和延迟的数据包也会更频繁;随着交互个体的增多,音视频流的发布和订阅管理也变得更加复杂。

为了提供更流畅自然的用户体验,适应大模型向多模态方向的快速发展,AI 实时语音方案采用实时通信(RTC)技术更为合适。RTC 技术能够更好地适应用户网络条件的变化,提供更优的实时传输性能。

火山引擎推出对话式 AI 实时交互解决方案,搭载火山方舟大模型服务平台,通过火山引擎 RTC 实现语音数据的高效采集、处理和传输,并深度整合豆包·语音识别模型和豆包·语音合成模型,简化语音到文本和文本到语音的转换过程,提供卓越的智能对话和自然语言处理能力,帮助应用快速实现用户和云端大模型的实时语音通话。

豆包·语音识别模型:更高的准确率及灵敏度,更低的语音识别延迟,支持多语种的正确识别。

火山方舟:提供模型精调、推理、评测等全方位功能与服务,提供丰富的插件生态和 AI 原生应用开发服务,全方位保障企业级 AI 应用落地。

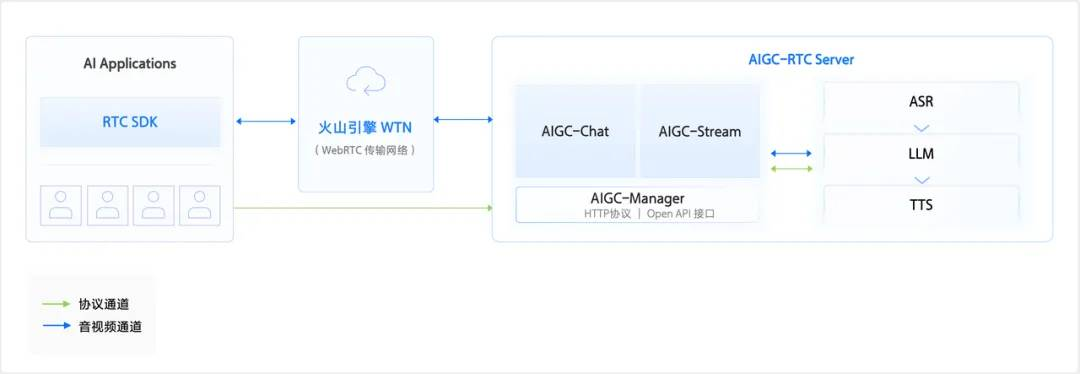

对话式 AI 实时交互服务方案架构

开箱即用快速搭建,只需调用标准的 OpenAPI 接口即可配置所需的语音识别(ASR)、大语言模型(LLM)、语音合成(TTS)类型和参数。而火山引擎 AIGC RTC-Server 负责边缘用户接入、云端资源调度、文本与语音转换处理以及数据订阅传输等环节。整体简化开发流程,让企业应用更专注在对大模型核心能力的训练及调试,加速 AI 实时语音场景创新。

要让与 AI 的交流像和朋友一样自然,随时打断甚至直接插话,关键在于:当用户和 AI 同时说话时,如何解决互相干扰的音频“双讲”现象。火山引擎 RTC 基于成熟的音频 3A 处理技术,针对“双讲”通过传统回声消除算法和深度学习算法的结合,不仅有效去除回声,还能避免用户语音被过度处理,确保云端语音识别(ASR)能准确捕捉和识别用户的语音信息。此外,火山引擎 RTC 通过简化算法提高处理速度,避免因算法复杂性带来的额外延时。

AI 实时语音

火山引擎 RTC 依托于 WebRTC 传输网络(WTN),优选全球海量优质节点,实现全球用户智能接入和音视频数据超低延时传输,即使在复杂弱网环境下也能保持低延时、高质量的通信能力。同时,火山引擎 RTC 结合云端语音识别流式处理,优化端到端链路延迟,整体响应延时可低至 1s。此外,火山引擎实时信令 RTS 可提供稳定可靠、低延时、高并发的信令收发能力,可对文字信令高效传输。

不受限于 AI 服务部署区域,用户无论身处何地,是语音交流还是文字对话,都可以享受无延迟、流畅的 AI 交互体验。

在方案中,客户端提供音频帧级别的语音活动性检测(VAD),可以精准检测出音频信号中何时有人正在说话,何时是静默状态。帮助整体语音系统更有效地处理语音输入,更准确地识别和理解用户的指令或话语,减少误识别。同时,避免对无意义的背景声进行处理,从而节省计算资源,提高系统的整体效率。

当前人工智能领域创新和突破正以前所未有的速度发生,几乎“每周”都有新的进展。AIGC 交互形态和规模也在快速发展中,如从文字到语音再到视频等多模态,从 1 对 1 到多人多 Agent 互动。火山引擎大模型多模态实时交互服务在支持实时语音基础上,也支持拓展多模态视频对话和多人群聊等场景,帮助开发者能够快速迭代和创新,不断推出新的应用场景和玩法。

对于追求快速部署 AI 实时语音功能的企业来说,火山引擎提供的一站式解决方案,让企业能够专注于打造核心功能和创新,而不必深陷底层技术的细节。此外,火山引擎也提供多样化的接入方案,以满足不同企业在开发应用时的具体需求。以下是另外两种接入方案:

WebRTC 传输网络(WTN)方案:对于在客户端拥有自主研发音视频技术的企业,火山引擎提供了基于 WebRTC 标准协议构建的传输网络(WTN)。通过接入 WTN,企业能够轻松获得全球范围内的超低延迟、稳定可靠的实时音视频传输服务,提升端到端多模态大模型的响应效率。

通过这些方案,企业可以根据自己的技术栈和业务场景,选择最合适的接入方式,实现高质量的 AI 实时语音场景。

火山引擎方案不仅与业内头部大模型合作打造端到端多模态大模型,在 AI 原生应用上,也已为国内 Top AI 虚拟人物聊天应用提供鲜活逼真的 AI 实时语音能力,给用户带来了全新的互动体验。火山引擎将持续以高质量音视频能力、灵活的技术方案和出色的 AI 能力,助力广大企业在 AI 实时音视频领域实现创新,激发业务增长潜能。

点击「阅读原文」,可立即咨询并体验火山引擎对话式 AI 实时交互 Demo。